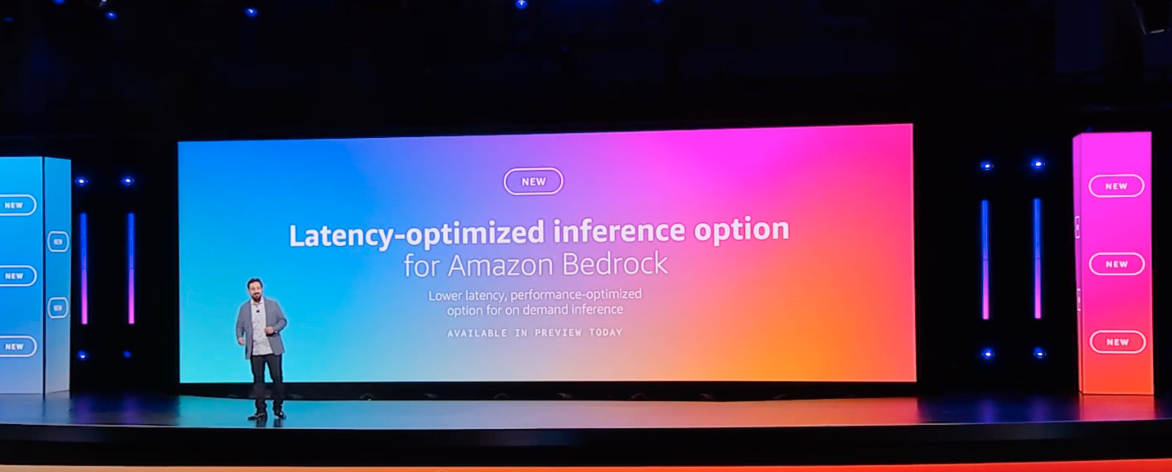

Monday Night Live with Peter DeSantiのキーノートでアップデートの発表がありました!

Latency-optimized inference option for Amazon Bedrockとは

Introducing latency-optimized inference for foundation models in Amazon Bedrock - AWS

Discover more about what's new at AWS with Introducing latency-optimized inference for foundation models in Amazon Bedrock

パブリックプレビュー利用可能になったAmazon Bedrockの基盤モデル向けレイテンシ最適化推論。

AnthropicのClaude 3.5 HaikuモデルとMetaのLlama 3.1 405Bおよび70Bモデルをサポートし、標準モデルと比較して精度を損なうことなく応答時間を短縮。

AWS Trainium2チップと高度なソフトウェア最適化により、リアルタイムの顧客サービスチャットボットやインタラクティブなコーディングアシスタントなど、レイテンシの影響を受けやすいアプリケーションのエンドユーザーエクスペリエンスを最適化。

追加の設定やモデルの微調整は不要で、既存のアプリケーションをすぐに強化できる。

現在は米国東部(オハイオ)リージョンでクロスリージョン推論を介して利用可能。

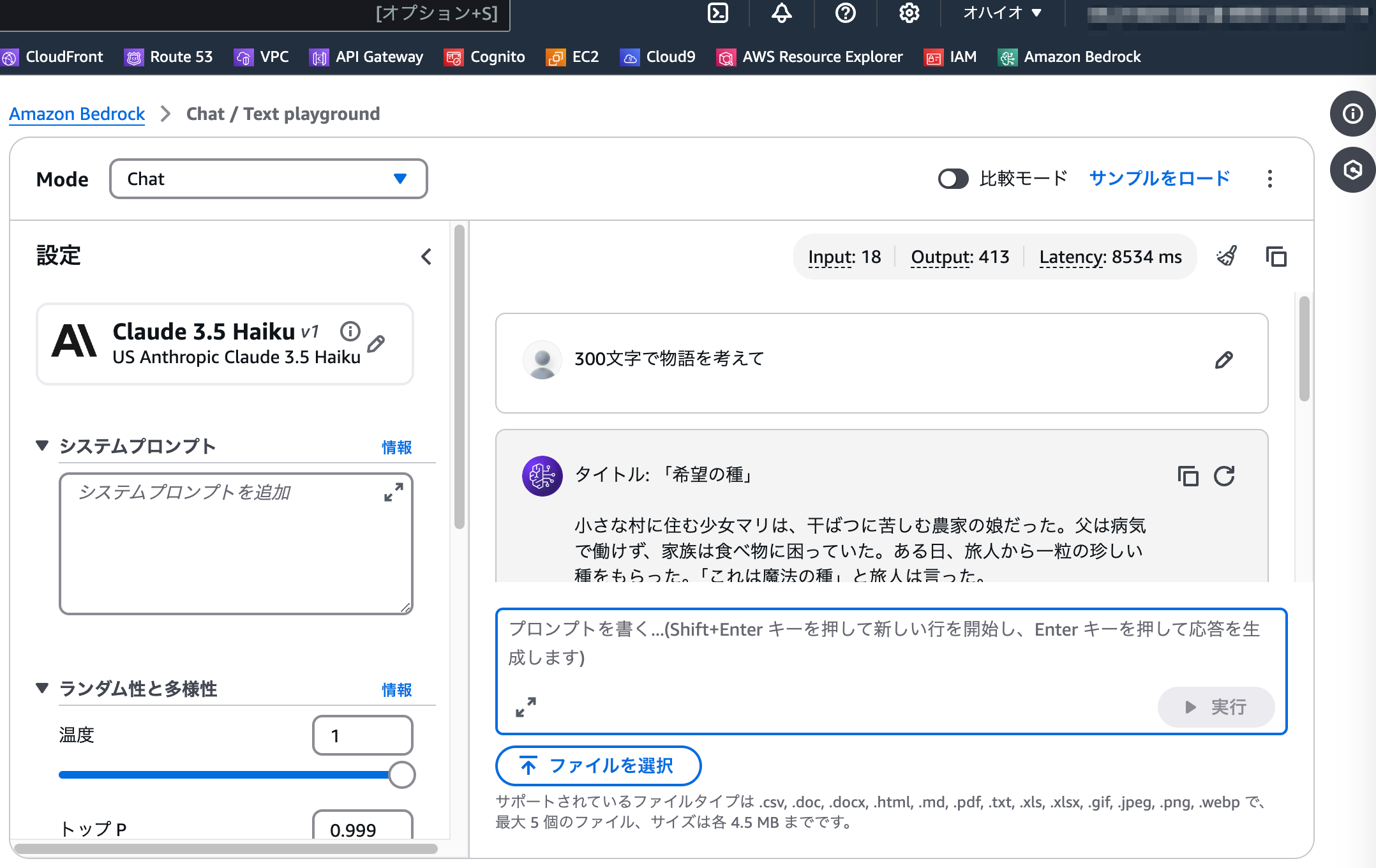

試してみる

てっとり早くマネジメントコンソールからClaude 3.5 Haikuモデルを実行してみます。

バージニア北部のClaude 3.5 Haiku

オハイオのClaude 3.5 Haiku

若干速いかなくらいですが、クロスリージョン推論モデルなので意図していないリージョンに振り分けられてる可能性もありそうです。

Amazon Bedrockがモデル実行環境としてのパフォーマンス優位性をアピールしてきていることがこのアップデートから想像できます。

サードパーティモデルは他のクラウドでも動かせますが、パフォーマンスや周辺ソリューションの観点で優位にたてばそのモデルを使いたいユーザーはBedrockを選定する理由にもなりそうです。

![【AWS re:Invent 2024】Unlocking education equity with AI [IMP102]](https://iret.media/wp-content/uploads/2024/12/eyecatch-130006-220x124.png)

![【AWS re:Invent 2024】Drive business transformation with Amazon Q: Strategy to deployment [AIM212]](https://iret.media/wp-content/uploads/2024/12/eyecatch-130040-220x124.png)

![【AWS re:Invent 2024】AWSでジェネレーティブAIの力を解き放つ[GBL206-JA]](https://iret.media/wp-content/uploads/2024/12/eyecatch-131685-220x124.png)