GlueでVPCフローログをparquet形式に変換させる定期ジョブを作ろうと思いクロール処理を追加したところ、ビルトインのClassifiersにはなかったため自動でテーブル構造を認識してくれませんでした。

認識させるためにはカスタムClassifiersを作る必要があることが分かりました。

今回はVPCフローログ用にカスタムClassifiersの作り方を調べた備忘録です

GlueのビルトインのClassifiersについては、以下のページで確認できます。

ここになければ作る必要があります。

Adding Classifiers to a Crawler – AWS Glue

手順

- Grokフィルタ作成

- classifiersの作成

- 実行確認

Grokフィルタ作成

まずログをマッチングして分類するためのフィルタを作る必要がりあります。

Grokフィルタの詳細についてはここを確認してください。

Grok filter plugin | Logstash Reference [6.1] | Elastic

また、Glueのビルトインパターンについては以下を参照してください。

Writing Custom Classifiers – AWS Glue

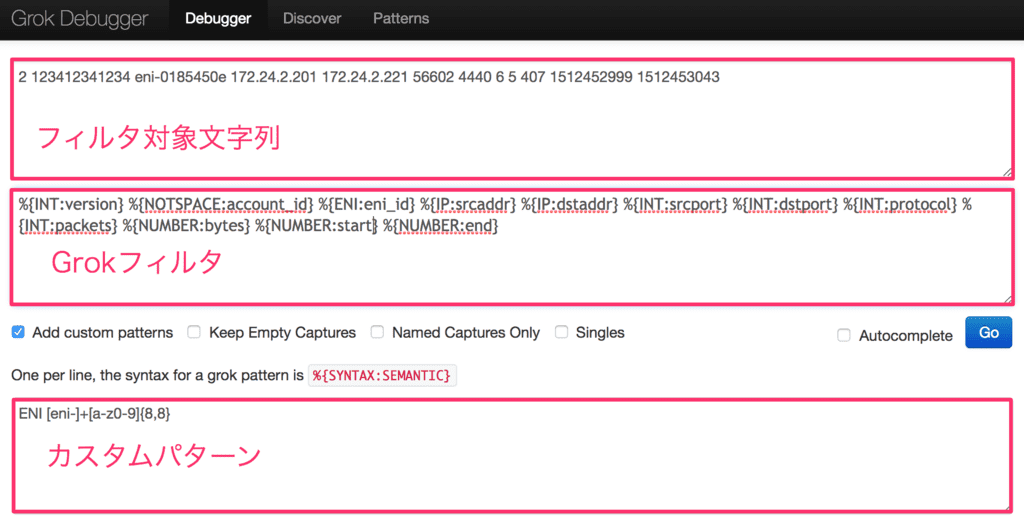

作ったGrokフィルタをcrawlerを使って逐一実行確認していはかなりの時間がかかるため、

以下のサービスを使ってGrokフィルタが想定どおりに動作しているかを事前に確認します。

Grok Debugger

カスタムパターンを作る時の正規表現の確認は、以下のサービスが便利でした

Online regex tester and debugger: PHP, PCRE, Python, Golang and JavaScript

classifiersの作成

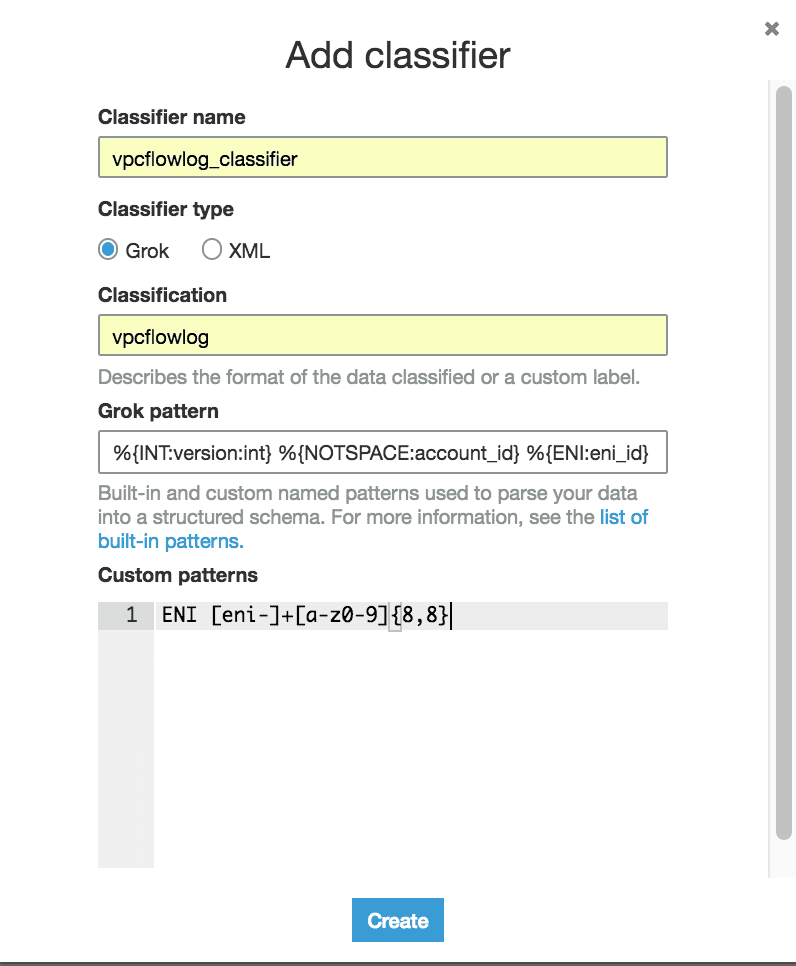

左ペインから「classifiers」を選択し、「Add classifier」ボタンをクリックします。

今回は以下のように入力してCreateします。

classifier name:任意

classifier type : Grok

classification:任意

Grok pattern:

%{INT:version:int} %{NOTSPACE:account_id} %{ENI:eni_id} %{IP:srcaddr} %{IP:dstaddr} %{INT:srcport:int} %{INT:dstport:int} %{INT:protocol:int} %{INT:packets:int} %{NUMBER:bytes} %{NUMBER:start} %{NUMBER:end} %{NOTSPACE:action} %{NOTSPACE:log_status}

Custome pattern:

ENI [eni-]+[a-z0-9]{8,8}

※上記のgrokパターンは適切ではないと思いますが、とりあえずVPCフローログがマッチするはずです

実行確認

上記設定ができれば実際にクロールしてみましょう。

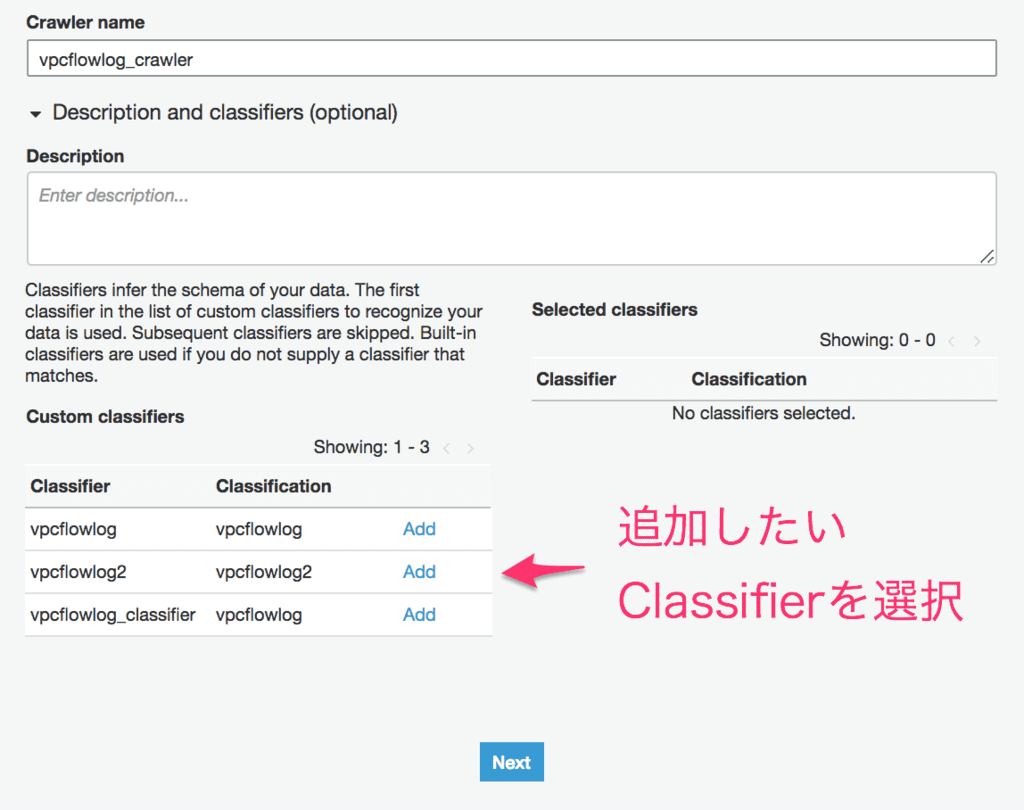

Add crawlerを実行すると以下のような画面になります。

左下のclassifierリストから今回作ったclassifierをAddします。

vpcフローログのあるS3パスを指定して、それ以外は画面に沿って入力しRun crawlerを実行してください。

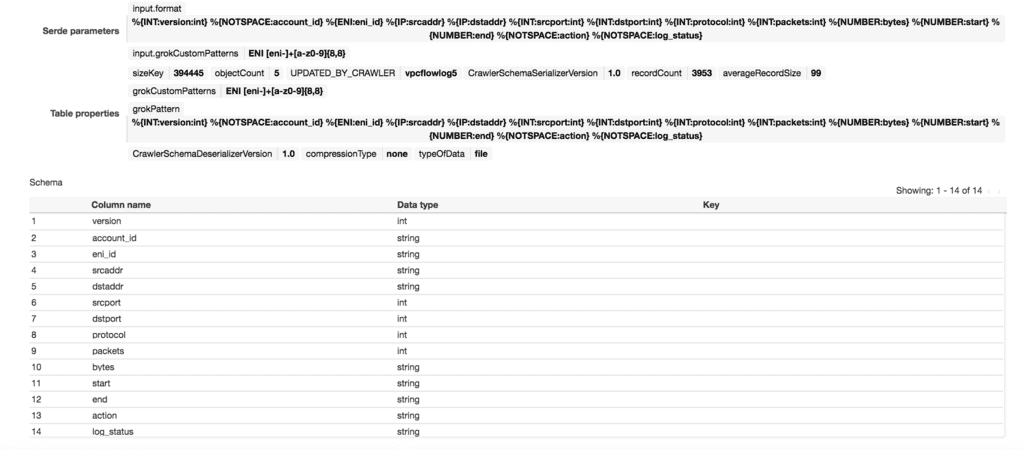

正しく分類できていれば、テーブルの詳細を確認すると以下のようになっていると思います。

うまくいかなかった場合は、ClassificationにUnknownと表示されますのでその場合は修正して再度確認してください。

ただし、classifiersを更新した際は、crawlerを新規に作成しないと反映されないようなので注意してください。

grokフィルタについては、少しクセがあり慣れるのに少し時間がかかりそうですが、Debuggerもあるのでうまく活用して慣れていきたいと思います。

参考

docs.aws.amazon.com