皆さん、こんにちは!アイレット株式会社クラウドインテグレーション事業部MSPセクションの蓮沼翔悟です。

先日、Datadogの年次カンファレンス「DASH」で特に印象に残ったセッション「LLM Observability: Reliability in Phone Communication」を視聴しました。これは、株式会社IVRy(アイブリー)のAIエンジニア兼SREであるHiroyuki Moriyaさんによる講演で、日本における電話コミュニケーションの重要性と、それに対する生成AIの活用、そしてその信頼性確保に向けた具体的な取り組みについて深く学ぶことができました。

このセッションで得た知見は、現在アイレット社内で進めている生成AI活用、そしてその先に見据える信頼性の高いAI活用の未来にとって、非常に示唆に富むものでした。今回は、その内容を振り返りつつ、弊社の取り組みと今後の展望についてもご紹介したいと思います。

1. IVRy社のセッションから学ぶLLMオブザーバビリティの概要

IVRy社は2019年に設立されたスタートアップ企業で、顧客サポートのためのAIとコミュニケーションAIを提供しており、その主力製品はAI自動化サービスです。彼らは、日本において電話が依然として主要なコミュニケーション手段であるという実情に正面から向き合っています。実際、企業の87%が顧客対応に電話を利用しており、そのうち54%が電話対応に何らかの課題を抱えているという調査結果も共有されました。こうした背景から、IVRy社はAI技術を活用した電話代行サービスを提供し、設立から短期間で従業員200名超、アカウント数3万件という規模に成長を遂げています。デモでは、AIアシスタントが電話でレストランの予約を受け付けている様子が示され、その具体的な活用イメージが共有されました。

セッションでは、この生成AIを活用した電話自動応答サービスが直面する主要な3つの課題が挙げられました。

- ハルシネーション(幻覚): AIが事実と異なる、あるいは不正確な出力をしてしまう問題。例えば、レストラン予約で「30人分の部屋はありません」と正確に返答すべきところで、誤って「お待ちしております」と返してしまうようなケースが挙げられる

- 応答遅延: 自然な会話体験を損なう、レスポンススピードの問題。会話が遅すぎたり速すぎたりすると、顧客が不機嫌になり、最悪の場合、別の店に行ってしまう可能性もある

- サービスの不安定性: LLM APIの不具合や停止に起因するシステムの信頼性の課題。システムがダウンした場合、重要な顧客と話せなくなったり、ビジネスチャンスを逃したりする可能性がある

これらの課題に対し、IVRy社は実践的なアプローチで取り組んでいるとのことです。

ハルシネーションと遅延への実践的対処:

- 一つの困難なタスクを複数のステップに分割する「分割」戦略を採用し、より安定した信頼性の高いシステムを構築しています。例えば、AIワークフローの中で、「顧客の意図を分類」し、次に「情報を抽出する」といったステップを踏むことで、制御性と一貫性を確保

- API出力の整合性を確保するため、「信頼するが検証する」というアプローチを取り、毎日APIを監視し、複数のテストケースを用いて期待される出力と比較

- さらに、システムが意図した通りに会話を進めるかを確認するために、電話による自動テストも実施

- Datadogのオブザーバビリティ機能(LLM Observability)を活用することで、APIの入力、出力、トークン数、レイテンシなどを視覚的に確認できるようになり、デバッグ作業が大幅に迅速化された

- 会話の自然さを確保するため、「完璧よりも達成」という考え方を重視し、高速で安定しており、費用対効果の高いモデルを選択している点

サービス不安定性に備える設計(フォールトトレランスと復旧計画):

- メインAPI(OpenAIなど)に問題が発生した場合に、GeminiやAnthropicなどのセカンダリAPIにリクエストをフォールバックする構成

- 最悪のシナリオとして、全APIが停止した場合には、人間オペレーターに電話を転送する緊急連絡先の設定も用意されています。

- DatadogによるAPI入出力の監視体制を構築し、異常検出や分類も実施しているとのことでした。

2. アイレット社内におけるLLMオブザーバビリティの活用

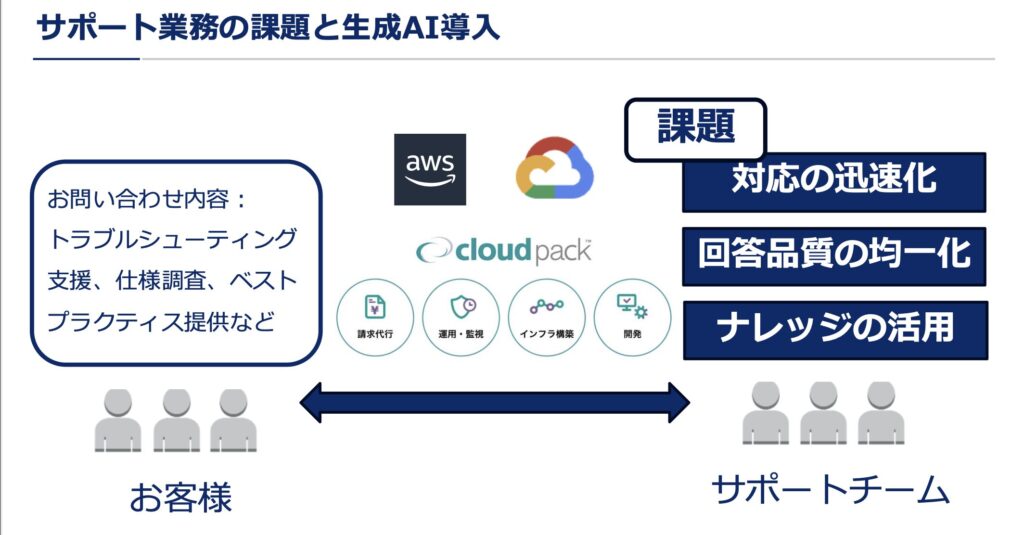

アイレットにおいても、弊社を経由してクラウドを利用するお客様からのトラブルシューティングや使用調査などのお問い合わせに対して、対応の迅速化、回答品質の均一化、ナレッジの活用といった課題に対応するため、生成AIシステムを導入しています。

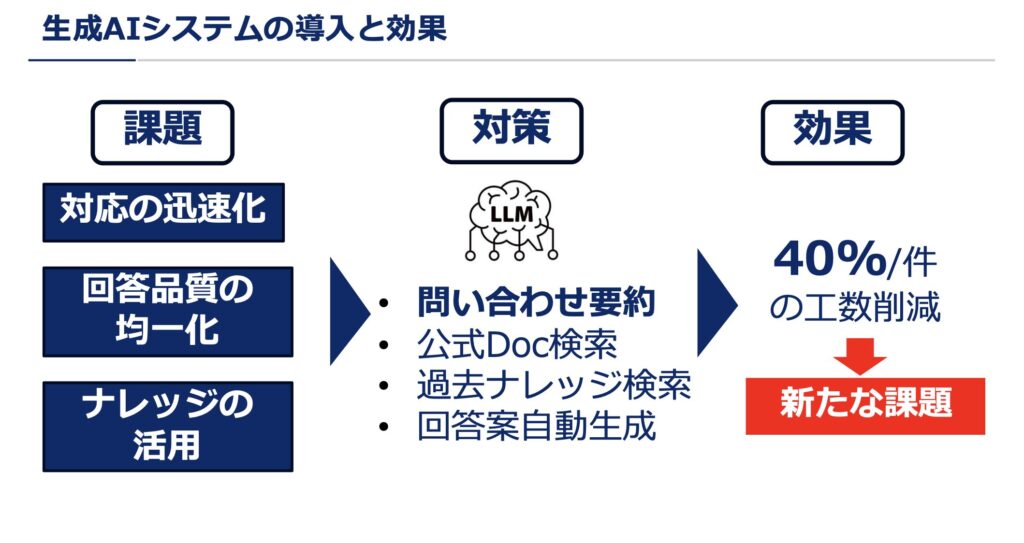

お問い合わせ要約、ナレッジ検索、回答支援機能などによって、対応工数を約40%削減することができました。

一方で、生成AIシステムの運用においては、LLMアプリケーション全体の観測や期待される出力をするかといった精度判定の新たな課題も浮上してきました。これらの課題を解決し、より信頼性の高い生成AIシステムを構築するため、私たちはDatadogの「LLM Observability」を導入しました。

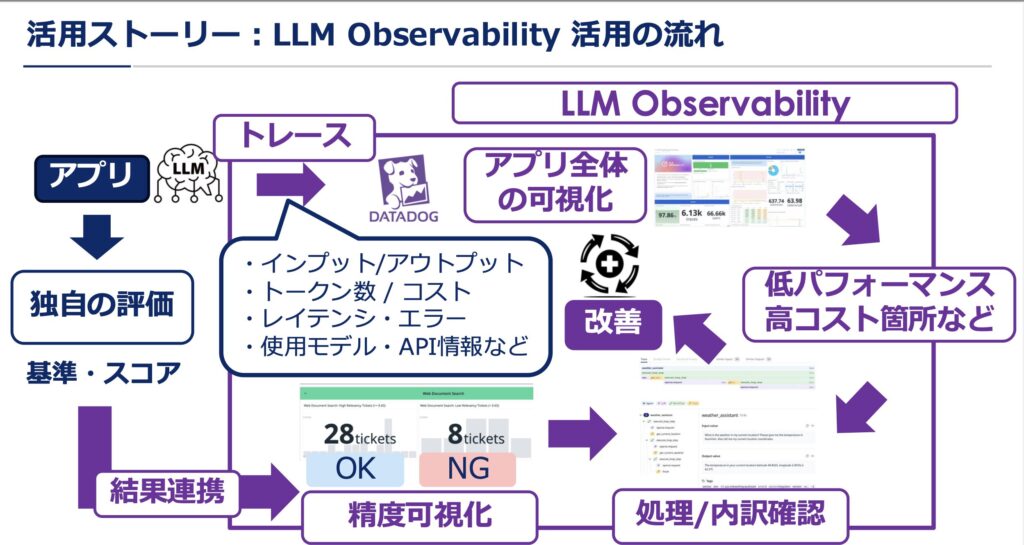

「LLM Observability」の導入によって:

- アプリケーションからLLMへのリクエスト処理を自動的にトレースし、レイテンシ、トークン数、コスト、エラー率、使用モデルやAPI情報などを詳細にモニタリングできるようになりました。これにより、パフォーマンスやコストのボトルネックを特定しやすくなり、エラーや遅延の発生ポイントも明確になった

- 外部の生成AIを用いた評価用LLMと連携し、出力のスコアリングを自動化(LLM as a judge)。Datadogにスコア結果を連携することで、応答の傾向や変化をリアルタイムに把握できる体制を構築

定義済みの評価基準をベースに評価用LLMで自動判定するよう移行したことで、出力が期待する精度に達しているかどうかの傾向を可視化し、問題の集中しているプロンプトも特定できるようになり、継続的な改善サイクルが実現しました。

現在は、モデルやプロンプトのドリフトが新たな課題となっており、今後はDatadogによる関連機能の追加も視野に入れつつ、トレース・ログ・メトリクスを活用したドリフト検知の強化や、精度判定業務の完全自動化も視野に入れています。

3. IVRy社とアイレットの取り組みに見る共通点

IVRy社とアイレット、それぞれのユースケースは異なりますが、生成AIの信頼性確保という観点では共通するポイントが明確に見て取れます。

- 出力が期待する精度に達しているかを常に可視化している点:

- LLMの応答内容を定量的に評価し、精度の傾向や変化を継続的に把握

- AIが「ハルシネーション」を起こしたり、期待通りの応答をしなかったりするリスクを低減するために不可欠

- Datadogを活用したシステム全体の可視化と改善サイクル:

- トレース・ログ・メトリクスなどを通じて、LLMを含むアプリケーション全体の振る舞いを監視し、ボトルネックの特定や問題の早期解決、そして継続的な改善サイクルを構築

これらの共通点は、どのような生成AI活用においても、オブザーバビリティがいかに重要であるかを物語っています。

4. IVRy社の取り組みからアイレットが学ぶべきこと

今回のセッションを通じて、特にIVRy社から学ぶべき優れた点がいくつかありました。

- 生成AIワークフローを細かいタスク単位に分割

- IVRy社では、「意図の分類」「情報の抽出」など、処理を段階的に分けて制御性と一貫性を確保することで、特定のプロセスに問題があっても他の工程に波及しない構造を実現しています。

- このようなタスク分解による安定性の確保は、今後の弊社におけるAIワークフロー設計にも応用可能であり、柔軟性とメンテナンス性の両面で多くの学びが得られる実践です。

- CI/CDと連携したLLMの自動テスト体制:

- IVRy社では、期待する精度を継続的に確認し、品質を維持する仕組みがCI/CDパイプラインに実運用レベルで組み込まれています。

- これにより、モデルの変更やプロンプトの調整がサービス品質に与える影響を継続的に検証し、安定稼働を実現している点は、私たちも見習うべき模範的な実践です。

- フェールオーバー設計と業務継続性の確保:

- LLM API障害時の代替API選定(OpenAIからGeminiやAnthropicへの切り替え)、さらに全APIが停止した場合の人間オペレーターへの転送設計など、高い可用性と復旧性を実現する堅牢な設計は、電話コミュニケーションというリアルタイム性が求められるサービスならではの徹底ぶりです。

現在、アイレットで導入しているシステムはあくまで社内向けであり、IVRy社のような高度な可用性が直ちに求められるわけではありません。しかし、将来的に外部向けのAIサービスを展開する際には、ハルシネーション抑制のための多層的な検証、堅牢なフェールオーバー戦略、そして最悪のシナリオでの人間オペレーターへの転送設計といった彼らの知見は、非常に大きなヒントとなります。

5. まとめ

IVRy社と弊社サポートチームのLLM活用事例から見えてくるのは、DatadogのLLM Observabilityが生成AIの信頼性向上において非常に有効なツールである一方で、アプリケーションやインフラの設計・運用全体の最適化が不可欠であるという点です。

特に、生成AI特有のハルシネーションの抑制や精度の揺らぎへの対応には、可視化だけでなく、コンポーネントの分割や検証の仕組みの組み込みなど、システムレベルでの工夫が求められます。

また、応答速度や可用性の確保といった一般的なシステム要件に対しても、LLM APIの不安定さや処理負荷の特性に合わせた設計や冗長化構成が重要であり、IVRy社のようなフェールオーバー戦略や自動テストの導入は、AIシステムにおいても高い有効性を持ちます。

私たちはIVRy社の実践を通じて、AIの出力精度を評価・監視する体制を整えるだけでなく、それを支えるシステム基盤の堅牢性や運用設計が信頼性の鍵であると再認識しました。

アイレットとしても、DatadogのLLM Observabilityの進化を活用しながら、アプリやインフラ全体の構成・監視体制を強化し、将来的には外部向けのサービスにおいても信頼性の高いAI基盤を提供できるよう取り組んでまいります。