はじめに

MLでのGPUは非常に高額なものでした

これを予約して確保することはMLエンジニアであれば誰もが夢見たことではないでしょうか?

そんな方への

Reserve GPU capacity with Amazon EC2 Capacityとなります

記事の流れ

まずはざっくりとプレゼンでのスライドの画像を見ていただき、

その中でアナウンスされた情報の記載となります。

AWSのMLスタックの一覧となります。

カスタマイズのきくSageMakerが中央に来ています

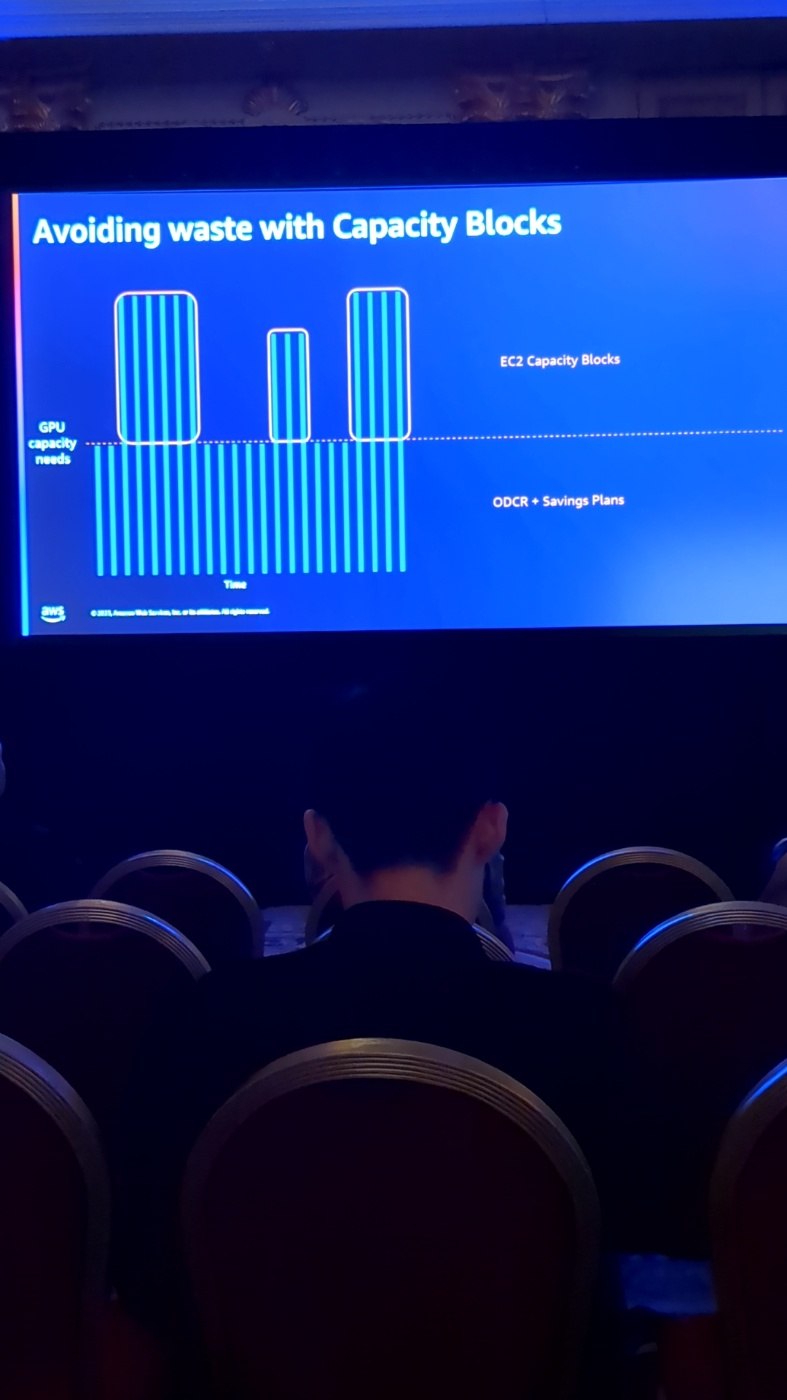

GPUに関しても、通常のCPUと同様、無駄なコストを低減させることが必要です

ここで活躍するのがReserve GPU capacity with Amazon EC2 Capacityとなります

GPUの使用とパターンしては基本的に推論と訓練の両面で必要となります

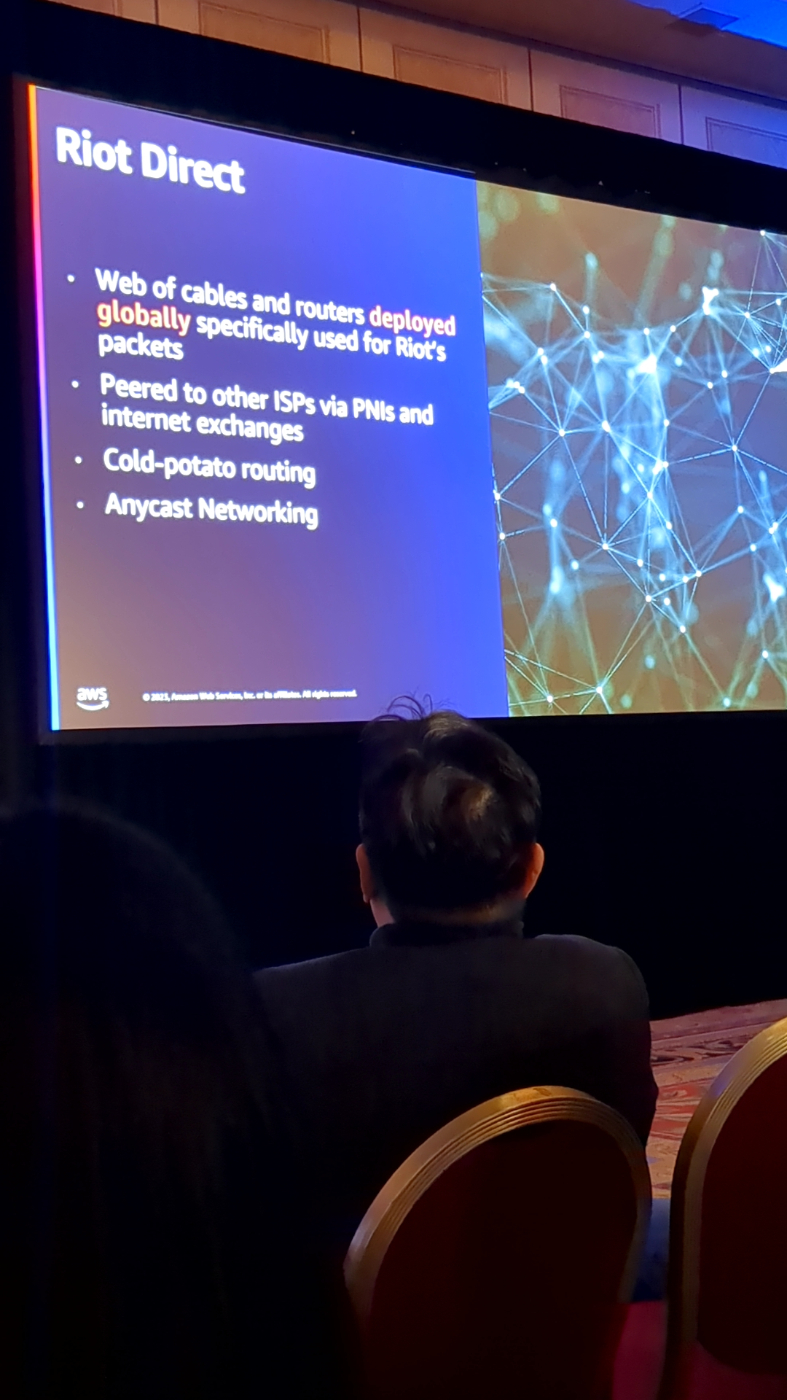

ここで、グローバルにゲーム市場を席巻するRiot社の考え方です

待ちに待ったGPUのキャパシティブロックの予約!

EC2ウルトラクラスターの登場でさらなるネットワーク速度の改善が達成されます

ここで2ndトピックのアジェンダ

キーとなるユースケースの紹介です

最新のGPUインスタンスバージョン:P5

以下セッション内容

otterによる原訳はこちら(気になる方だけ)

はじめに:

アプリケーションの改訂により、従業員の生産性が向上します。

音楽生成やビデオを用いるX世代など、顧客向けのアプリケーションが創造性を高めているようです。

そして、非常に多くの取り組みが行われています。

私たちは、AIは人間ができることの表面をなぞっただけであることを知っています。

当社が提供するさまざまなサービスがどのようなワークロードを必要とするのかについて少しお話しましょう。

以下プレゼン内容:

顧客の規模や業界に関係なく、特定のユースケースに最適化されたソリューションを顧客が常に利用できるように、顧客が選択できるさまざまなオプションを提供できるようにしたいと考えています。 そして、私たちはさまざまなサービスをこれら 3 つの異なるレイヤーに整理し、顧客が自分たちの行動について考えるのを支援します。

最下層には、ML フレームワークとインフラストラクチャがあります。

この層には、高速化されたハードウェアを搭載したもの、

そして突然、高速ネットワーク インターフェイスで接続されているインスタンス、私たちのフレームワークがあるものなども含まれます。

録画に必要な実行にも最適化されています。 これらは、プログラマー、パブリッシャー、および pytorch TensorFlow であり、これらの深層学習コンテナー上の深層学習に事前にパッケージ化されており、誰でも簡単にこれらのインスタンスを開始できるようになります。

そして、私たちが持っているスタックの上位に移動すると、Amazon sage Maker というマネージド サービスを使用できるため、開発者は構築、トレーニング、デプロイが非常に簡単になり、突然そうできるようになります。

これは、次のことを検討している顧客にとっては非常に良いオプションです。

データサイエンスだけに集中してください。

AWSは、インフラストラクチャ管理などの重労働をAWSに任せてほしいと考えています。

そして最上層には AI サービスがあります。

したがって、この層内には、Amazon が開発した Foundation レベルに必要な、特定の種類のタスク、タスク固有のサービスが含まれています。 特定のユースケースの場合と同様に、開発者がより効率的にコードを作成できるコージェネレーションアプリケーションである Amazon Code Whisper は、テキスト読み上げ生成アプリケーションである Amazon Pali ではありません。

これらのサービスは、ピアツーピア ベースで単純な API 呼び出しを行うだけで非常に簡単にアクセスできます。

ここでこの件について多くの話題があったことは承知していますが、これは顧客向けの新しいサービスです。

したがって、このセッションでは、この ML フレームワークとインフラストラクチャ レイヤー、特に ECP コンピューティングと GPU ベースのインスタンスに詳細に焦点を当てます。

そこで、機械学習ワークロード用に提供されるインスタンス オプションの概要を説明するために、GPU ベースのインスタンスから始めます。

したがって、これらをトレーニングの違いによって区別します。

したがって、ディープ ラーニング ワークロード用に最適化されたキー 4 とキー 5 のインスタンスがあります。

これらは、分散クラスターで学習モデルをトレーニングしたいお客様など、大規模なディープ ラーニング向けに特に最適化されています。

これらのインスタンスは非常に高性能です。 そして、それらはそのために最適化されています。 したがって、大きな 100、GPU を特徴とする主要な 4 つのインスタンスと、ベースの 100、GPU、および主要な 5 つのインスタンスを特徴とする主要な 5 つのインスタンスがあります。

これらは現在利用可能な深層学習用システムの中で最もパフォーマンスが高いものです。

そして、内部には Nitro ベースのインスタンスである RG 5 インスタンスと G 5g インスタンスがあります。

これらはさまざまなパフォーマンスに最適なインスタンスであり、非常に柔軟です。

さまざまなサイズが用意されているため、ワークロードに適したサイズを選択できます。 また、小規模な機械学習ワークロードもサポートできます。 そして、G 5g は T 4g インスタンスとペアになっています。

これは非常に費用対効果の高い方法であり、古古典的な壮大なプロジェクトでワークロードが発生し、それらをより大きなライブラリで使用したい場合があります。 その場合、私たちは GPU インスタンスへの投資を継続するつもりです。 私たちは最新かつ最高の GPUを提供したいと考えています。

シングルトンのキーを 1 年間保持し続けるとどれくらいのコストがかかるかを見てみましょう。

初期費用なしの 1 年間の省エネプランを組み合わせると、セットアップ費用は約 67 万 8,000 ドルかかります。

そして、そのインスタンスの容量を欧州の公式会議全体に使用する予定であれば、使用率は 100% に近くなります。

過去のブロックはサービスプランと互換性がないため、ECRを使用し、キャパシティボックスを使用する方が効率的です。

ただし、使用量の需要が高まった場合、年間を通じて使用量が減少する可能性があります。

平均すると、その差額を月に 3 週間、または月に 2 週間使用することになります。

彼らは、より魅力的なオプションのように、ブロックを通過してライブを開始することができます。 40 人中 12% が、彼女は不必要なSavingsを使うのではないことを求めていることがわかります。

常にそうであるとは限りませんが、確実に使用量は上下に変動します。