はじめに

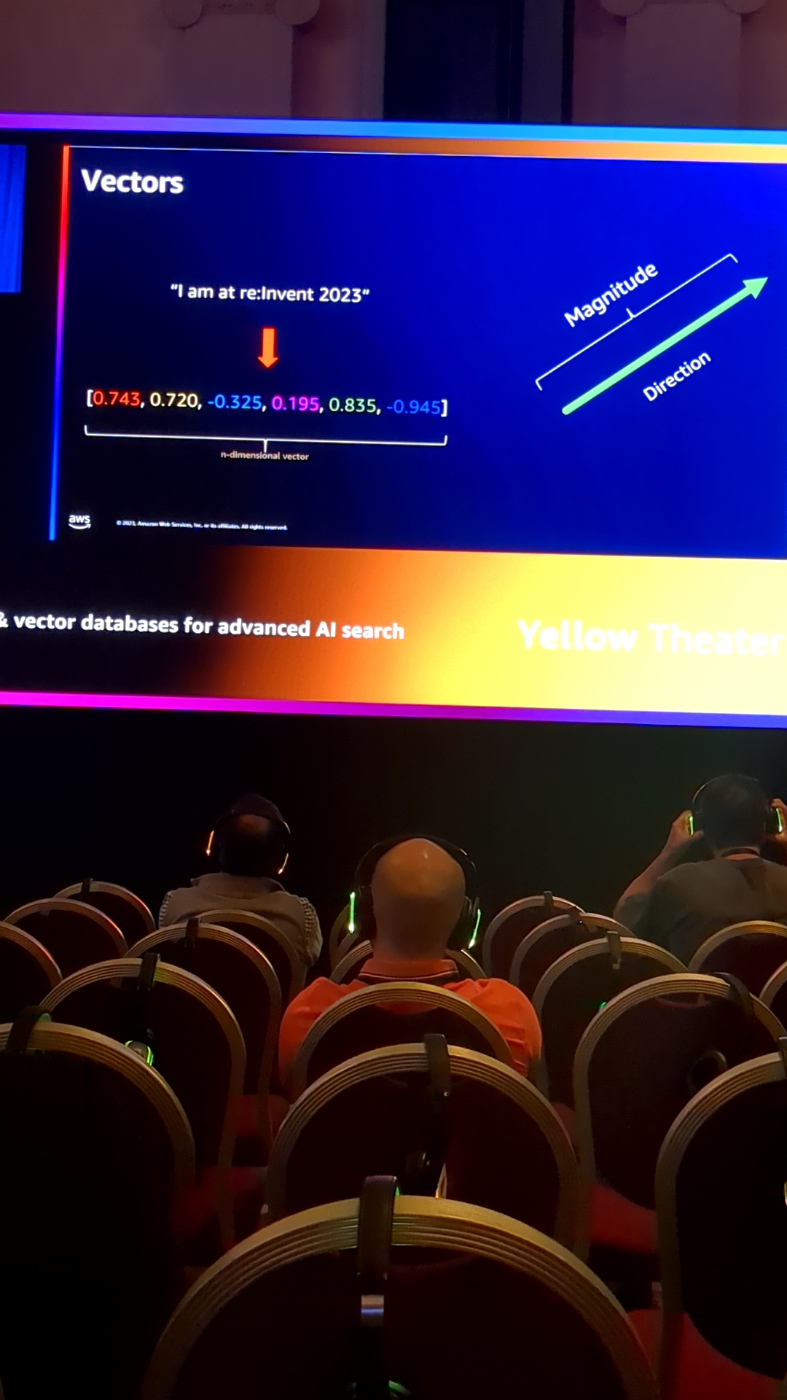

少しマニアックな話となるのですが、MLに関して、ベクトル形式のデータ構造への組み替えは非常に有効なものとなります。

これは言語処理によく使われていて、それぞれの言語の関連性をベクターの距離計算で表現するのが

計算処理効率としても優れていることが明確だからです。

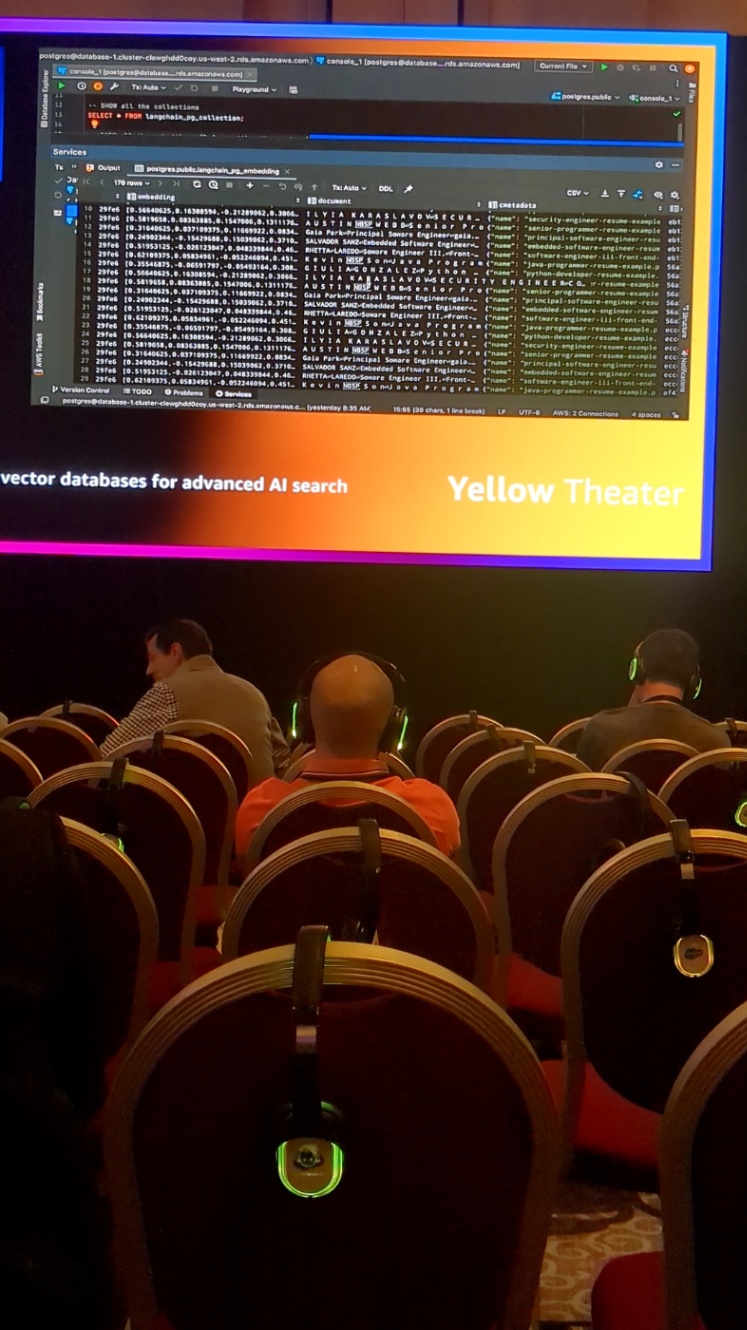

そういったベクター型のデータベースにてAIソリューションを開発する仕組みのセッションを

reInvent2023で受けましたのでスライドと合わせて紹介となります。

言語表現をベクトルの形に定量的な表現へモデリングする例です

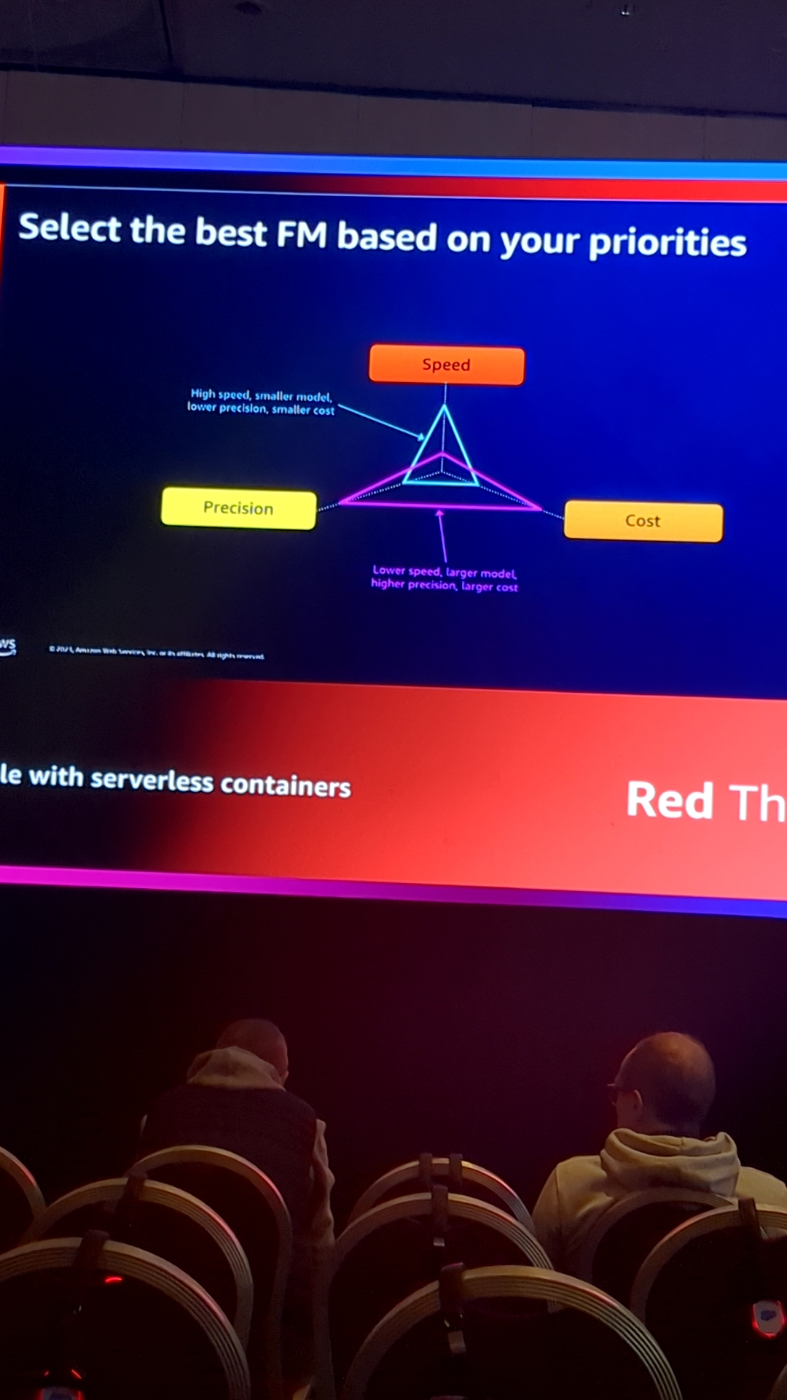

どのようにFoundation Modelを評価していくか、その考え方です

PS:ファンダメンションモデルの補足:

What is a Foundation Model? Trained on massive datasets, foundation models (FMs) are large deep learning neural networks that have changed the way data scientists approach machine learning (ML).

Foundation Modelは優先度に応じて適切に選択することが必要です

それぞれのMLモデルを構築する時の必要な考え方の一例です

AWSにてGenAIをオートスケーリングする時の仕組みです

まず例として下記のような機械学習を実現したいとしましょう。

その際は上記のようなembeddingが必要となります。(この例で言えばベクトル化)

モデル化に伴い、必要な情報のスクリーニングが必要となります。

ビジネスの課題から機械学習のロジックやアーキテクチャを検討する上での思考フローです

AWSは様々なレイヤーからgenerativeAIをサポートしています!

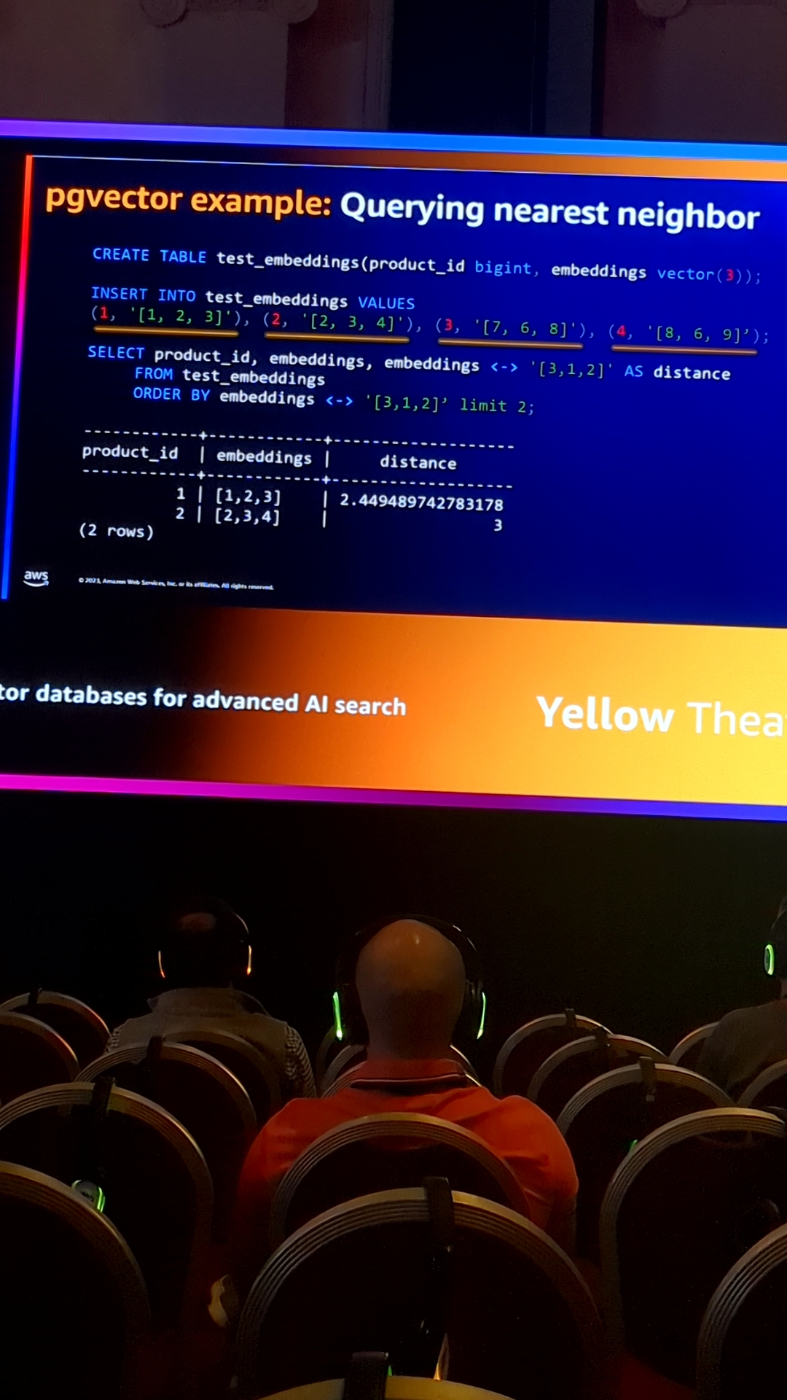

こちらはコサイン類似度などといった、ベクトル間での位置関係の計算例となります

選択したモデルをファインチューニングする際のフローです

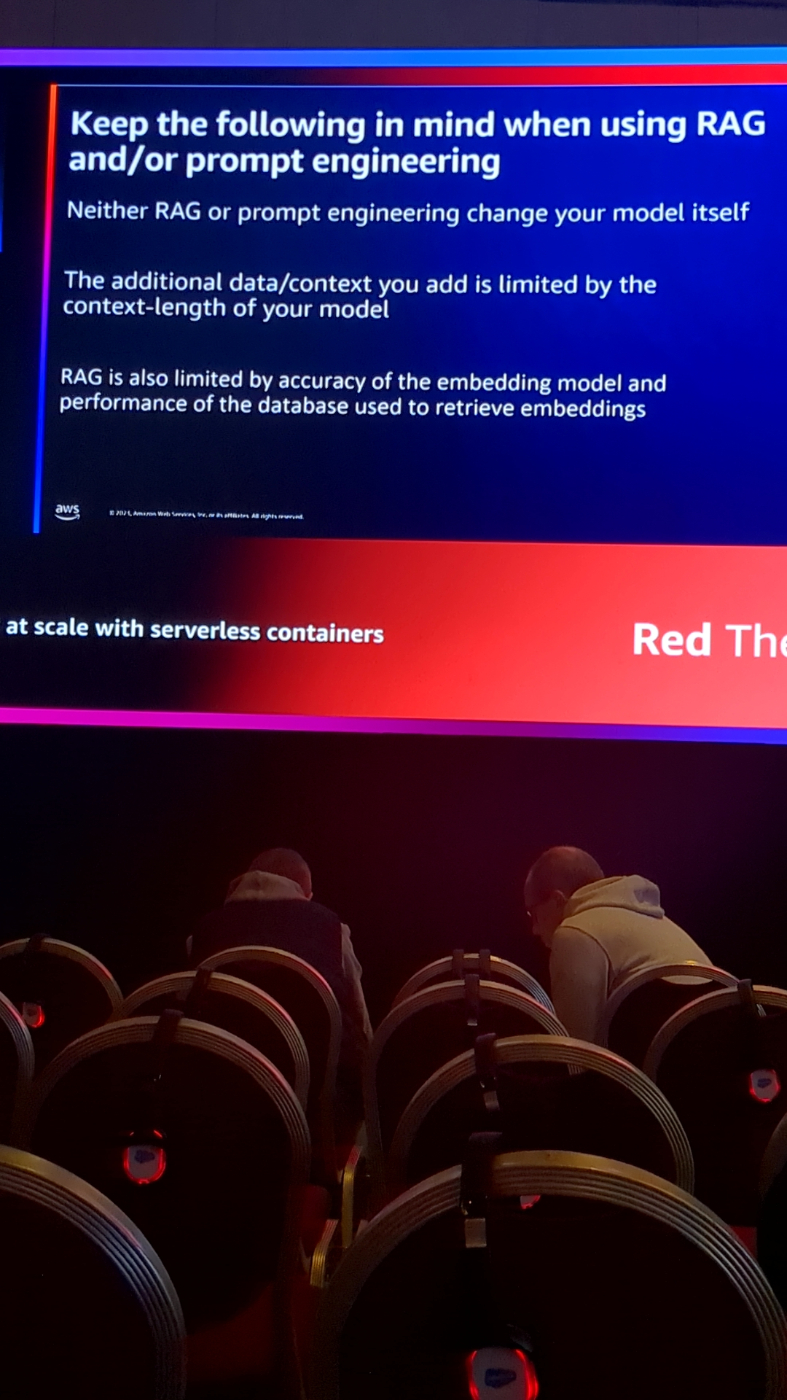

RAGを構築する際の考え方

モデルの起動をどう結びつけるかの考え方です

AWSにおける3つのAIモデルのデプロイの選択肢を紹介します

なぜベクター化であればpostageSQLなのか、そのメリット。

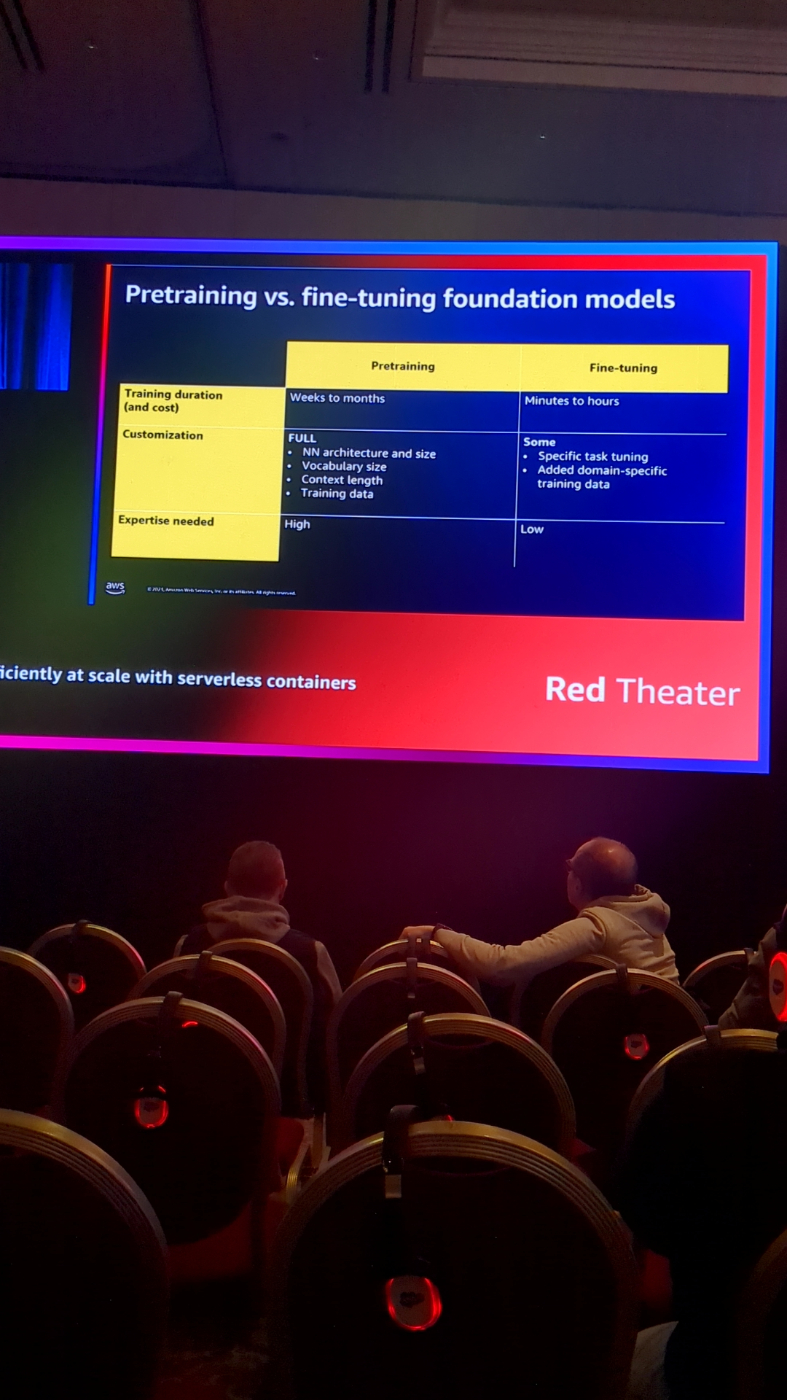

事前学習に対して、ファインチューニングの対比表

これはあるあるのあるあるで、genelativeAIに質問を投げる時、

ユーザーの作成した質問の仕方を整形して、答えの方向性を導きやすくすることが非常に大切となります

gen AIのアーキテクチャ例です

様々なデータがベクター化可能です