パート2ではどう言った形でモデルをデプロイするかについて紹介します

パート1をまだ読んでない方はこちら

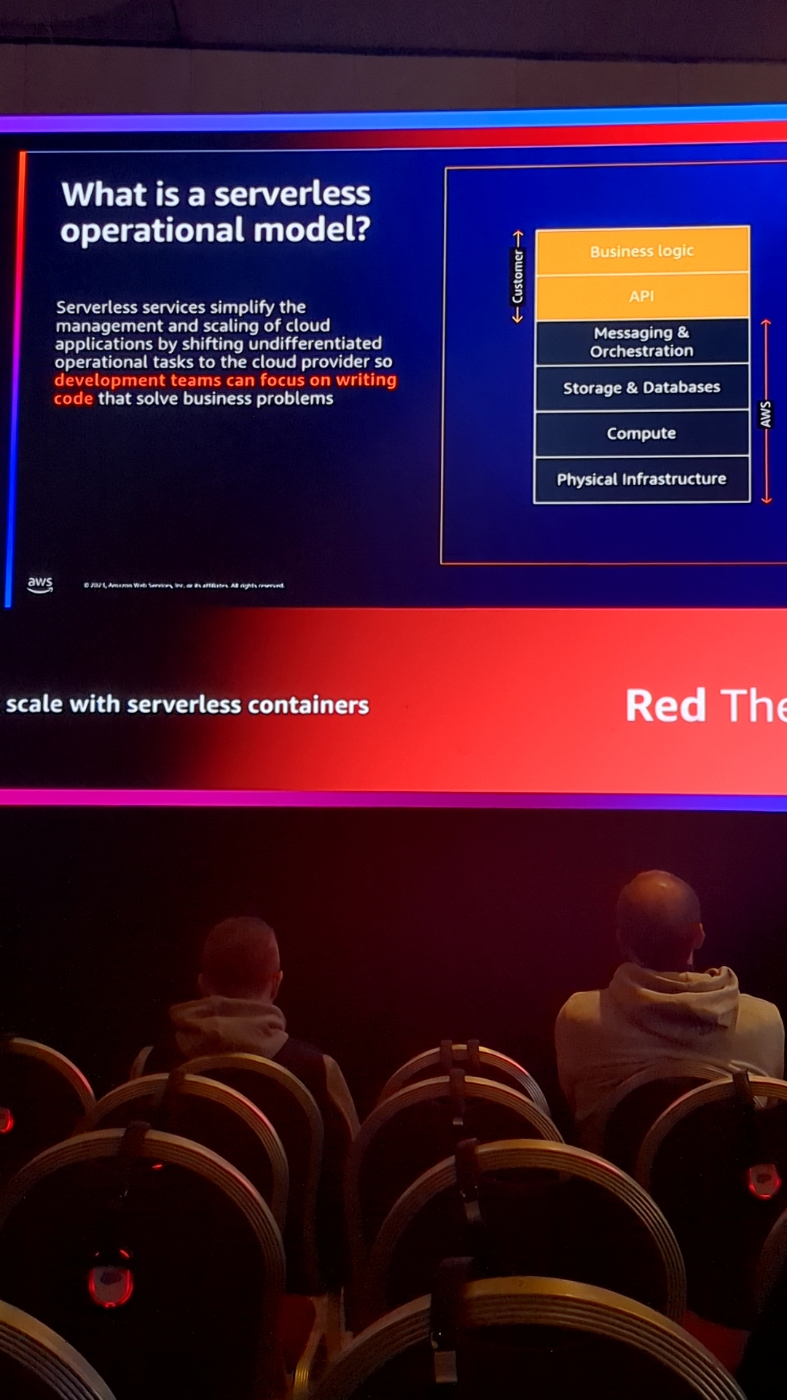

AIモデルをサーバーレス稼働させるという選択も検討の必要があります

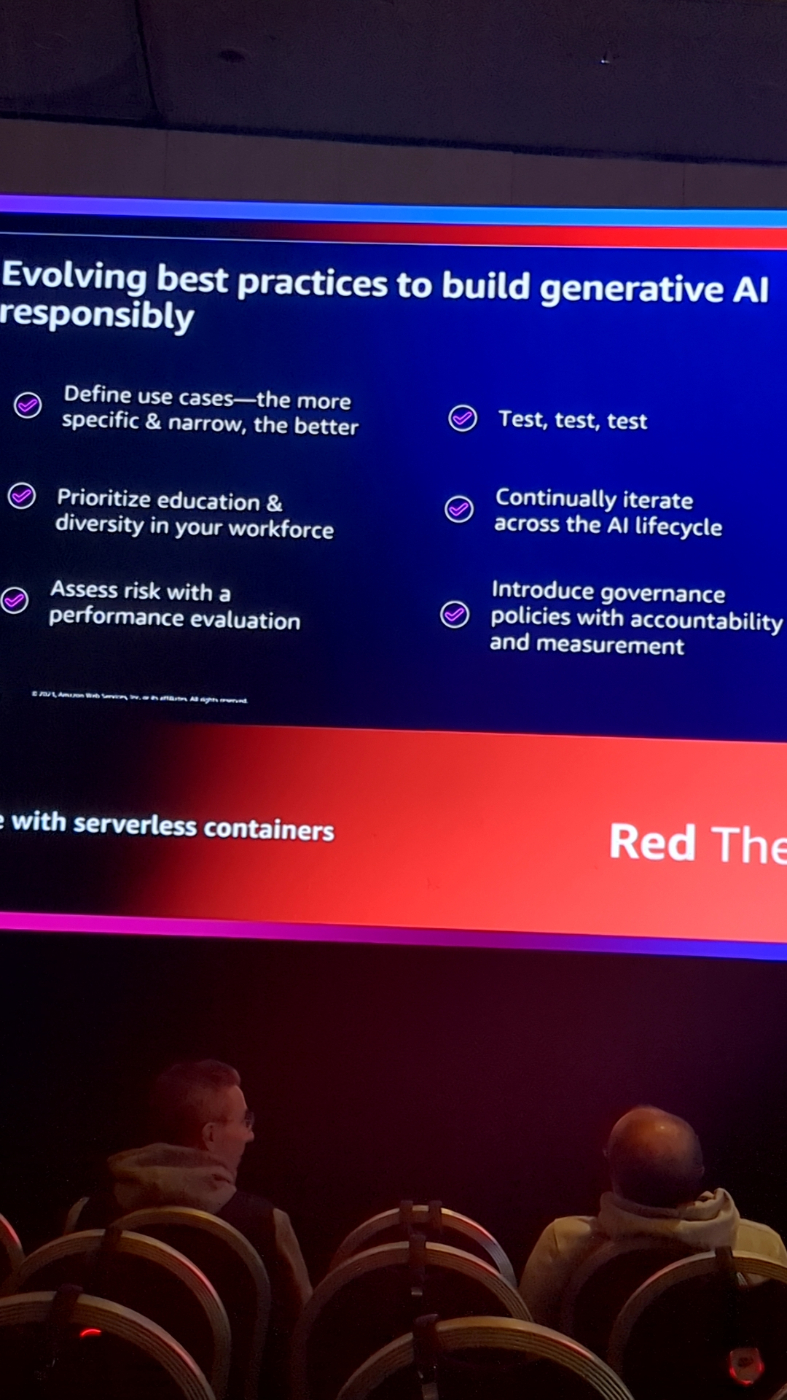

適切なgen AIを改良するための大切な考え方です

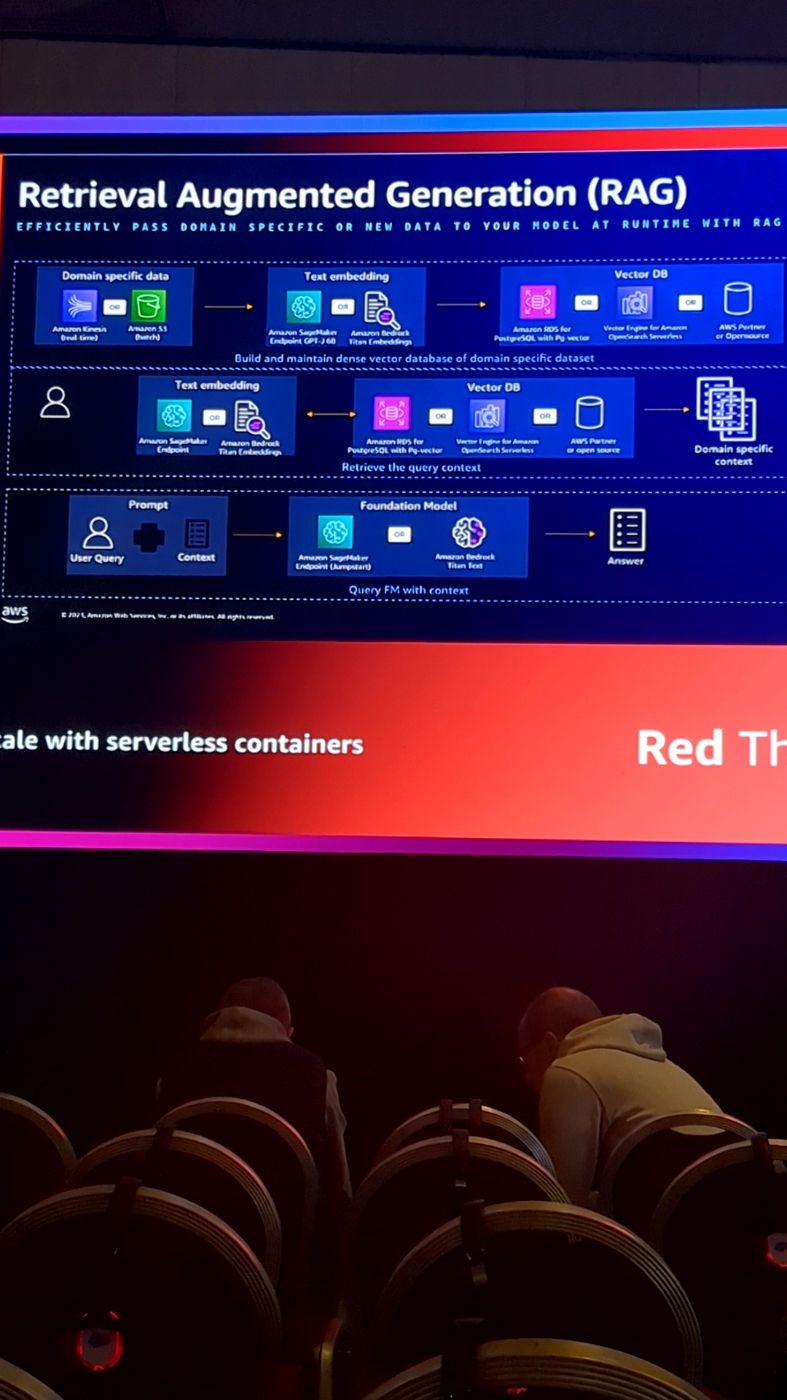

以下がRAGのアーキテクチャ例となります。

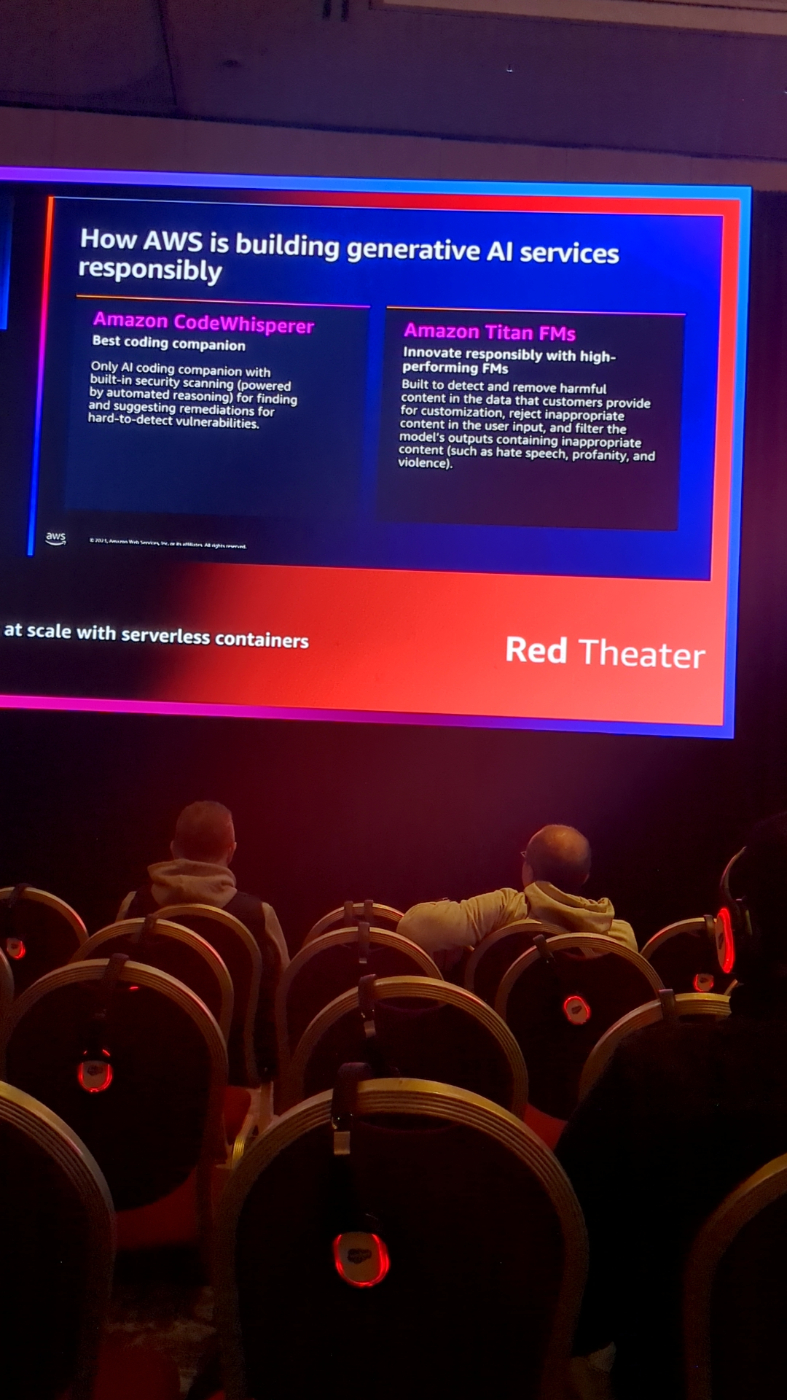

どのようにAWSがレスポンシブなgen AIを構築しているか、良い2例の紹介です

モデルの準備ができたら、前述の通り前処理としてのベクター化を行いましょう

独立したスケーリングなど、microサービスのようにそれぞれを独立させることがメンテナンス性の高まりをもたらします

LangChainのようにハイレイヤーなコンテキストでモデルの構築を行えるライブラリを使用しましょう

gen AIアプリを製品化する上でのキーポイントです

ECSを用いて、MLモデルを販促する際の選択肢です

訓練データの準備や対応を避け、事前学習モデル、もしくはファインチューニングの実施が適切なことが多いです

MLモデルをAWSにてどうデプロイするか、以下の選択肢から検討の必要があります

ベクターDBをAWSにて用いる際の選択肢です

終わりに

MLモデルに関しては

gabage in gabage out

という有名な格言があります。

つまりデータの質が、AIの質に直結する

それからも適切なデータのベクター化は非常に重要となります。

また昨今のgenAIへのマッチ度も非常に高いものと思います。

AWSを用いて、メンテナンス負荷を下げつつ実装し、適切なフレームワークが

社会問題を解決するAIモデル構築につながることを期待しています。