概要

セッション「Accelerate AI inference workloads with Google Cloud TPUs and GPUs」を聞いて来ました!!

公式より Deepl翻訳使用

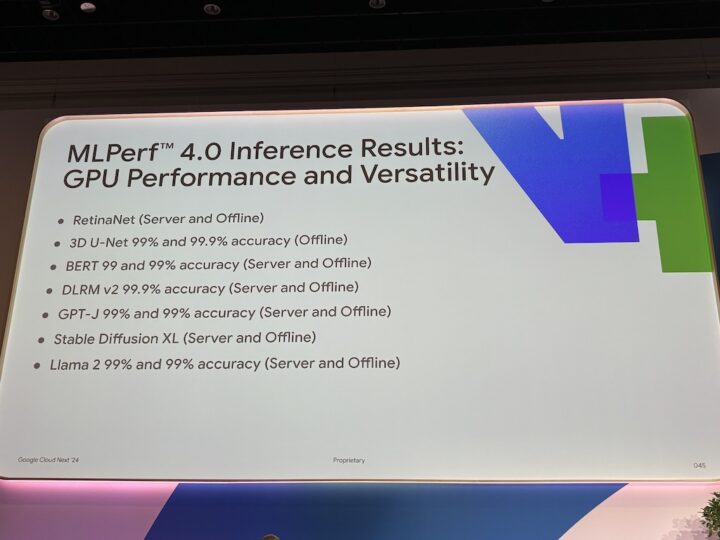

Google Cloudは、さまざまなクラウドテンソル処理ユニット(TPU)とNVIDIA搭載グラフィックス処理ユニット(GPU)VMを提供しています。このセッションでは、推論のニーズに合わせてTPUとGPUを選択する際の主な検討事項をご案内します。大規模言語モデルやジェネレーティブAIモデルなど、さまざまなワークロードに対する各アクセラレータの強みを探ります。TPUまたはGPUを使用してGoogle Cloud上で推論パイプラインを展開し、最適化する方法を説明します。

内容

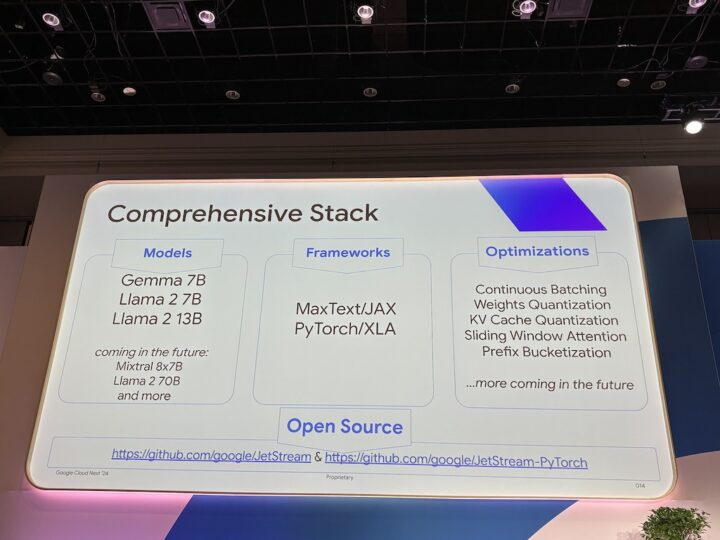

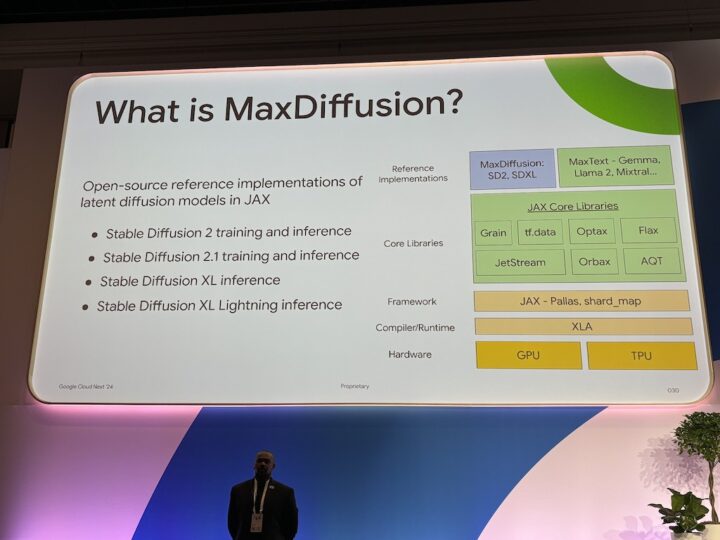

「オープンソースである!コストカットできる!」はそうなんだ!と驚きました

- Production, Trainingで使用するものが違う

ちらっと資格試験でやりましたが、結構サービスの数に偏りがありますね

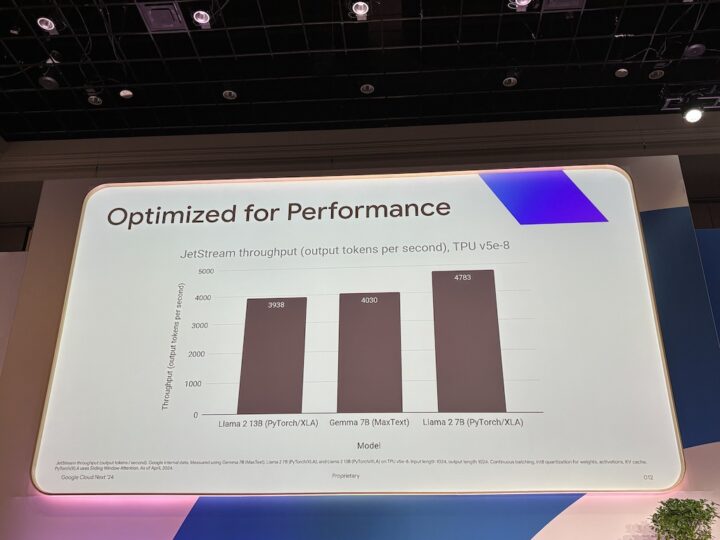

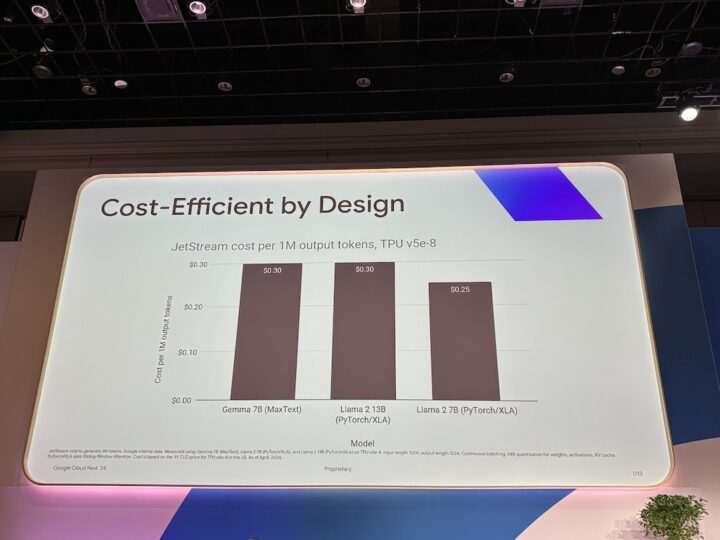

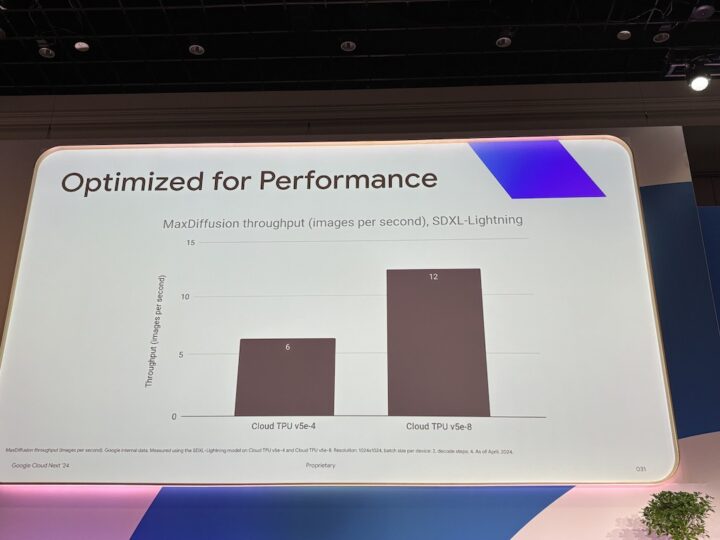

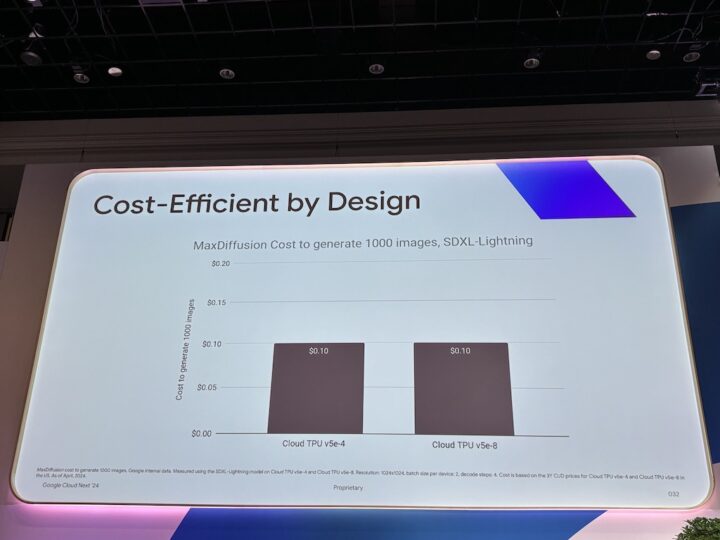

パフォーマンスに差がはっきり見えるのに、コストに違いは無いように見えます。このことからいかに適切な選択が大事なのかわかります。選ぶときにプレッシャーを感じそうです。

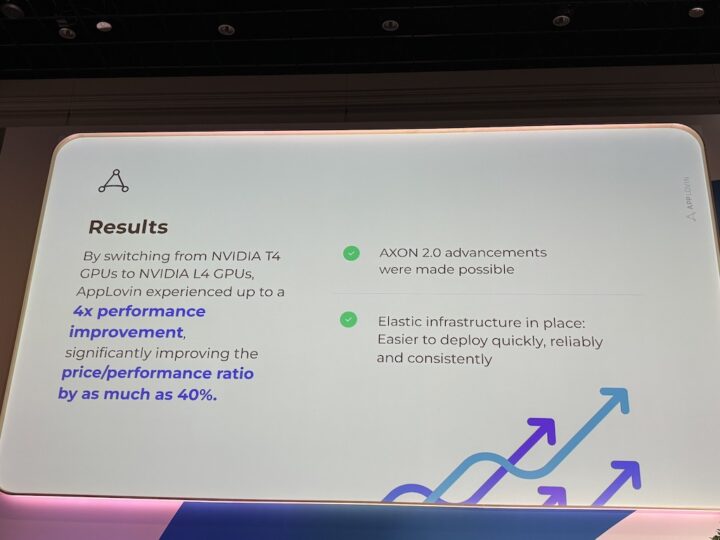

- APP LOVIN x Google Cloud

感想

TPUとGPUは資格試験で勉強したっきりで、なかなか意識していなかったため少し難しい内容でした。

きっちり復習と勉強して、TPUとGPUを意識しているエンジニアです!と胸を張って言えるようにしていきたいです!!