セッションタイトル: How to assess and improve generative AI security applications

スピーカー: Kerry Matre, Muhammad Muneer

はじめに

AI活用の爆発的な拡大に伴って、AIに対するセキュリティにも注目が集まっています。

とは言え、リスクを恐れるあまりにこの強力なAI利活用に二の足を踏むのはナンセンス。

しっかりと正しいセキュリティ対策をして、安全に使いこなしましょう!

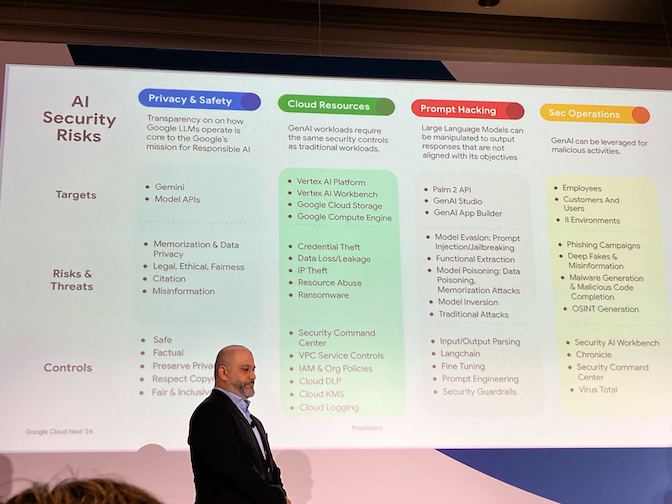

AIセキュリティリスクのマトリクス

例えばDeep Fakeは間違った認識を与えるなど、いかにもAIっぽいセキュリティリスクがあります。

一方、横列に並ぶ、プライバシーと安全、クラウドリソース、プロンプトハック、セキュリティ運用、これらは、AIだからと言った特殊性はあまり感じません。

縦列の、ターゲット、リスクと脅威、コントロールに至っては、従来の管理と全く同じです。

取り扱うデータや手法によって影響への影響がでるものの、対策については根本的な差異がないことが確認出来ました。

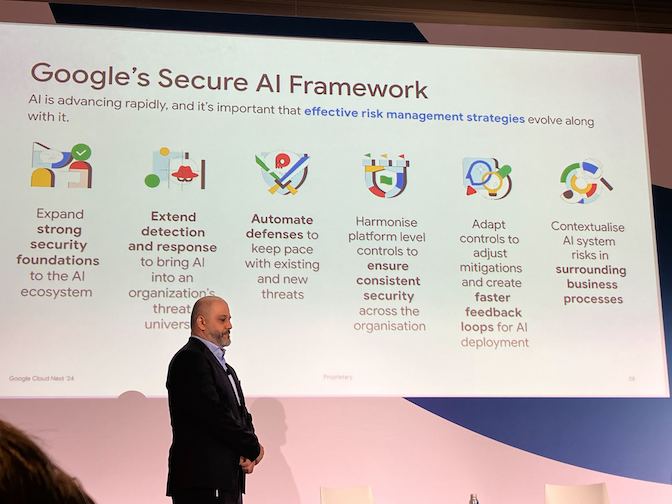

Secure AI Framework

効果的なリスク管理の戦略は表記のような対応で実現できます。

コチラについても根本的な差異はないように見受けられます。

全体的なアセスメントアプローチ

AIパイプラインに対するセキュリティアセスメントは以下のようなアプロートが取れます。

- AIパイプラインの定義

- クリティカルなコンポーネントの識別

- 重要なコントロールの識別

- 重要な攻撃ベクトルの識別

- 攻撃検出能力の構築

- 脅威モデルの構築

- 不審な行為の事前対処

これらのアプローチのもと、対策に当たりましょう。

AI Pipeline Stack

AIはtech stack(原文のまま。プラットフォーム的な意味かと推測)の上に存在しています。

例えば、PyTouchはPythonの環境のもとに存在しているので、Pythonライブラリの脆弱性に影響を受けます。

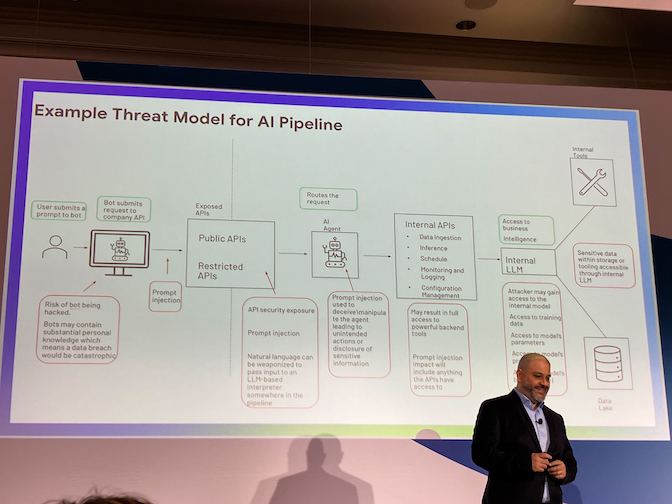

Threat Model for AI

脅威モデリングのアプローチ

AIパイプラインにおける脅威モデルは、以下のような例です。

脅威モデリングの考慮点は以下になります。

- どんな種類のAIを使っている?

- 訓練データのモデルに悪意あるものはない?

- AIモデルをデプロイする環境は複数にまたがる可能性があり、それぞれにリスクを持っている可能性がある

AI Mitigation Considerations

セキュリティリスクを軽減するための考慮点は以下になります。

- データセキュリティ … 訓練やデプロイに使うデータはセキュアであるべき

- モデルセキュリティ … モデルはセキュアであるべき

- 環境セキュリティ … AIモデルがデプロイされる環境のセキュリティ

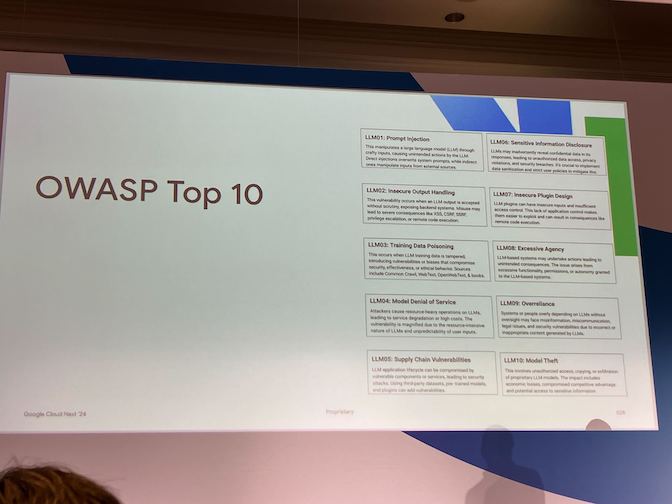

OWASP Top 10

LLMに対してのOWASP Top 10もあります。

こちらは考慮する際に有用な情報となります。

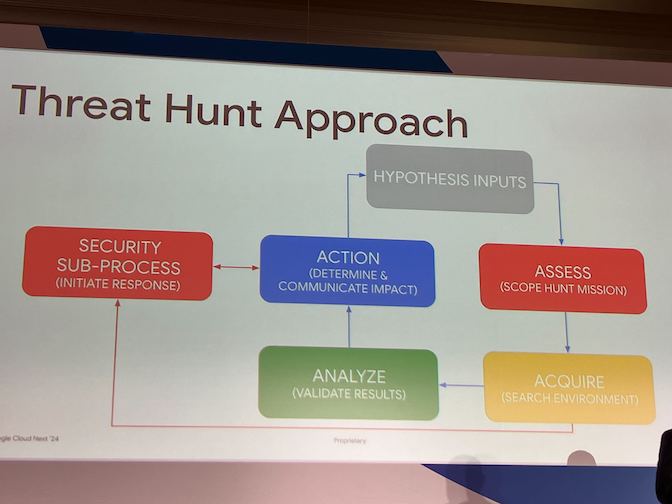

Threat Hunt for AI

AIの脅威を捉えるための要点は、以下のような内容があります。

- AIパイプラインにおけるクリティカルアセットの識別

- 脅威の背景の理解

- 脅威モデルの構築

- AIパイプラインからアノマリ検知のための様々なデータソースの使用

これらをもとにアプローチを模式化したものがこちらです。

仮説の入力や、アセスメントなどのプロセスはスパイラルに改善を続けます。

まとめとMandiant社のサービス活用

AIだからといって、大きく方針が変わるものではないですが、AI独自の影響や、パイプラインなどのリソースの差異によって、AI向けの脅威モデリングなどに特徴あるものが見受けられます。

従来のセキュリティ対策のままでは行き届かない可能性もあるので、しっかりと分析を行なって必要な手当を打ちましょう。

なお、それらをお金払ったら誰かがやってくれるとしたら、払いますか?

Mandiant社なら毎月たったの$5。商売上手 🙂