DX開発事業部の西田です。

昨夜Geminiの最新バージョンであるGemini 2.0 FlashがついにGAされました!

同時に試験用のGemini 2.0 ProとGemini 2.0 Flash-Liteも発表されています!

Gemini 2.0 is now available to everyone. ✨

⚡ Start using an updated 2.0 Flash in @Google AI Studio, @GoogleCloud’s #VertexAI and in @GeminiApp.

We’re also introducing:

🔵 2.0 Pro Experimental, which excels at coding.

🔵 2.0 Flash-Lite, our most cost-efficient model yet.

🔵… pic.twitter.com/KbqlteWjSk— Google DeepMind (@GoogleDeepMind) February 5, 2025

以下3つのモデルがVertex AIで利用できるようになりました。

- Gemini 2.0 Flash:一般提供。一般提供となったことでレート制限がGemini 1.5 Flashと同等に引き上げられ、パフォーマンスが強化され、価格も簡素化された。

- Gemini 2.0 Flash-Lite:これまでで最もコスト効率の高いモデルで、パブリック プレビューで利用可能。

- Gemini 2.0 Pro:試験運用版。コーディングと複雑なプロンプト向けのこれまでで最高のモデル。

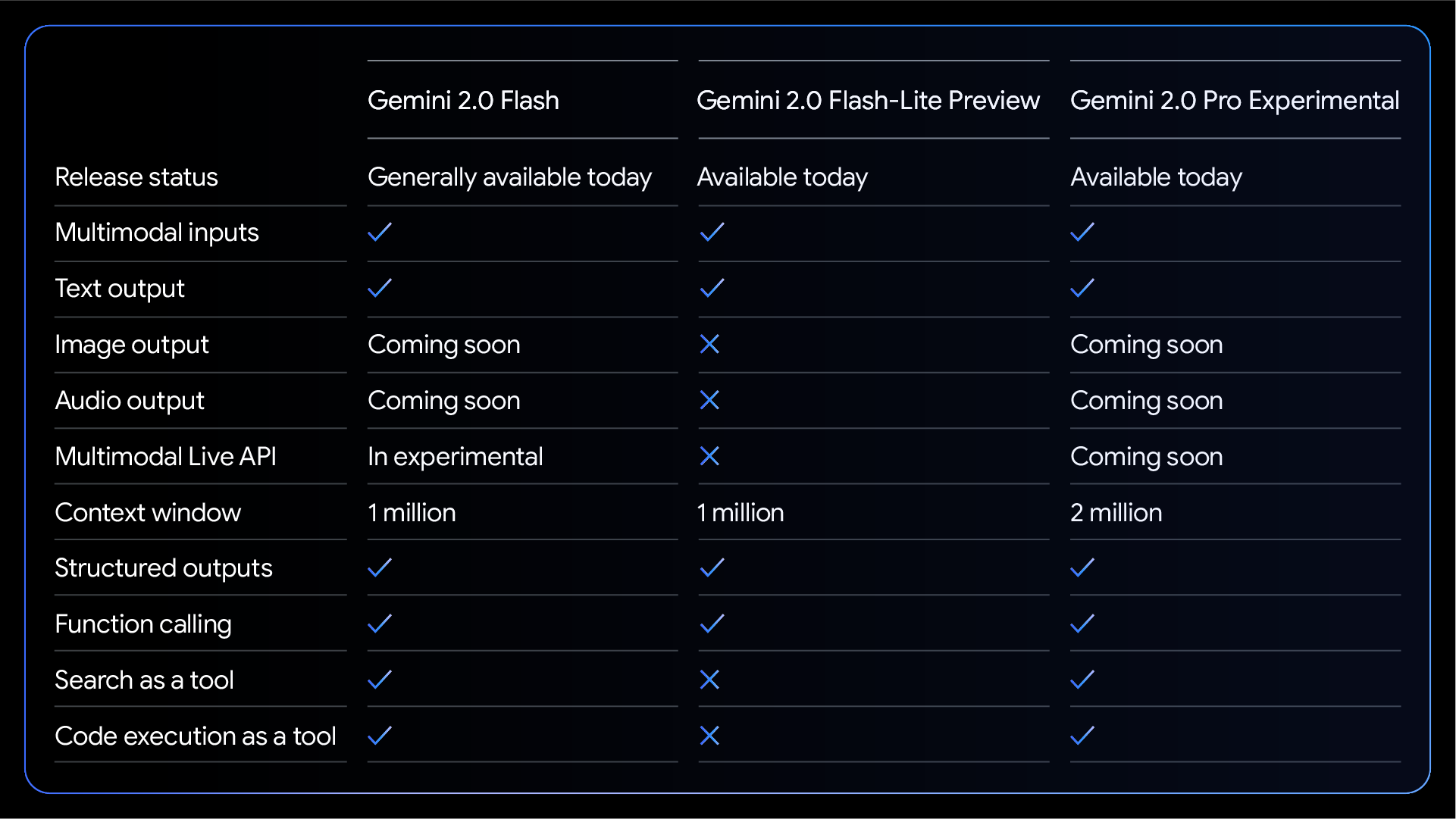

モデルの特徴とパフォーマンス比較

※画像引用元:https://developers.googleblog.com/en/gemini-2-family-expands/

Gemini 2.0 Flashはマルチモーダルのインプットとテキスト出力やグラウンディングなどこれまでのGemini 1.5 Flashでできたことはもれなくサポートされており、画像の出力や音声出力、マルチモーダルライブAPIは今後対応となる見込みです。

Gemini 2.0 Flash-Liteは注意点としてツールによるグラウンディングがなどができなくなっています。

Gemini 2.0 Proは200万のコンテキストウィンドウをサポートしています。

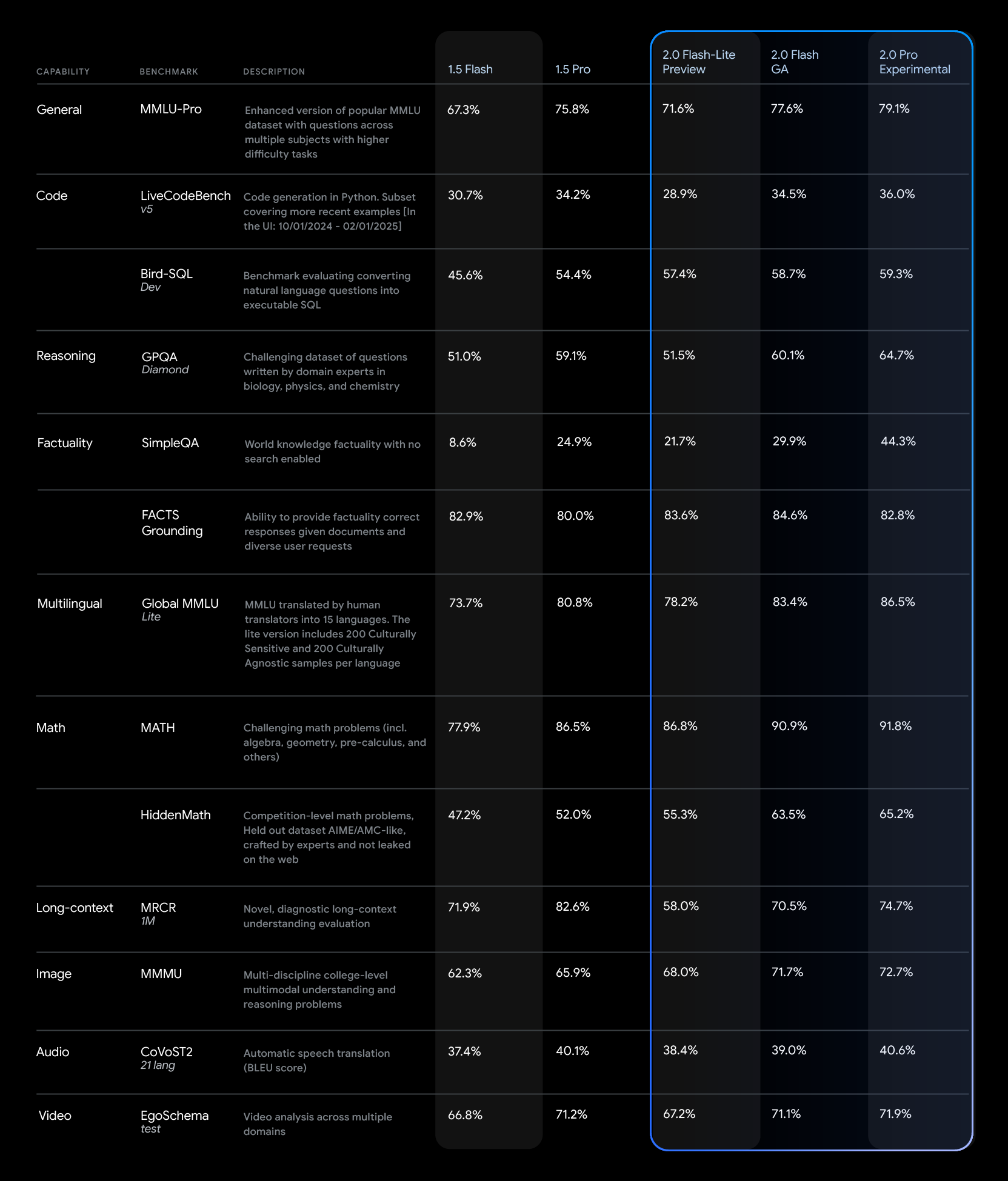

※画像引用元:https://developers.googleblog.com/en/gemini-2-family-expands/

ベンチマークでは2.0シリーズは1.5シリーズの性能を上回っており、Gemini 2.0 Flash-LiteでもGemini 1.5 Flashのベンチマークをほとんど上回っています。

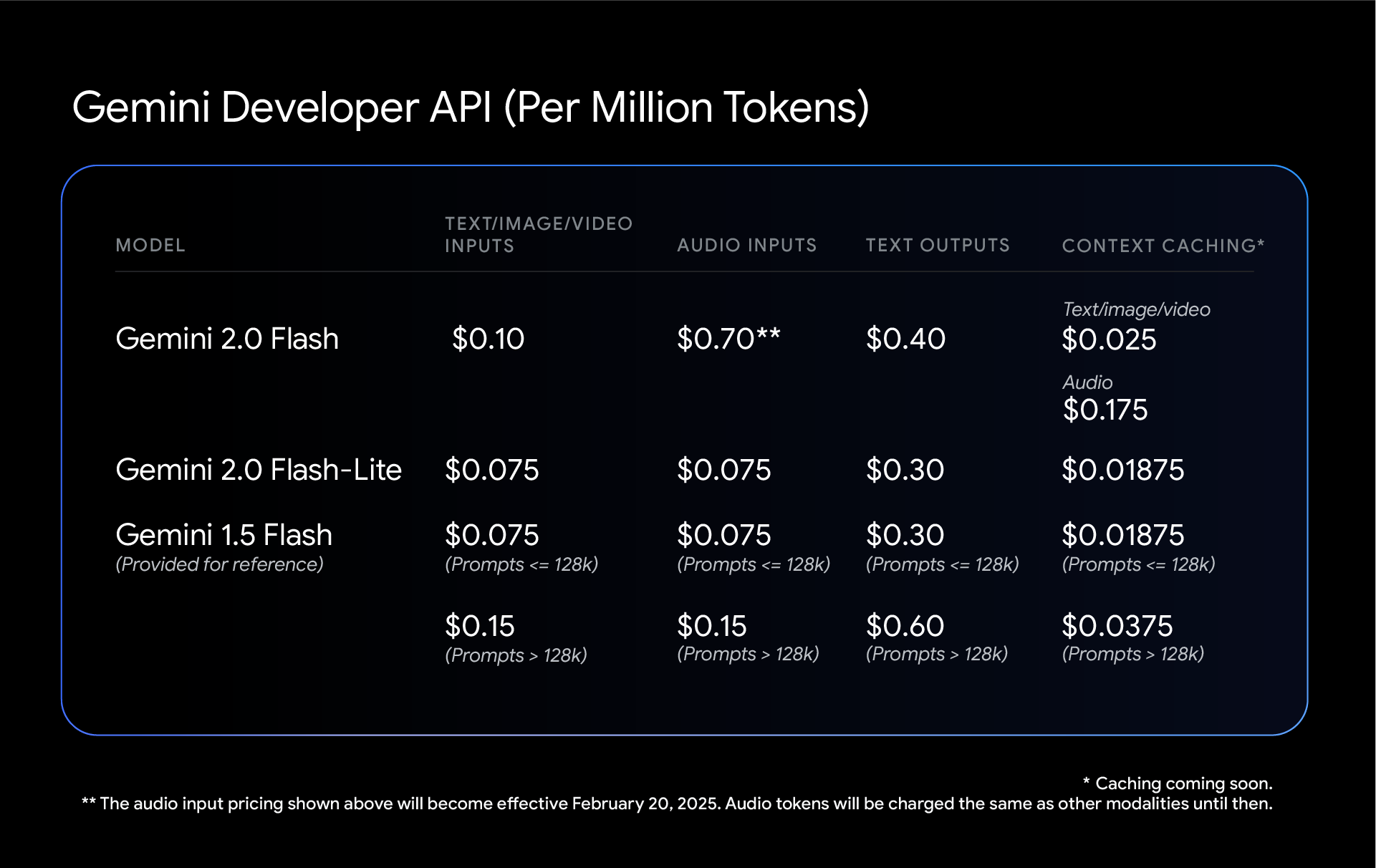

価格

※画像引用元:https://developers.googleblog.com/en/gemini-2-family-expands/

Gemini 2.0 FlashとGemini 2.0 Flash-LiteではGemini 1.5 Flashのようなコンテキスト長による価格幅がなくなってよりシンプルな価格体系となりました。

Gemini 2.0 Flashは短いコンテキストではGemini 1.5 Flashより少し高くなってしまいますが、Gemini 2.0 Flash-Liteを利用すればコストを維持できます。

また、こちらの料金ページでは、Grounding with Google Searchの価格についても触れられており、Gemini 2.0 Flashの場合は1日1,500のリクエストまでは内包され、それを超える場合は1,000リクエストあたり$35とGemini 1.5 Flashと同じ価格で、無料枠がついたような格好となっており、よりお得に使えそうです。

使いかた

Vertex AI StudioかSDKから利用できます。

Gemini 2.0からはPython用のSDKはGoogle Gen AI SDKを利用するようになっています。

これまではGoogle AI Studio用とVertex AI用を使い分けなければいけませんでしたが、統一されました。

その他

Gemini 2.0モデルは東京リージョンではまだ利用ができないようです。

最新のGemini 2.0モデルがいよいよGAとなりこれでお客様にもご提案しやすくなりました。

Google Cloudの生成AI導入はぜひアイレットにご相談ください!