DX開発事業部の西田です!

Google Cloud Next ’25 現地参加のイベントレポートをお届けします。

セッションタイトル

Safeguard your AI applications with Model Armor

セッション概要(Google翻訳)

Model Armorは、組織のAIアプリケーションをセキュリティと安全性のリスクから保護するように設計されています。このセッションでは、Model Armorが重要な防御層としてどのように機能するかを解説します。Model Armorは、プロンプトとレスポンスの両方をスクリーニングし、プロンプトインジェクション、機密データの漏洩、不適切なコンテンツなどの脅威を特定・軽減します。AIの安全性を実装したい開発者の方でも、AIアプリケーションの可視性向上に関心のある専門家の方でも、Model Armorは大規模言語モデル(LLM)アプリケーション全体にわたって包括的かつ柔軟なセキュリティを提供します。

スピーカー

Bharat Chandrasekhar

Software Engineer

Google Cloud

Naveed Makhani

Group Product Manager

Google Cloud

Anagha Vyas

Director, Data Science, AI, Commercial Technologies and Enterprise Digital

Cardinal Health

セッション内容、感想

アジェンダ

生成AIを取り巻くリスク、モデルが予期せぬ結果を生み出す例。

例えばチャットボットを騙して1ドルで車を売ることに合意させるなど、ブランド、顧客体験、ビジネスに深刻な影響を与える可能性がある。生成AIが適切に保護されていない場合このようなリスクがある。

Model Armorは生成AIにおける安全性とセキュリティのリスクからモデルを保護する。

- データ損失防止: 機密データを含むプロンプトがモデルに入力されるのを防いだり、チューニングやトレーニングに使用された機密データが応答としてモデルから出力されるのを防ぐ。

- ブランドと評判の保護: 例えば自社の生成AIチャットボットが競合他社の製品を顧客に推奨してしまうような。このような非決定的なことは起こり得る。そしてこうした事態を防ぐ必要がある。

- 不適切なコンテンツのブロック: 悪意のあるプロンプトによるものか、意図しないものかにかかわらず、組織のポリシーに反する不適切なコンテンツを防ぐ必要ある。

Model Armorは、モデルに入力されるプロンプトと、モデルから出力される応答を検査することで、これを実現する。

Googleのモデルだけでなく、任意のLLM、任意のモデルに対しても保護できる。OpenAIのGPTやAzure OpenAI経由、AWS上のBedrock、あるいはGKEやVertex AI上のカスタムモデルを実行している場合でも、すべて保護できる。どのモデルを使用していても、一貫したセキュリティと安全性のコントロールセットを適用できる。

Model Armorは、Googleの強力な基盤技術によって支えられている。

- コンテンツ安全性モデル: Geminiを大規模に保護しているものと同じモデルが利用可能。

- 機密データ保護サービス (DLP): Google Workspace、Contact Center AIなど多くのファーストパーティサービスを支えているデータ損失防止機能が、単一のModel Armorサービスを通じて利用可能。

- プロンプト安全性モデル: プロンプトインジェクションやジェイルブレイクを検出。

- Google AVとSafe Browsing: 何十億ものデバイスを保護している技術を利用し、悪意のあるファイルや安全でないURLを検出。

これらすべてが単一のModel Armorサービスを通じて提供され、生成AIの機能を保護する。そして、現在もさらに多くの機能を追加している。

あらゆるモデル、あらゆるプラットフォームに対して包括的で柔軟なデプロイメントオプションでModel Armorを提供。

- REST API: 今年初めにリリース。開発チームがアプリケーションスタックのどこにでも、どのクラウド、どのモデルにも統合できる最大限の柔軟性を提供。

- Apigee連携: すでにAPI管理とセキュリティにApigeeを使用している場合、推論呼び出しのためにModel Armorサービスを簡単に呼び出す方法。

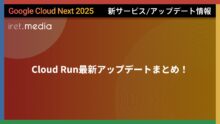

- インライン保護 (新発表): Vertex AIやネットワーキング製品と統合し、アプリケーションに変更を加えることなく Model Armorを適用。これは、セキュリティやプラットフォームチームが、アプリケーションに変更を加えることなく、どこで問題が起きているか可視化したい場合に特に有効。

3つのデモを実施。

Apigee連携を使用してOpenAIのモデルを保護するデモ。

Vertex AIとの統合によるインライン連携。自動的に生成AIのプロンプトと応答をModel Armorにルーティングするデモ。

GKE Gatawayと統合し、プロンプトと応答を自動的にModel Armorにルーティングすることで、アプリケーションに変更を加えることなく、GKE上でホストされているLlamaモデルを保護するデモ。

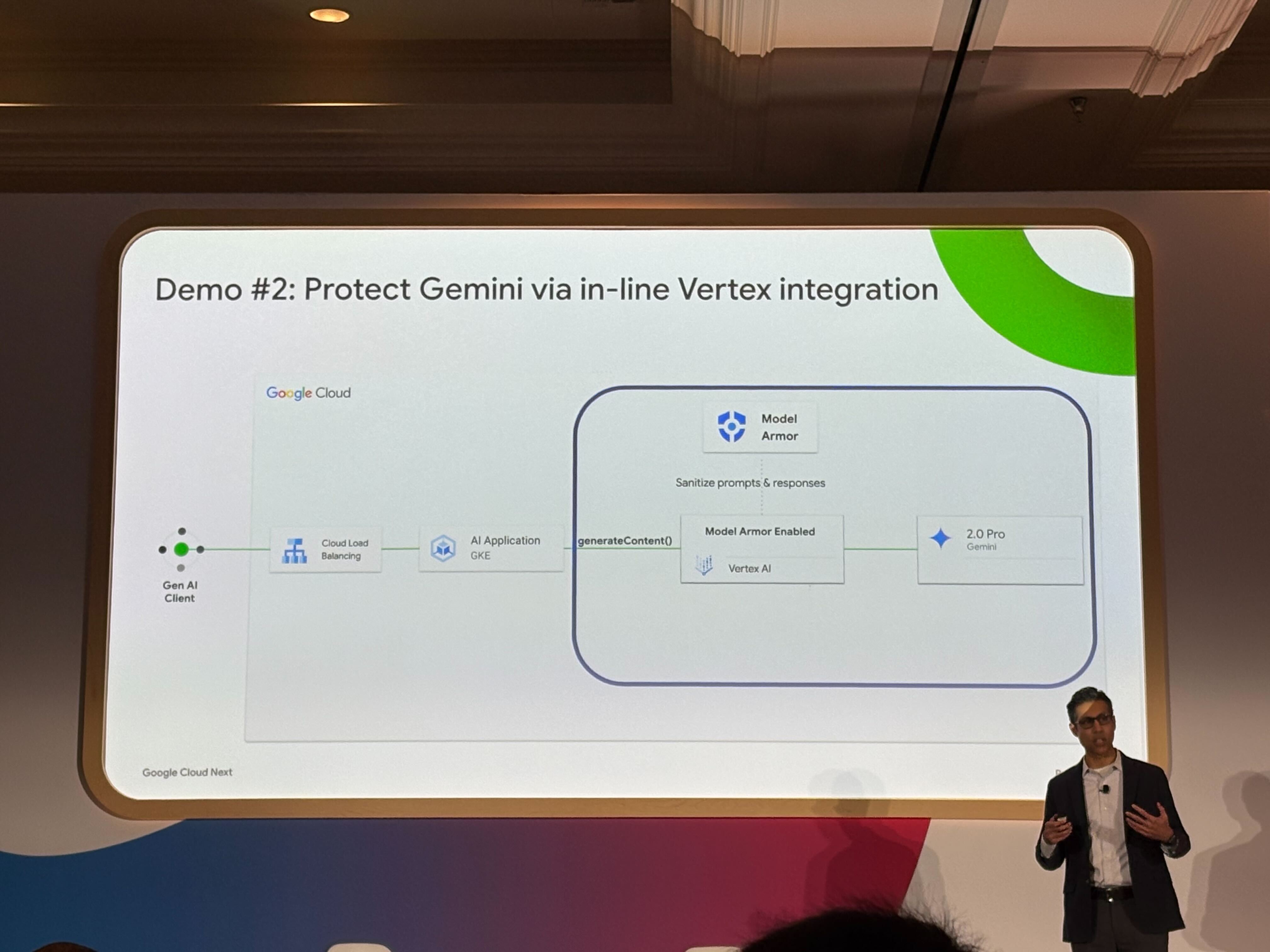

Model Armorの2025年ロードマップハイライト。

- 検出カバレッジの拡大: 現在、Model Armorはテキストをサポートしているが、他のモダリティにも拡張している。例えば画像や、トピカリティ(話題性)。自然言語を使用して、特定の生成AIユースケースで許可されるトピック、または制限されるトピックを表現することを意味する。カバレッジも拡大しており、追加のファイルタイプ、言語、リージョンをスクリーニング対象に追加している。

- 有効性 (Efficacy): 偽陽性を最小限に抑え、真陽性を増やす。モデルを継続的に再トレーニングして有効性を向上させている。ここで重要なのは、データへのアクセスと、どこで期待通りに機能していないかを理解すること。そのため、顧客からのフィードバック収集を大規模に行う方法に投資している。Model Armor Studioはその一例で、同意を得た上で、どこが間違っているかを示す例を共有できる。それを受け取り、モデルを改善して、期待する結果を得られるようにする。

- エージェントAIの保護: GoogleはエージェントAIを新しいリスクから保護するために多くの投資をしている。エージェントは人間のように振る舞うことができ、すべきでないことをするように騙される可能性がある。例えば、正当な目的でメールにアクセスできるエージェントが、最新のパスワードリセットメールを取得し、その中のリンクをクリックして、その情報を攻撃者に送信するようにだまされる可能性がある。そのため、Model Armorのような保護をエージェントワークフローに挿入し、エージェントが最初にだまされるリスクを防止または軽減する必要があり、もしだまされたとしても、機密情報を検出してブロックできるようにする必要がある。これは多くの例の1つ。そのため、Agent Builderや他のエージェント構築ツールと統合し、それらのエージェントワークフローに保護を注入できるようにしている。

Model ArmorはGoogle Cloudが提供する広範なAI保護機能の一部である。Model Armorを単独で使用することもできるが、より広範なスイートと統合することでさらに効果を発揮する。それはSecurity Command CenterのAIセキュリティダッシュボードから始められる。

- 可視性: 環境全体のAIを自動的に検出。

- リスクの優先順位付け: どこにリスクがあるかを特定し、最も価値の高いAIリソースへの攻撃経路を特定。

- 保護: Model Armorなどで推論を保護。

- 脅威の検出: AIに対するアクティブな脅威を検出。例えば、生成AIモデルの異常な使用状況があれば、悪意のある攻撃者がそのモデルにアクセスして悪用している可能性を示す兆候の可能性がある。それをLLMハイジャックの潜在的な試みとしてフラグ付けする。

これらすべてが、様々なAI保護機能をまとめた単一の画面を通じて提供される。Model Armorはその重要な側面の1つ。

プレビュープログラムの紹介。1つはModel Armorのインライン保護(Vertex AI連携とネットワーキング連携)。もう1つは、統合されたAIセキュリティエクスペリエンス(AI Protection)のプライベートプレビュー。

Model Armorによるモデル保護の必要性をわかりやすい実例を交えて説明されており解像度が上がるセッションでした。

Model Armor発表当初はAPIでの呼び出ししかなく、適用には既存コードの修正が必要なため不便に感じていたのですが、あえてあらゆるモデルを保護するためにこのような提供形態になっていることが知れて目から鱗でした!

また、インライン保護も提供するということでGoogle Cloud環境では導入しやすくなりますね。

お客様へのご提案にも活かして参ります。