アイレット株式会社 クラウドインテグレーション事業部所属の森 柾也です。

Google Cloud Next 2025において、[Google-scale AI infrastructure: A look under the hood]というセッションに参加しました。

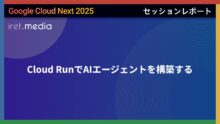

セッションでは、AI インフラストラクチャが新たな時代を迎えていることが強調されました。

本記事では、そのセッションの内容についてご紹介します。

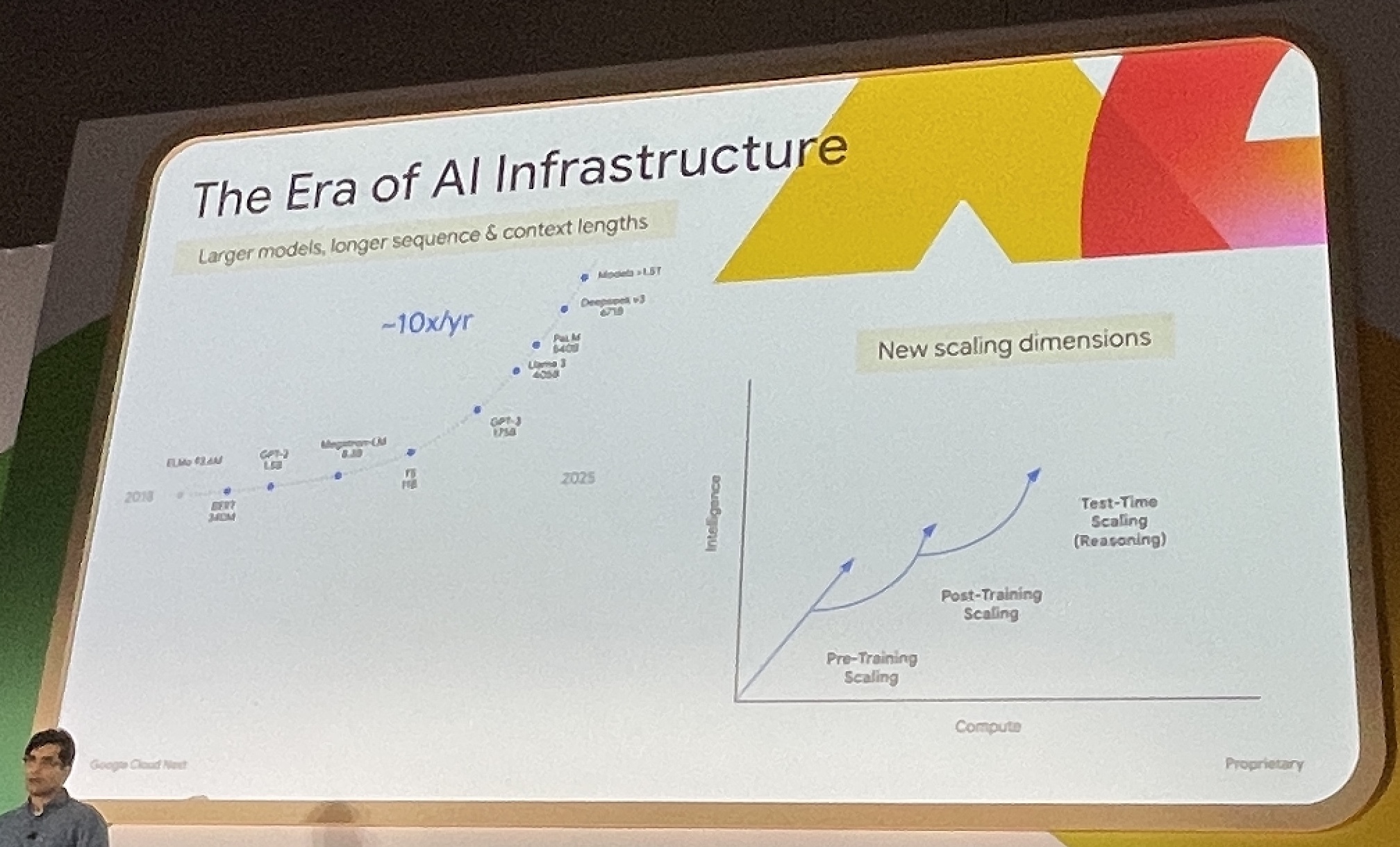

電力、液冷、Jupiterネットワークファブリック

AIモデルは数年で10倍の規模に成長し、複雑化しています。多様なモデルとスケーリング要件に対応する必要があり、インフラの使用方法も進化し続けています。

一方で、より多くのコンピューティング、ネットワーク、ストレージリソースが必要になる中で省スペース化も求められているとのことでした。

電力消費について注意深く監視しており、その結果、ASIC (特定のアプリケーションに最適化された高性能な集積回路) から最大 10% の電力損失があることがわかったとのことです。

修正するために、Googleは垂直給電に変更したそうです。その結果、電力削減とより強力なパフォーマンスが得られたとのことでした。

参考: 垂直給電

また、Jupiter という Optical Circuit Switching を利用しているとのことでした。

イメージとしては、光スイッチのような高速でスイッチングができるものとのことで、従来の電気スイッチよりも高速・高密度とのことです。

これらの基盤により、大規模なトレーニングや推論を行うことができるそうです。

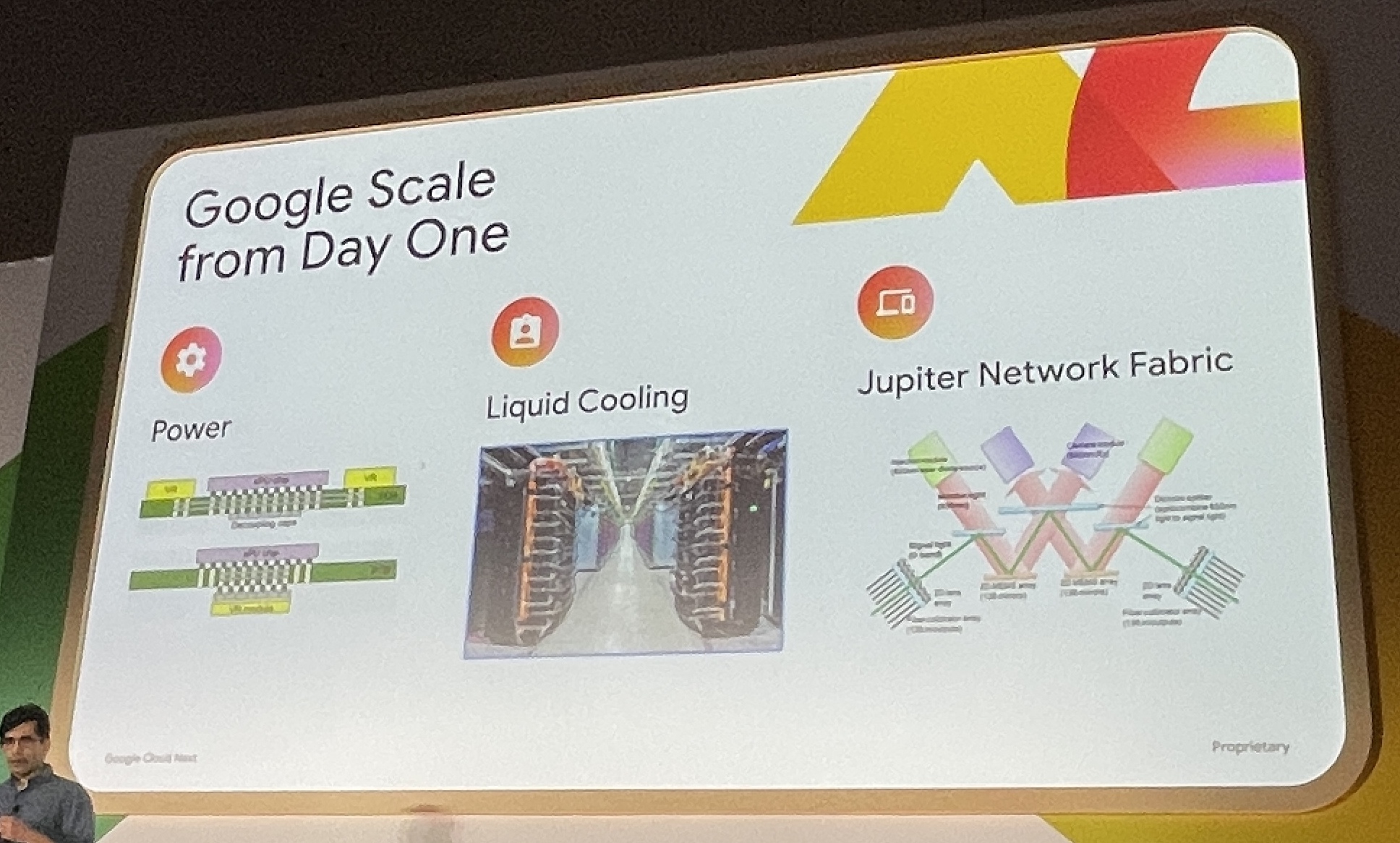

シリコンからSoftmaxまでの共同設計

Google は過去10年間、TPU の開発に注力してきました。ハードウェアとソフトウェアの共同最適化により、音声認識、言語翻訳、レコメンデーション、大規模言語モデルなどの分野で大きな進歩を遂げています。

2015年頃、大規模推論実行のためにコンピューティング能力の大幅な向上が必要だと認識し、専用ハードウェアの開発に着手しました。

今日での最大のGoogleの強みは、多大な投資が必要である高密度インターコネクトを持つハードウェア設計と製造能力にあるとのことでした。

その強みにより、次世代のハードウェアへと進化させることができ、Transformer モデルを発表することができたそうです。

Transformer モデルの登場に合わせて、専用設計されたチップを開発することで、90ペタフロップスを超えるコンピューティング能力を実現することができたそうです。

ハードウェアとソフトウェアの優れた連携による革新的なプラットフォームを構築しています。

所感

このセッションを通じて、Googleが大規模AIインフラストラクチャの構築において進化を続けてきたことを実感できました。

今日の Gemini などの AI モデルは、これまでのGoogle内部での継続した研究・革新にあると知り、Google Cloudの底力を感じました。

今後も、AIモデルの規模と複雑さは増大し続けると思いますが、Googleのような先進的な取り組みによって、より効率的で持続可能なAIインフラの実現が期待できると感じました。

私たちがクラウドサービスを活用する際にも、こうした基盤技術の進化を理解しておくことが重要だと再認識しました。

また、私自身のAIインフラやハードウェアの知識が及ばず、セッションのすべてをお伝えすることができなかったのですが、

以下リンク先から発表資料を閲覧することができますので、データセンターやAIインフラに興味のある方はぜひご覧ください。

資料: BRK3-037: Google-Scale AI Infrastructure a look under the hood