はじめに

エンタープライズクラウド事業部の磯部です。

Oracle AI World 2025に現地参加しています。

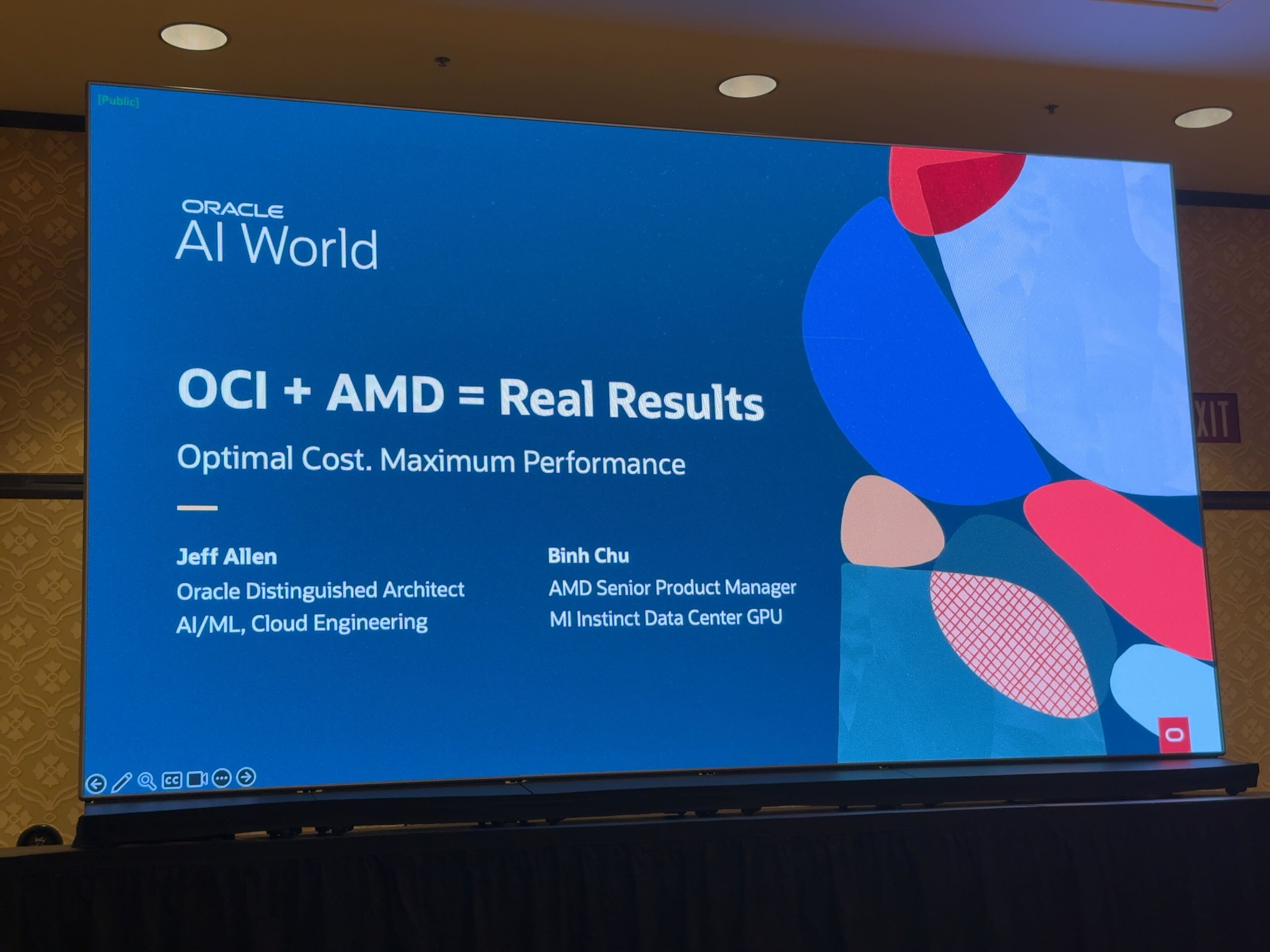

10/14に「AMD + OCI = Real Results Running AI Clusters for GPU Workloads in the Cloud」のセッションに参加しましたので、内容を紹介します。

概要

本セッションの登壇者は、OracleのAI、ML、OCIに注力するJeff Allen氏、AMDのデータセンターGPUライン「Instinct」を担当するBinh Chu氏、および両社の共通顧客であるSeekr社のBen Faircloth氏です。

データセンターGPU市場において、AIハードウェア構築に焦点を当てて説明をされていました。

公式サイトから引用

The scale of AI inference is growing quickly. With a larger VRAM footprint for memory-hungry workloads and a cost-effective delivery model through OCI, customers are seeing the benefits of AMD+OCI. In this session, learn how AMD Instinct GPUs combine with OCI’s high-performance networking to deliver performance and efficiency for today’s AI workloads. We’ll give a real-world view of the steps to building and operating AI clusters in OCI, and Seekr will share their experience migrating AI workloads from on-premises to OCI. We’ll cover how to achieve lower latency, higher throughput, and better cost efficiency. Regardless of where you are in your AI journey, this session will give you a clear roadmap to modernizing your AI infrastructure.

(DeepL翻訳)

AI推論の規模は急速に拡大しています。メモリを大量に消費するワークロード向けのより大きなVRAMフットプリントと、OCIを通じたコスト効率の高い提供モデルにより、お客様はAMD+OCIのメリットを実感しています。本セッションでは、AMD Instinct GPUがOCIの高性能ネットワークと組み合わさることで、今日のAIワークロードにパフォーマンスと効率性をもたらす仕組みを学びます。OCI上でのAIクラスター構築・運用手順を実例に基づき解説し、Seekr社がオンプレミスからOCIへのAIワークロード移行で得た知見を共有します。低遅延・高スループット・コスト効率の実現手法を網羅。AI導入の進捗段階に関わらず、AIインフラの近代化に向けた明確なロードマップを提供します。

AMDとは

そもそもAMDとは、パソコンの頭脳であるCPUや、グラフィック処理装置(GPU)などを開発・製造するアメリカの半導体メーカーのことだそうです。

パソコンに詳しい方であれば、AMDのRyzenシリーズはご存じの方もいるでしょうか。

ハードウェア×AIというイメージがなかったため、AIを取り入れているというのは驚きでした。

実際にどのようにAMDとOCIのAI技術を組み合わせているのかを下記でご紹介します。

AIの導入

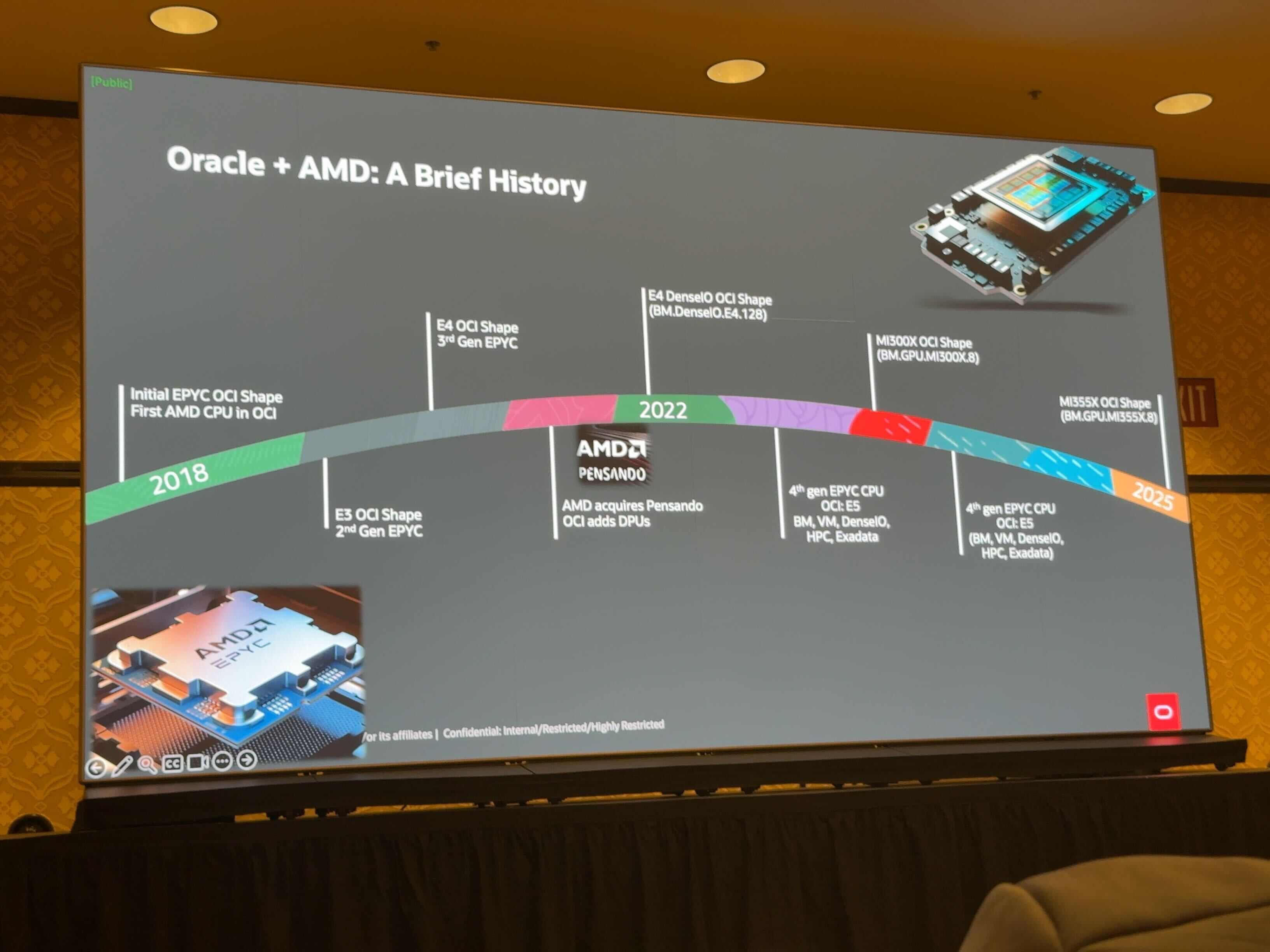

OCIは、クラウドサービス(インスタンスなど)の基盤として、AMDのプロセッサやGPUを採用しています。

2018年にOCIがAMD CPUを導入し、現在はAMDのCPU、DPU、GPUのすべてを採用しています。

AMDは、市場のトレンドが推論タスク(モデルを実際に使って新しいデータから予測や判断を行うこと)だということを捉え、メモリや性能を重視した製品を市場に投入しました。

- 現行世代のMI300xは、市場のどのGPUよりも140%多い192 GBのメモリを搭載していた。次世代のMI355xでは、メモリが288 GBに増加し、演算コア(マトリックスコア)とクロック速度が倍増。これにより、消費電力を倍増させることなく、より少ないワット数でより多くの演算能力を顧客に提供。

- 顧客がInstinct GPUにワークロードを移行しやすくするため、ソフトウェア最適化に積極的に投資した。主要なAIモデルや大規模言語モデル(LLM)の多くは、AMDのソフトウェアスタック上で動作し、最小限のコード変更で移行が可能となった。

- エンドユーザーは、200万以上のHugging Faceモデルを、Instinct GPU上ですぐに実行できるようになり、現在は世界のAI企業の70%がInstinct上でHugging Faceモデルが実行されている。

今後の取り組み

今後、AMDとOCIはどのような取り組みを考え、市場に投入していくのかについて説明がありました。

- Oracleは、2026年までに5万台の新しいAMD GPUをOCI内に展開すると発表。

- OCIは、最大約131,000台のAMD GPUを実行できるZettaクラスターを現在構築中である。

- 2026年には、次世代のEpic CPU(Venice)、次世代のMI GPU(MI455x)、および次世代のPensando DPU(Cocopah)で構成されるHeliosアーキテクチャが、Oracleとの強化された戦略的パートナーシップのもとで展開される予定。

おわりに

以上、「AMD + OCI = Real Results Running AI Clusters for GPU Workloads in the Cloud」のセッション内容についてご紹介しました。

当時の市場では十分なメモリ、性能でも、市場競争によりさらに高いスペックへと、AIを取り入れることで実現していました。

2026年はさらに進化した製品が投入されるということで、AIの無限の可能性をこのセッションで感じました。

最後までお読みいただきありがとうございました。

明日のセッション内容も投稿しますので、ぜひご覧ください!