クラウドインテグレーション事業部の森です。

re:invent 2023 に現地参加しております。

Amazon SageMaker Clarify についてのセッションに参加したためレポートを共有いたします。

#Amazon SageMaker Clarify による基盤モデル評価

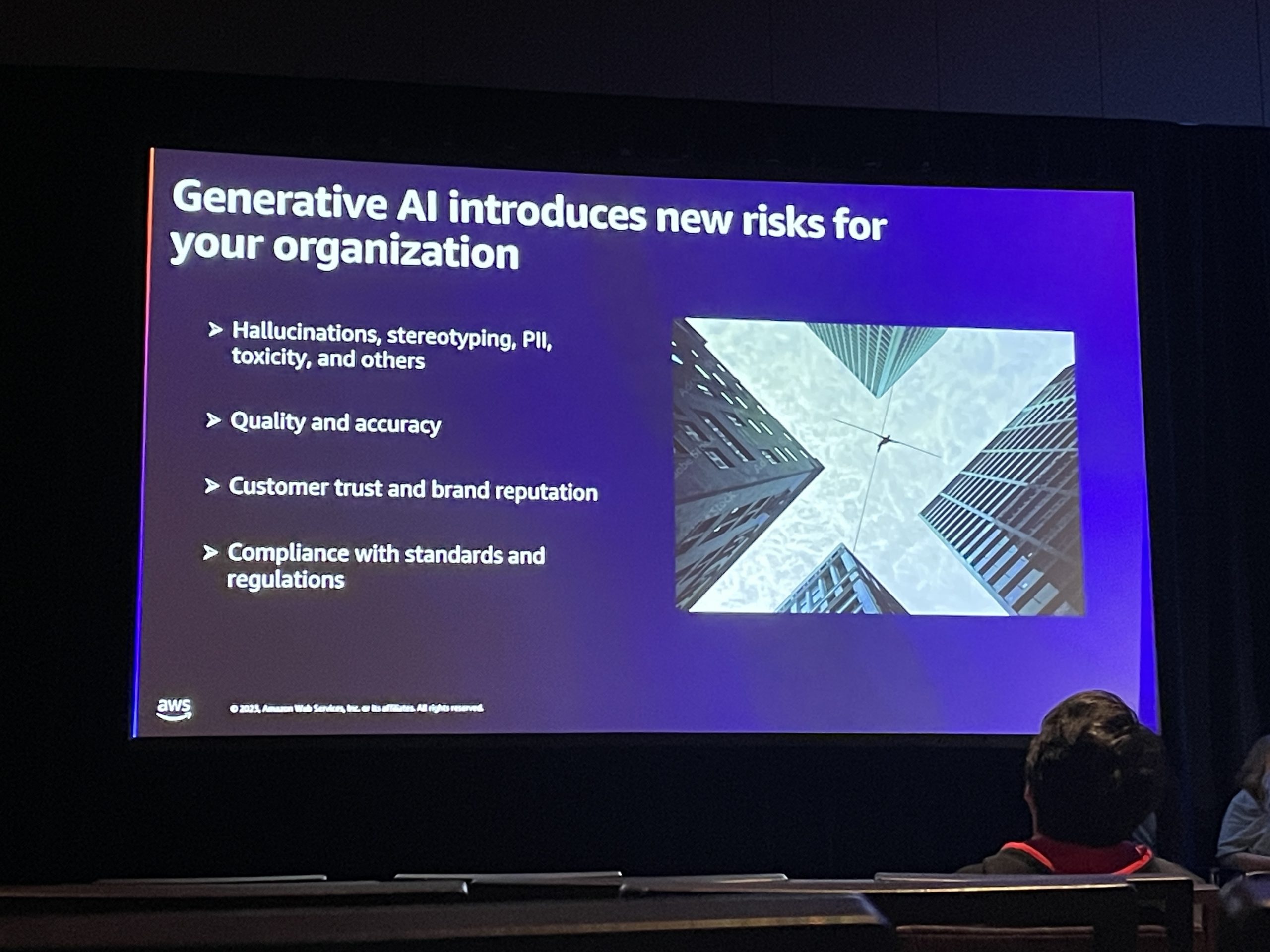

大規模な言語モデルはデータのバイアスを永続させ、ステレオタイプ化や不正確な回答につながる可能性があります。

例えば、有害な回答、憎悪に満ちた回答、冒涜的な回答、その他多くの例が知られています。

しかし、あなたの生成アプリケーションが責任ある回答をすることを確認することだけがリスクではありません。正確でなかったり、質が低かったりするリスクもあります。

そして、ビジネス用途の場合は、このリスクから目を背けることで、最終的に顧客の信頼やブランドの評判が危険にさらされることになります。

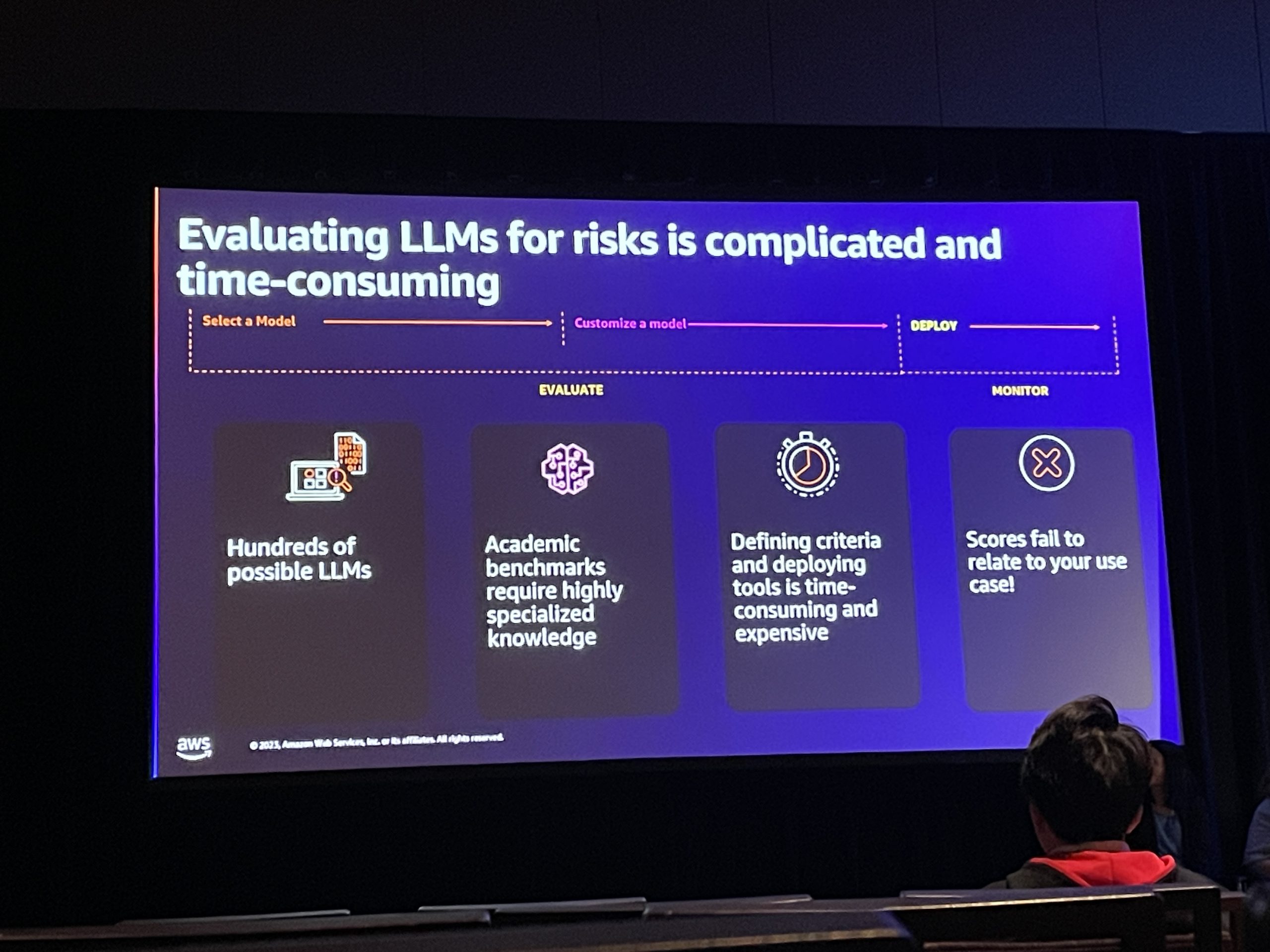

また、大規模な言語モデルのリスク評価は複雑で時間がかかります。

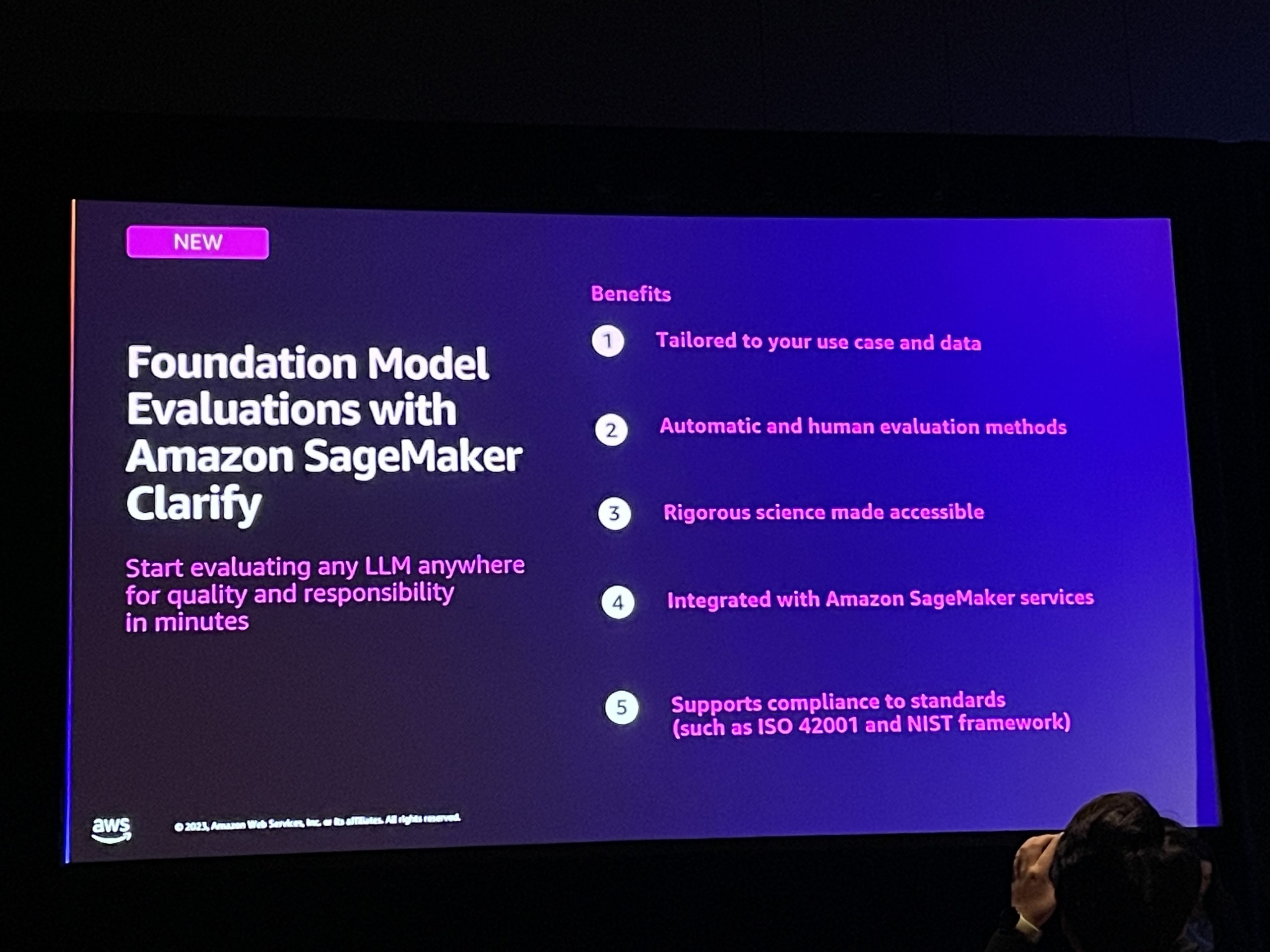

そこで、基盤モデル評価機能を備えたAmazon SageMaker Clarifyが 発表されました。

この機能によって、どんなLLMでも品質と責任について、どこでも数分で評価を始めることができるようになります。

メリット

- ユースケースとデータに合わせてカスタマイズ

- 自動および人間による評価方法

- 厳密な科学を身近に

- Amazon SageMakerサービスとの統合

- ISO 42001やNISTフレームワークなどの標準への準拠をサポート

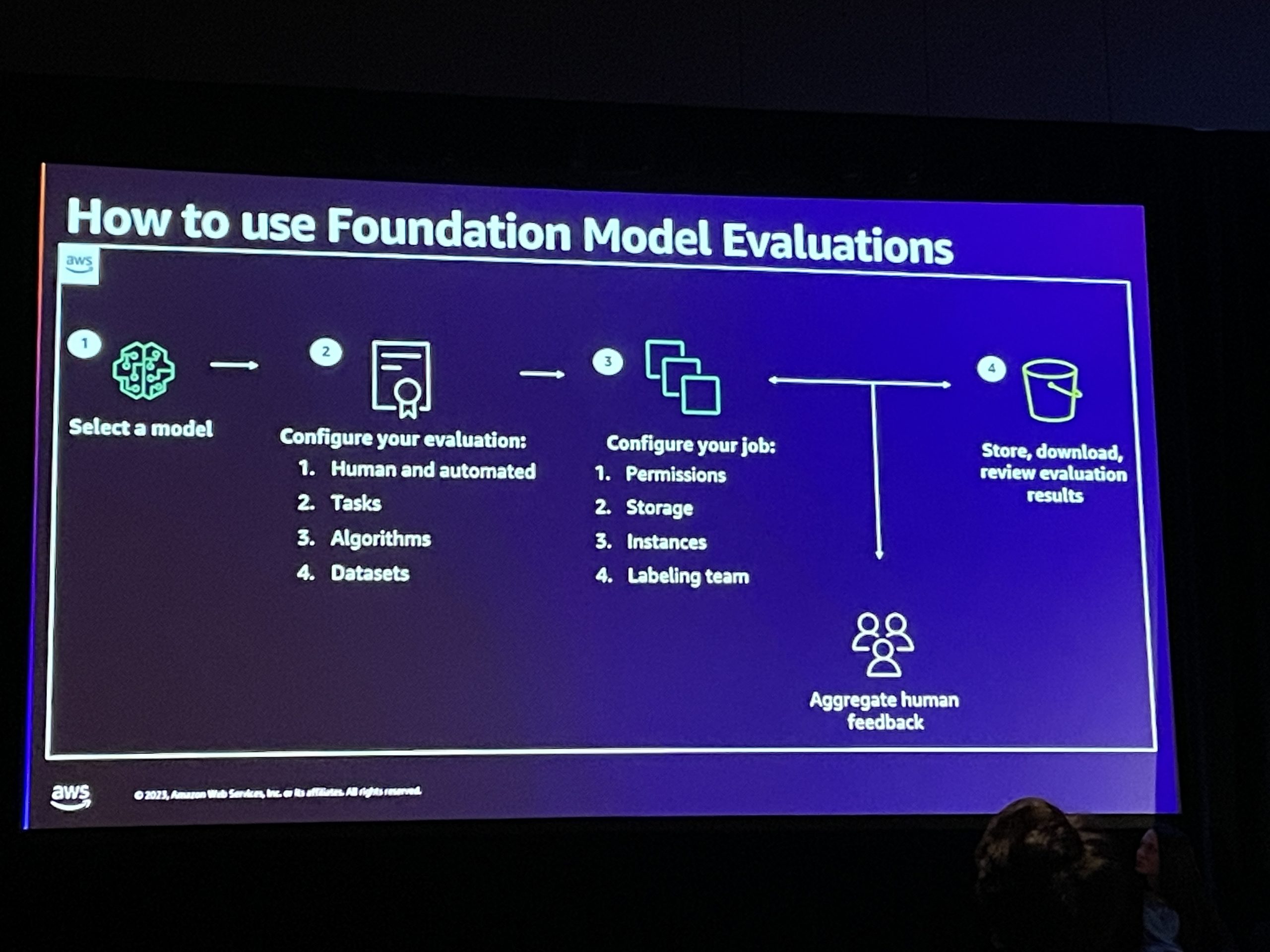

アルゴリズムと人間による評価のためのエンタープライズレベルの機能を提供するように設計されており、データサイエンティストやエンジニアが人間のアノテーターやビジネスオーナーと補完的に作業し、モデルの選択や最適化に関する意思決定を行うことができます。

コメント

Indeed では求職者の優先順位付けや、AI モデルにおける公平性と公正性の確保など責任あるAI開発を実践しているとのことでした。

AIが生成するコンテンツにおけるIndeedの公正さと責任には、差別、毒性、排除、偏見、事実誤認を削除・回避する必要があると述べており、ここ数年でAIが生成したものに対しての世の中の感覚は非常に敏感になっていると思います。モデルを迅速に評価し、AI 開発を迅速に回すことが重要だと感じました。

参考

![【AWS re:Invent 2023】始めよう。サーバーレスSaaSアーキテクチャの構築[SEG206]](https://iret.media/wp-content/uploads/2023/08/reinvent2023-220x110.png)