セッションタイトル: Symphony taps Google Cloud generative AI for voice analytics in financial services

スピーカー: Haris Ioannou, Michael Lynch, Han Wang

そもそも、Chirpとは?

Speech-to-Text API v2の基礎モデルです。

Chirp is a version of a Universal Speech Model that has over 2B parameters and can transcribe in over 100 languages in a single model.

引用元:https://console.cloud.google.com/vertex-ai/publishers/google/model-garden/chirp-rnnt1

Chirp は、20 億を超えるパラメーターを持ち、単一のモデルで 100 以上の言語で文字起こしできるユニバーサル スピーチ モデルのバージョン。

セッション本編です

2024年Cloud Speechは何が起こる!

<

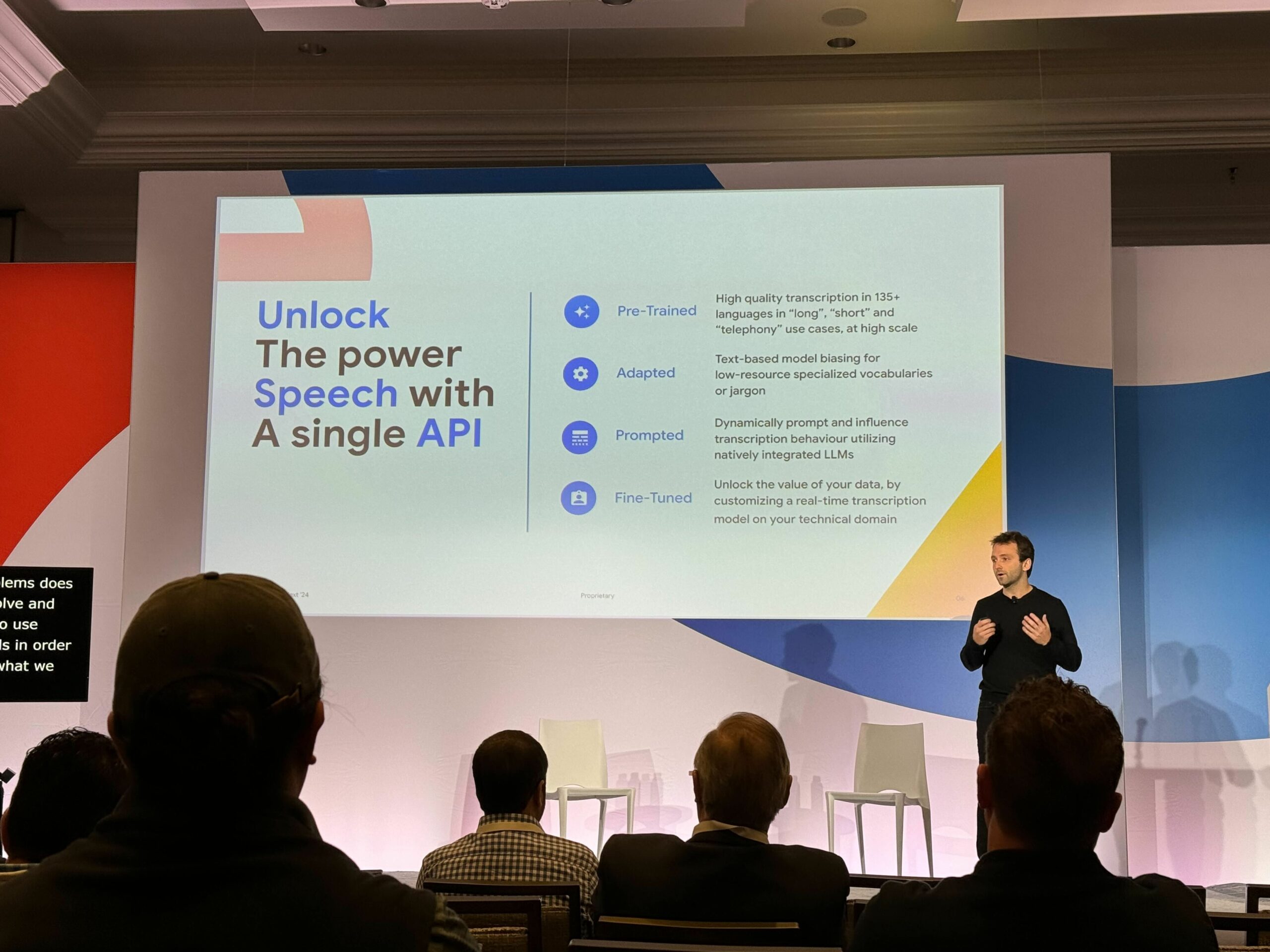

h4>解き放つんだ。音声の力を。うおおお

– 事前学習済み:

音声の使用用途にあわせて、複数用意しておいてくれるのは助かりますね。他にも現時点でも「medical_dictation」「medical_conversation」も選べます。

チューニングさっぱりわかりません系エンジニアからすると、このつよつよモデルをAPI叩くだけで助かりますね。

さらに精度上げておいてくれるということですね。そのうち心の声も聞き取れそう。

– 適応:

通常使う用語と同じ言葉の専門用語だったとしても、聞き分けてくれるというもの。

医療、トレーダー、銀行などなど、ムズカシイ専門用語は、生身でも難しいというのに。

– プロンプト:

ネイティブのLLMを使用して、動的にプロンプトと文字起こしをする。それが振る舞いに影響する。

– ファインチューニング:

特定の用途になどにカスタマイズもできるそう。チューニングさっぱりわかりません系エンジニアからすると、そわそわしますね。

モデルガーデンではなくAPI側でもよりカスタマイズできるようになるんでしょうかね。

Chirp 2待ちきれないですね

- SOTAのパフォーマンス改善

- Whisperにたいして、最大67%の相対的なWER(Word Error Rate)改善

- バックグランド・ノイズがあっても、英語と句読点における98%の精度を達成

- テーブル平均値を約300%向上

- 問題のある言語検出は、26言語から1つ指定する画像のように、送信元・送信先を指定できるとのこと。

つまり、問題があった場合どうしますか?という設定のようですね。どこまで推論してくれるんでしょうか。たのしみですね。

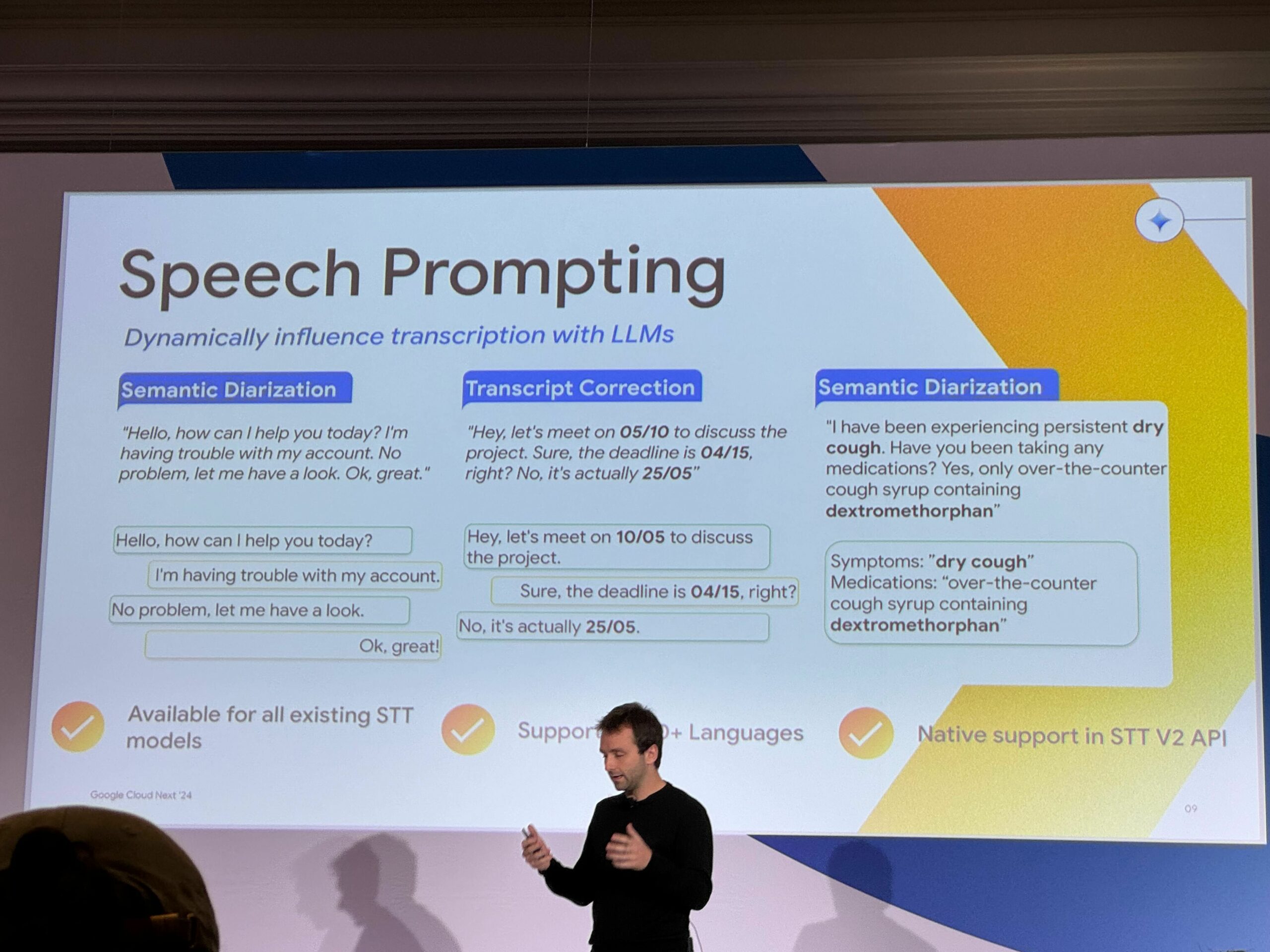

- セマンティック・ダイアリゼーション

- トランスクリプト・コレクション

特に注目のポイントは、2番目の例の様々な場所からでも、その土地の日付形式に修正してくれるというもの。

細かい点ですが、アメリカと日本で表記が逆のものが多いので、助かりますね。(だたし、あくまで生成AIなので自分自身で最終チェックする工程は、まだとても大事ですね…)

まとめる

Chirp 2でどこまで進化するのかが、楽しみなのと英語以外の言語たちの精度も上がることを期待せずにはおれませんね。

あと、電話のチャットbotも日本対応することを切に願っています…(ひとりごと)