アイレット株式会社の森柾也です。

Google Cloud Next 2025のOpening Keynoteで発表された内容について速報としてご紹介します。

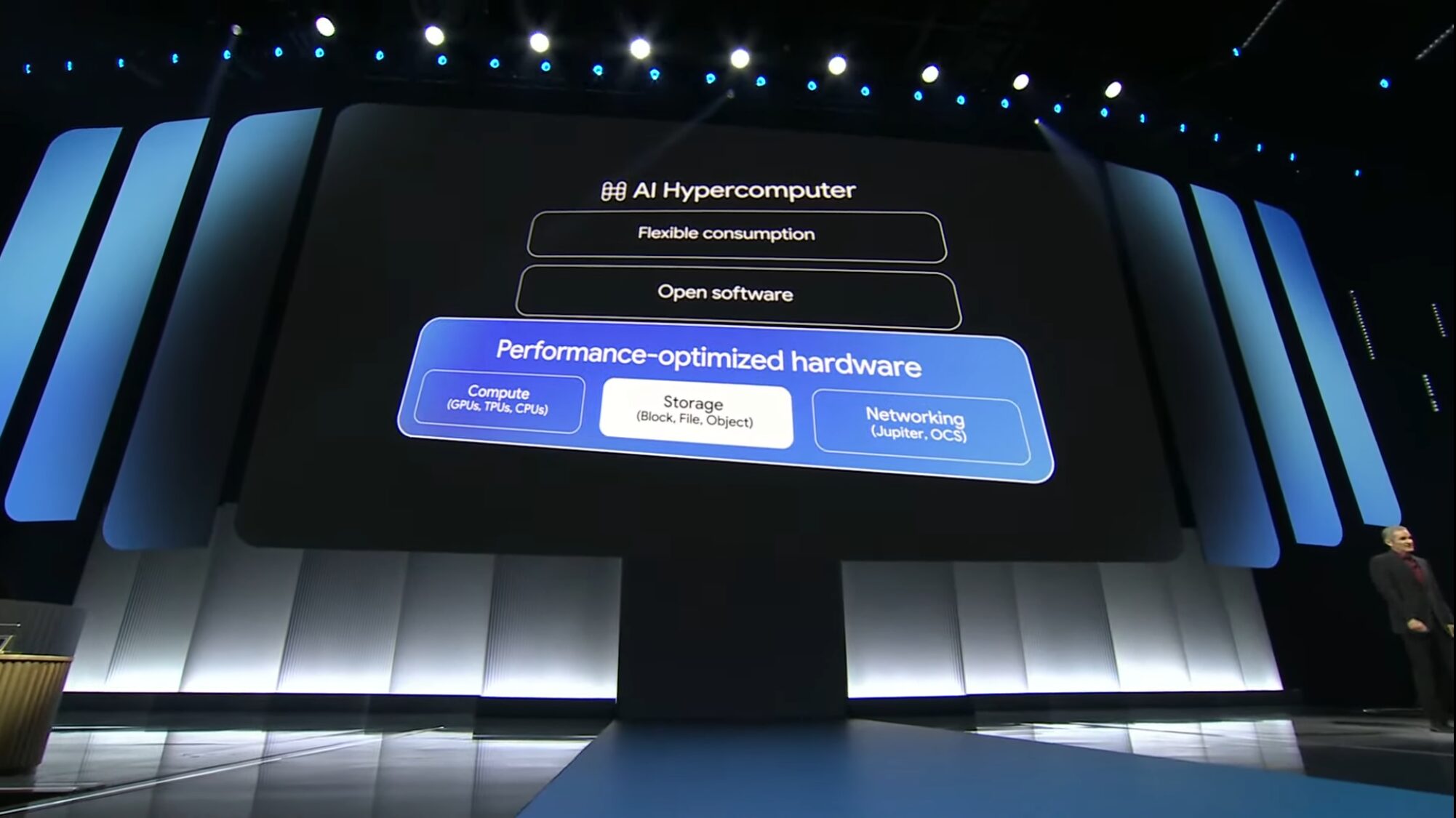

AI Hypercomputer

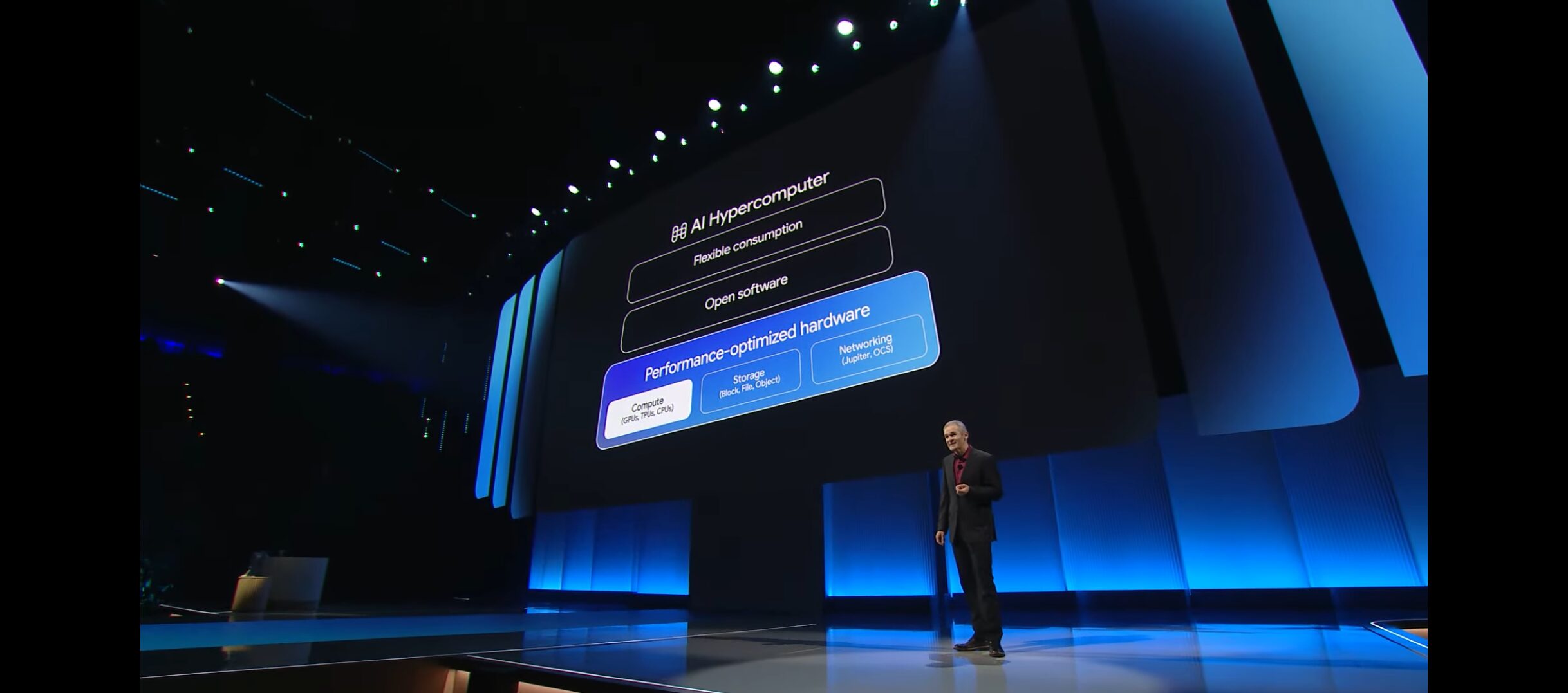

GoogleのAI Hypercomputerは大きく分けてハードウェア、ソフトウェア、柔軟な利用形態の3つからなります。

本記事では、Keynote で発表されたハードウェアのアップデートを中心に速報をご紹介します。

AI Hypercomputer: Compute

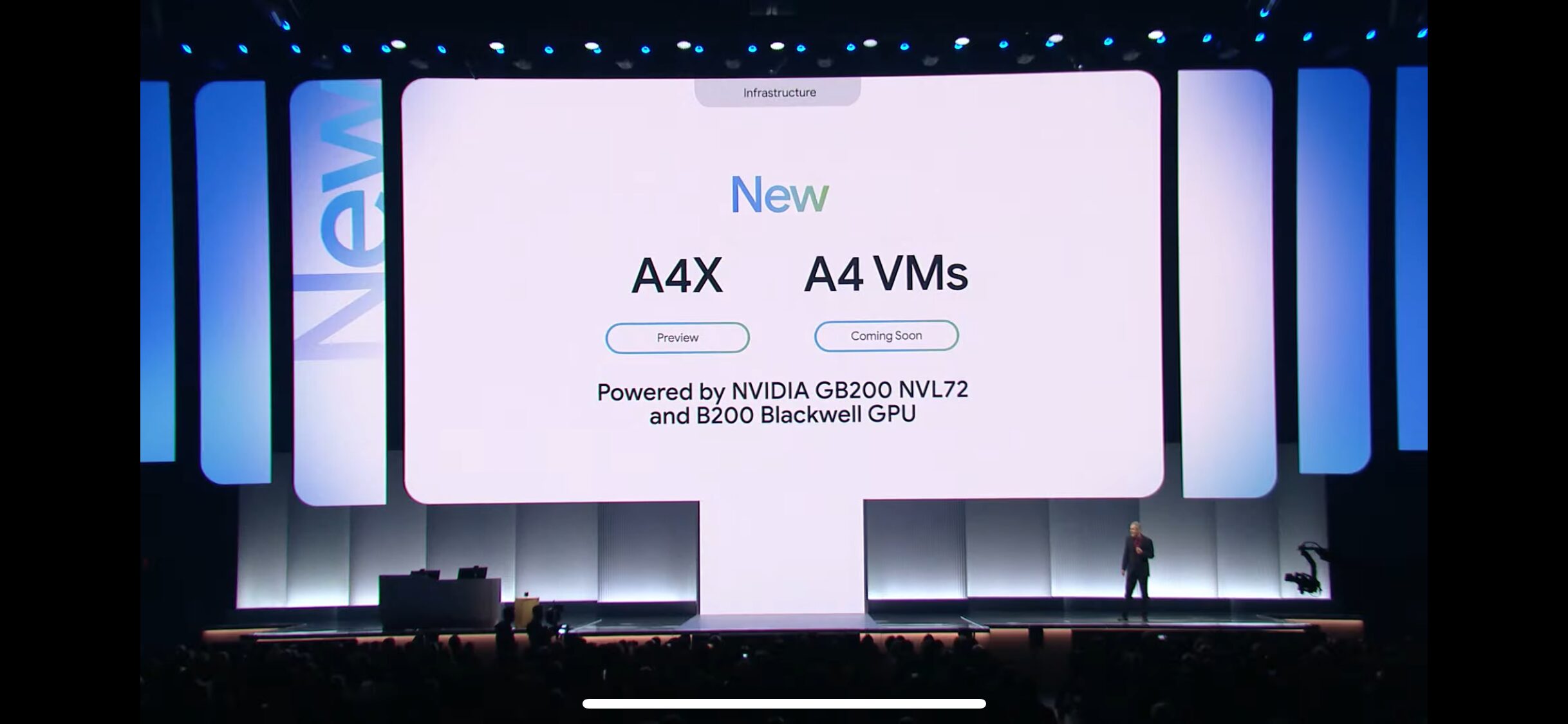

新たなインスタンスタイプ A4X (Preview), A4VMs (Soon) が発表

強化されたトレーニング パフォーマンス:

GB200 NVL72 システムあたり 1 エクサフロップを超える A4X は、NVIDIA H100 GPU を搭載した A3 VM と比較して、

LLM トレーニング パフォーマンスが 4 倍向上します。

引用: https://cloud.google.com/blog/products/compute/new-a4x-vms-powered-by-nvidia-gb200-gpus?hl=en

モデル開発に利用できるような、GPUを積んだインスタンスタイプが新たに発表されました。

これまでNVIDIA H100 GPUを積んだA3インスタンスがありましたが、A4XはLLM トレーニングにおいてA3インスタンスの4倍の性能があるとのことです。

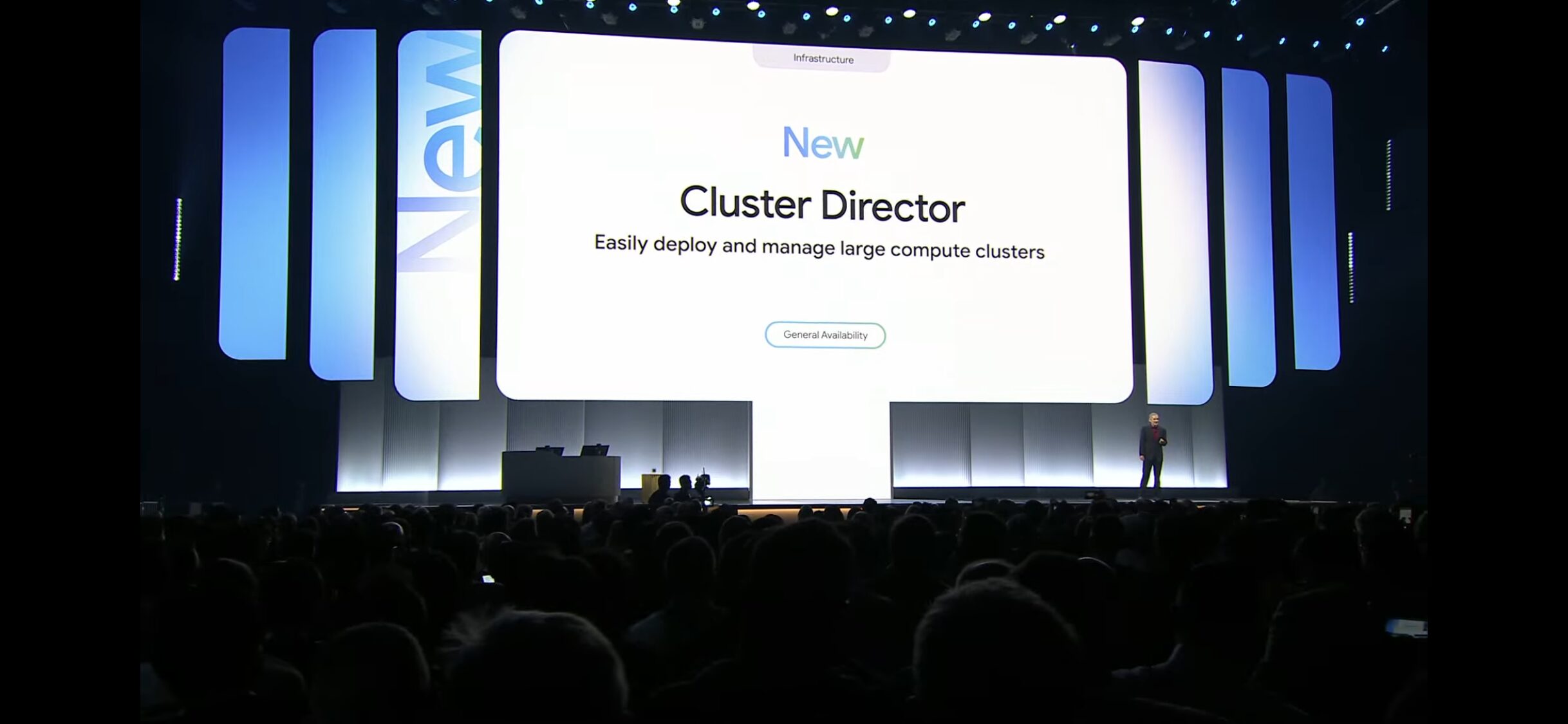

Cluster Director が GA

Cluster Director(旧称:Hypercompute Cluster)を使用すると、物理的に共存するVM、ターゲットを絞ったワークロード配置、高度なクラスタメンテナンス制御、トポロジを考慮したスケジューリング機能により、複数のアクセラレータを単一のユニットとしてデプロイおよび管理できます。

引用: https://cloud.google.com/ai-hypercomputer/docs/cluster-director

大規模なコンピュートクラスターのデプロイや管理を容易にするサービスであるCluster DirectorがGAされました。

HPC構成では定期的なメンテナンスイベントによりジョブが停止することがあり、学習のやり直しなどが課題としてありました。

今回、Cluster Directorによってメンテナンスイベントのコントロールやスケジューリングができるようになったため、メンテナンスイベントによる影響をコントロールすることで、より効率的な学習が期待できると思います。

AI Hypercomputer: Storage

新しいストレージクラス Hyperdisk Exapools (Preview) が発表

大規模かつ最も要求の厳しいAIトレーニングワークロード向けに特別に設計されたストレージプールの新しいバリエーションであるHyperdisk Exapoolsも発表します。

引用: https://cloud.google.com/blog/products/compute/delivering-new-compute-innovations-and-offerings?hl=en

AIトレーニングのワークロードに利用できる新しいストレージクラスとして、Hyperdisk Exapoolsが発表されました。

Google Cloud Hyperdiskは、ワークロード固有の容量とパフォーマンスを個別に調整できるクラスです。

今回発表されたExapoolsでは、数エクサバイトの容量とテラバイト/秒のスループットを提供するブロックストレージのプロビジョニングが可能とのことです。

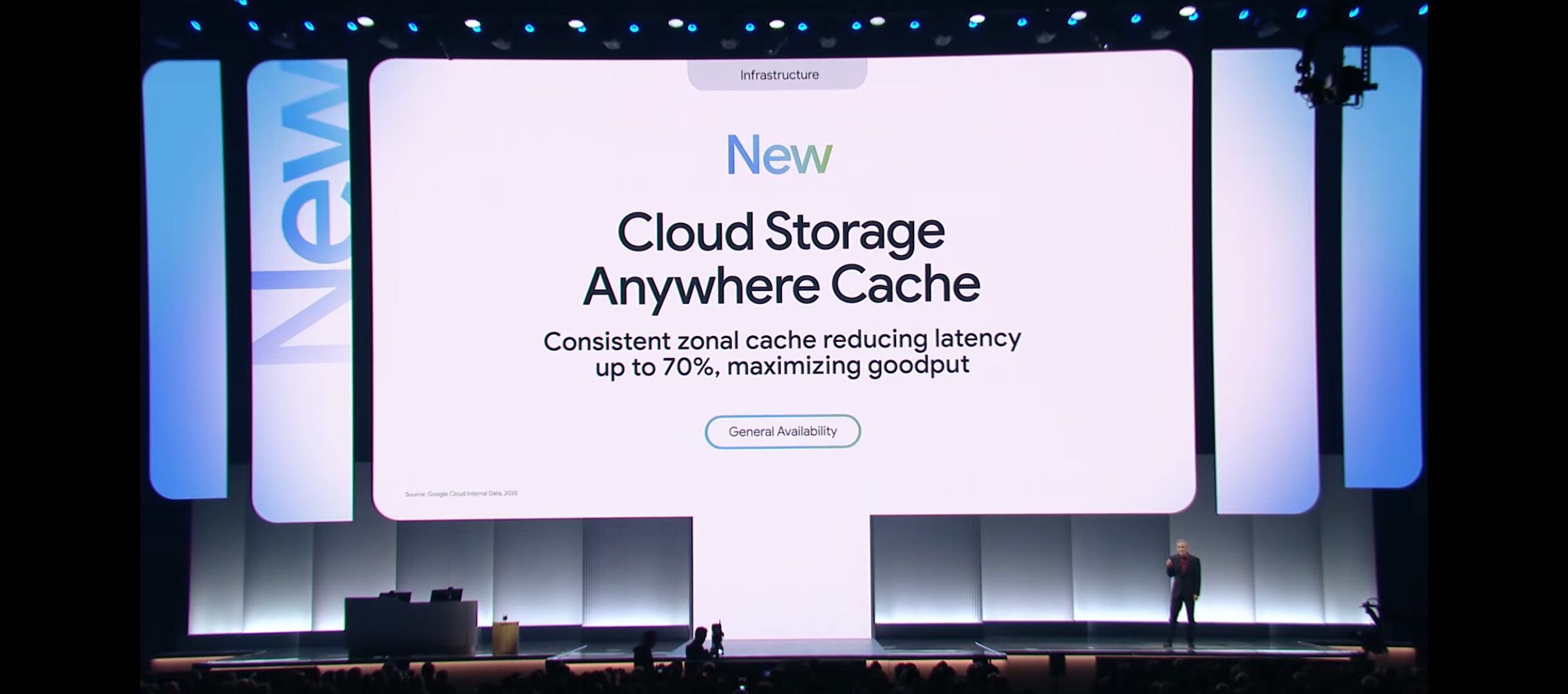

Cloud Storage Anywhere Cache がGA

Anywhere Cache は、ML モデルのトレーニングや分析ワークロードの実行に使用されるデータなど、

変更頻度が低く読み取り頻度が高いデータをキャッシュに保存する場合に最適です。

https://cloud.google.com/storage/docs/anywhere-cache?hl=ja

Cloud StorageのAnywhere Cacheがリリースされました。

Cache によりデータへのアクセスが高速化され、ワークロードと同じゾーンにキャッシュを作成できるため他リージョンへのデータ転送の回避が可能になります。

読み取り頻度が高いAIワークロードにおいて、トレーニング時間の削減につながる機能です。

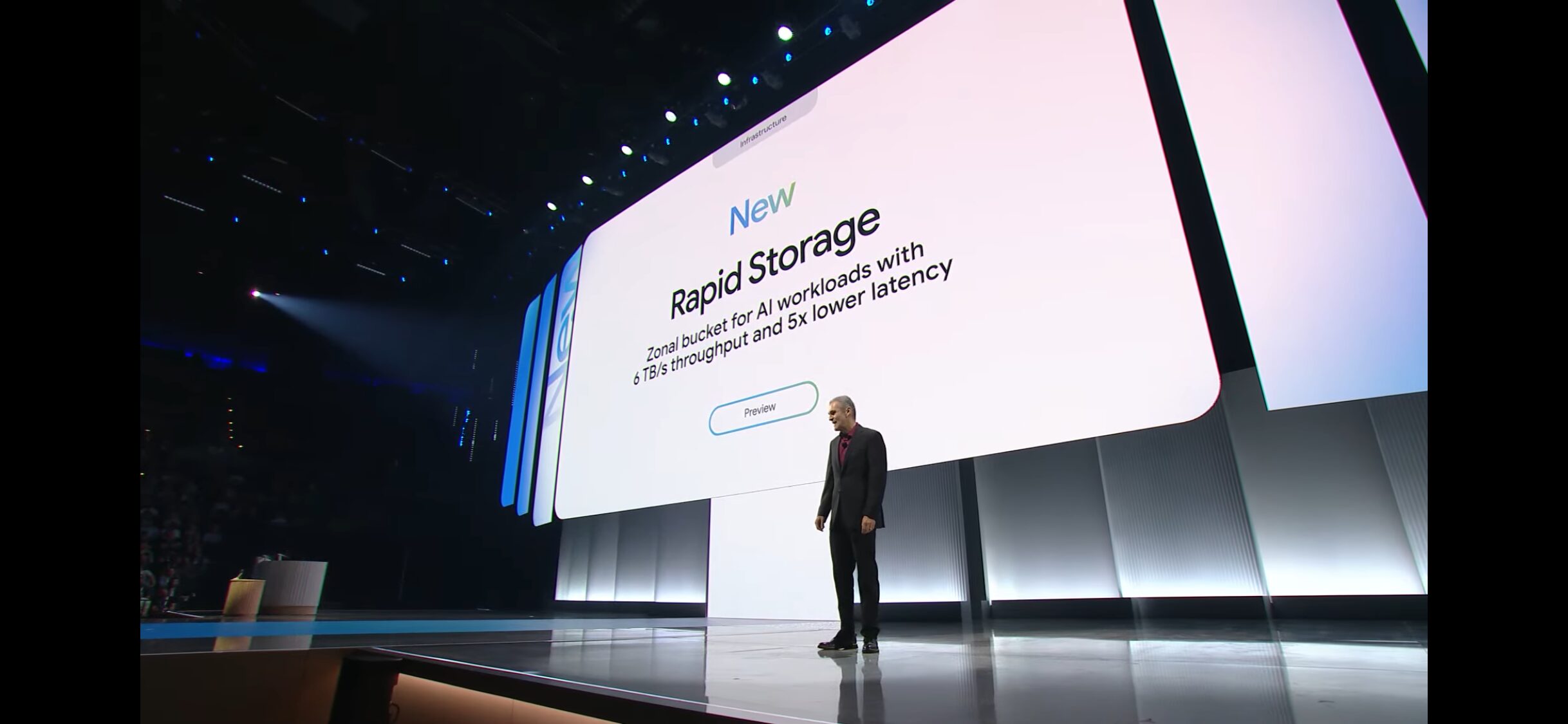

Rapid Storage (Preview) が発表

AIワークロード専用のZonal BucketとしてRapid Storageが発表されました。

AIワークロード向けに6TB/sのスループットを提供するとのことで、こちらもトレーニング時間の削減に繋がりそうな新機能です。

まとめ

以下の3つの進化が印象的でした。

- コンピューティングパワーの向上

- 新しいA4Xインスタンスが登場し、LLMのトレーニング速度が4倍に。

- ストレージ性能の強化

- Hyperdisk Exapoolsによる大容量データの高速処理

- Rapid Storageの6TB/sという高速スループット

- Anywhere Cacheによるデータアクセスの最適化

- 運用管理の改善

- Cluster DirectorによるHPCクラスターの効率的な管理

特にCluster Directorによって、ワークロードで課題となるVMインスタンスのメンテナンスイベントをコントロールできる点は、学習の手戻りを減らすことに繋がるため、非常に良い機能だと思いました。

これらの進化により、AIモデルの開発やトレーニングがより効率的に行える環境が整ってきたと思います。今後もGoogle CloudのAIワークロードへの取り組みが楽しみです。