はじめに

この記事はGoogle Cloud Next 2025で公開されたセッション「Master serverless gen AI with Gemini and Cloud Run」についてのセッションメモです。誤りなどがありましたら随時、修正していく予定です。

本セッションを理解するために必要な知識をおさらい

この記事をより深く理解するために、知っておくと良いと思われる関連用語を以下に列挙します。

【AI / 機械学習関連用語】

RAG (Retrieval-Augmented Generation)

外部の知識ベース(例: 社内文書)から関連情報を検索し、それを基にAIが応答を生成する技術

ベクトルデータベース (Vector Database)

テキストや画像などのデータを「ベクトル」と呼ばれる数値の配列に変換して意味的な類似性に基づいて高速に検索できるように設計されたデータベース。

RAGでよく利用される。

【Google Cloud 関連用語】

Gemini

Google DeepMindが開発した最先端のAIモデル群、およびそれを利用したサービス(この記事ではAIモデルと開発支援機能を指す)。

Cloud Run

コンテナ化されたアプリケーションをサーバーレスで実行できるサービスであり、Knativeというオープンソースプロジェクトを基にしている。

開発者はアプリケーションのコードに集中でき、インフラのプロビジョニングや管理を意識する必要がない。自動スケーリング機能があり、トラフィックに応じてコンテナインスタンス数を調整する。

参考:マネージド Knative サービスの Cloud Run を一般提供開始 | Google Cloud 公式ブログ

Vertex AI / Vertex AI Studio

機械学習モデルの開発、トレーニング、デプロイを統合的に行えるプラットフォーム。Studioはその中の開発環境。

GeminiおよびGoogle Cloudで提供される生成AIはVertex AI上で動作する。

Gemini Code Assist

Geminiベースのコードの生成、補完、デバッグなどをAIが支援するサービス

Artifact Registry

コンテナイメージや各種パッケージ(ライブラリなど)を保存・管理するサービス。

なお、旧サービス名はContainer Registryであり、現在はArtifact Registryに統合されている。

Binary Authorization

デプロイするコンテナイメージに対して事前に定義されたセキュリティポリシーを満たしていることを強制するセキュリティ機能。

(例: 脆弱性スキャン済み、特定の署名付きなどをセキュリティポリシーにできる)

Cloud Load Balancer

アプリケーションへのトラフィックを複数のインスタンスに分散させるサービス。高可用性やスケーラビリティ向上に寄与。

gcloud コマンド

Google Cloudリソースをコマンドラインから操作するためのツール。

【ソフトウェア開発 / クラウド基盤関連用語】

サーバーレス (Serverless)

開発者がサーバーの管理(プロビジョニング、スケーリング、メンテナンス等)を意識することなく、アプリケーションを実行できるクラウドの形態。

コンテナ (Container) / コンテナ化

アプリケーションとその実行に必要な依存関係(ライブラリ、設定ファイル等)をひとまとめにし

どんな環境でも同じように動かせるようにする技術。Dockerが代表的。

Dockerfile

コンテナイメージを構築するための手順を記述したテキストファイル。

ソフトウェア開発ライフサイクル (SDLC)

ソフトウェアの企画、設計、開発、テスト、デプロイ、運用、保守といった一連の工程。

セキュアなソフトウェアサプライチェーン

ソフトウェア開発からデプロイまでの全工程において、セキュリティリスクを低減するための考え方や仕組み。

DevSecOps(Development, Security, and Operations)とも関連する。

セッションの内容を要約するとつまり

課題と解決策

生成AI開発の複雑さとスピード要求に対し、Google CloudはGemini(AIモデル/開発支援)とCloud Run(サーバーレス実行基盤)の「最強タッグ」を組み合わせることで開発を加速させる解決策を提示しています。

Geminiの役割

GeminiはAIアプリのコア機能(コンテンツ生成、RAG等)を提供するだけでなく、Vertex AI Studioでのプロトタイピング支援やGemini Code Assistによるコーディング自動化により、開発プロセス自体を強力にサポートします。

Cloud Runの役割

Cloud Runは簡単なデプロイ、自動スケーリング、組み込みセキュリティ機能、GPUサポートを備え、インフラ管理の手間なく、スケーラブルで安全、かつ柔軟なアプリケーション実行環境を提供します。

コミュニティツールやOSSとの連携も可能

連携による相乗効果

GeminiとCloud Runを連携させることで、アイデアのプロトタイピングから実装、デプロイ、そして改善という開発ライフサイクル全体がシームレスに繋がり、迅速なアジャイル開発を実現します。

実践的な価値

この組み合わせは映画推薦や画像生成などの具体的な事例で有効性が示されており、開発効率の大幅な向上と市場投入までの時間短縮を通じて、新たなビジネス価値の創出を強力に後押しします。

セッションの内容(本編)

生成AI開発を加速する最強タッグ

近年、ビジネスにおけるAIの活用が急速に進んでいます。

しかし、その開発はアイデア創出からモデル選択、実装、デプロイ、そして運用まで、多くのステップと複雑さを伴います。

市場投入までの時間を短縮し、継続的に改善していくためには、効率的でスケーラブルな開発・実行基盤が不可欠です。

この課題に対するGoogle Cloudの強力な回答が、GeminiとCloud Runの組み合わせです。

Geminiは最先端のAIモデルであり開発支援ツールとして、Cloud Runはサーバーレスのコンテナ実行環境として、それぞれが強力な機能を提供しますが、この二つを組み合わせることで、生成AIアプリケーション開発のライフサイクル全体を劇的に加速させることができます。

本セッションでは、この「最強タッグ」がいかにして生成AI開発を変革するのか、その具体的な活用術とメリットを解説します。

Gemini:AIによる開発支援とインテリジェンスの中核

GoogleのGeminiは、テキスト、画像、音声、動画などを理解し生成できるマルチモーダルな大規模言語モデルであり、生成AIアプリケーションの「頭脳」としてだけでなく、開発プロセス自体も強力に支援します。

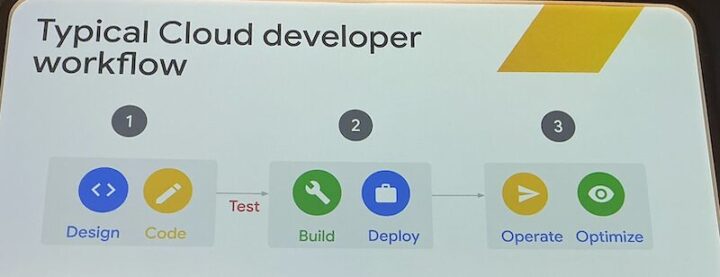

アイデア創出とプロトタイピング

Vertex AI Studioと連携し、対話形式でプロンプトを試行錯誤したり、アプリケーションのコアロジックを迅速にプロトタイピングしたりできます。

※セッション内のデモでは映画推薦チャットボットの基本的な応答生成ロジックが、Vertex AI Studio上でわずかな時間で構築されました。

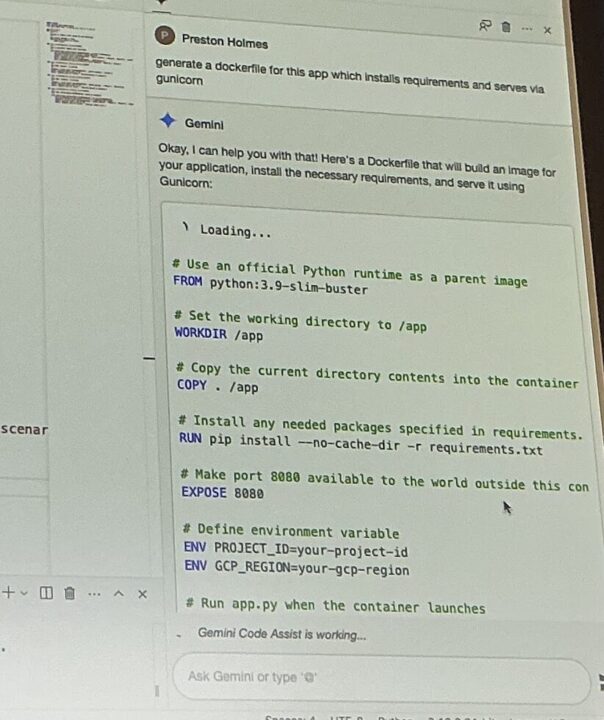

コーディング支援 (Gemini Code Assist)

エディタ内でGeminiの支援を受け、APIエンドポイントの実装、単体テストコードの生成、さらには既存コードの解説やDockerfileの作成まで開発の様々な場面で生産性を向上させます。

これにより、開発者はより本質的なタスクに集中できます。

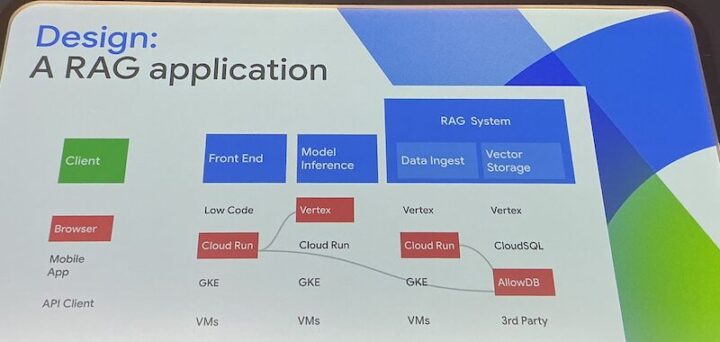

アプリケーションのコア機能

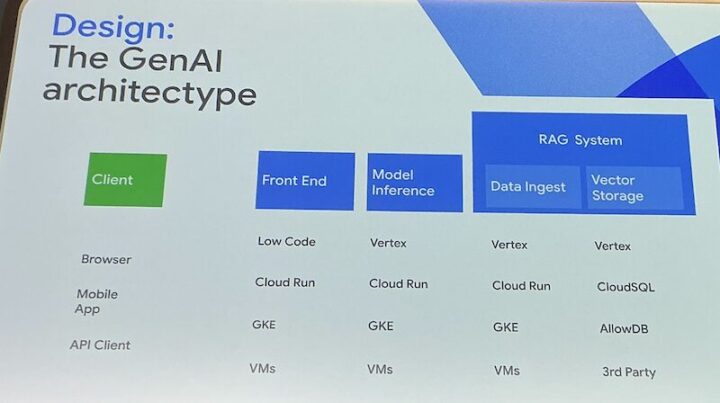

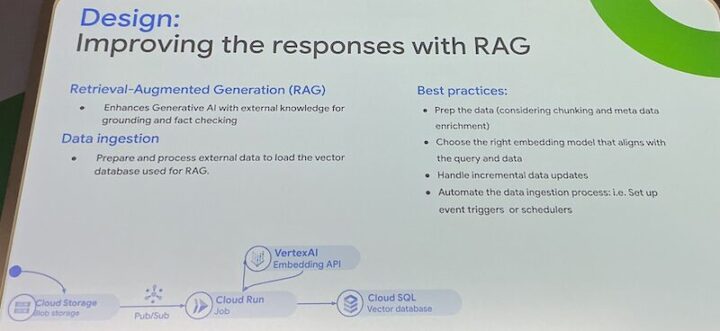

Geminiモデル自体をAPI経由で呼び出し、コンテンツ生成、要約、翻訳、質疑応答、RAG (Retrieval-Augmented Generation) アーキテクチャによる社内ドキュメント検索など、アプリケーションの中核的なインテリジェンスを提供します。

Cloud Run:スケーラブルでセキュアな実行基盤

開発した生成AIアプリケーションを、安定して、安全に、そして効率的に動かすための実行基盤がCloud Runです。サーバーレスのコンテナプラットフォームであるCloud Runは、インフラ管理の煩わしさから開発者を解放します。

簡単なデプロイ

ソースコードから直接、あるいはコンテナイメージを指定するだけで、WebアプリケーションやAPIを数秒から数分でデプロイできます。gcloud コマンド一つで、ビルドからデプロイまでを自動化することも可能です。

自動スケーリング

トラフィックの増減に応じて、コンテナインスタンス数をゼロから数千まで自動でスケール調整します。リクエストがないときはゼロになるため、コスト効率に優れています。急激な負荷増にも対応可能です。

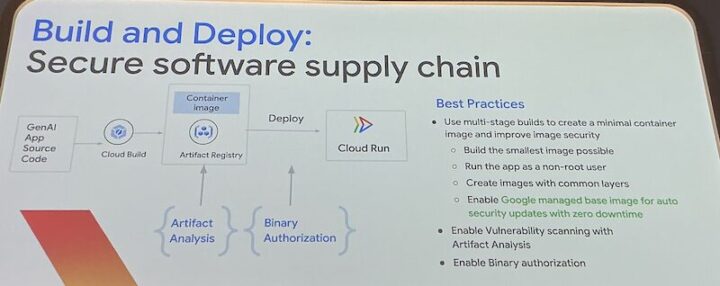

組み込みのセキュリティ

Artifact Registryでのコンテナイメージの脆弱性スキャンやBinary Authorizationによる信頼されたイメージのみのデプロイ強制など

セキュアなソフトウェアサプライチェーンの構築を支援する機能が組み込まれています。

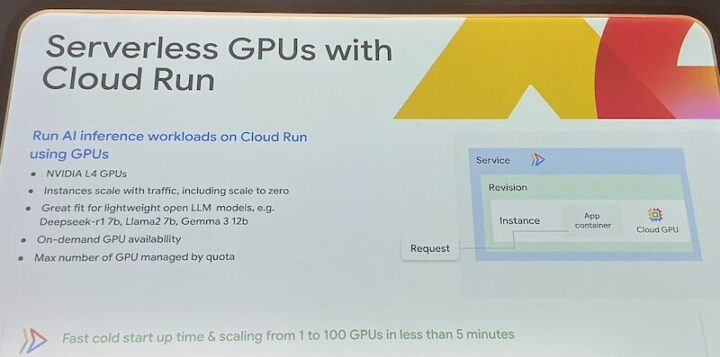

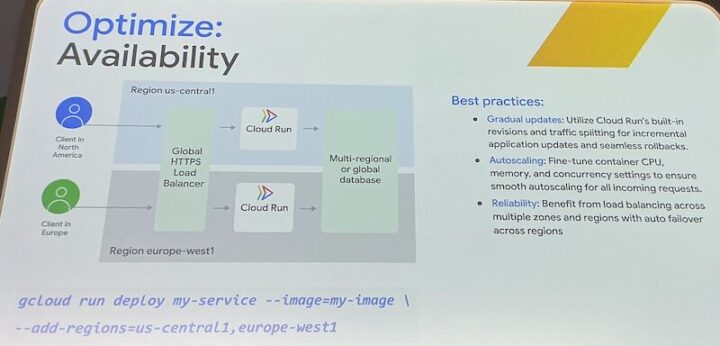

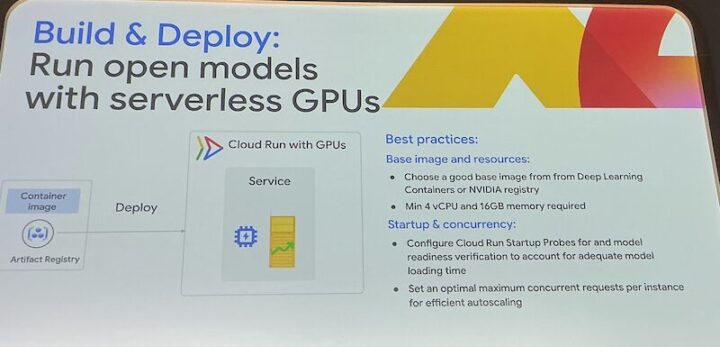

高可用性とGPUサポート

標準でマルチゾーンに冗長化されており、Cloud Load Balancerと組み合わせれば容易にマルチリージョン構成を実現できます。

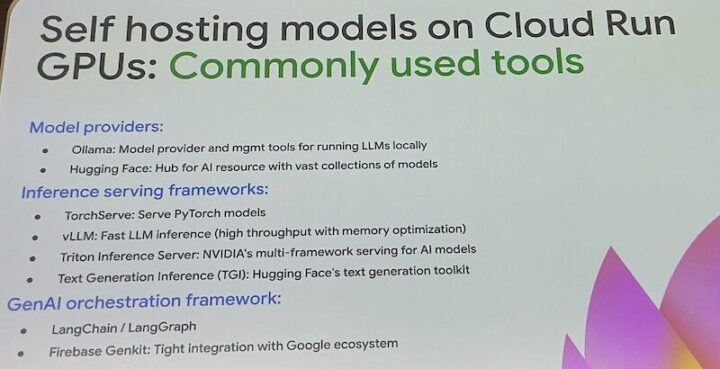

さらに、GPUインスタンスもサポートしており、オープンソースの大規模モデルなどをセルフホスティングする選択肢も提供します。

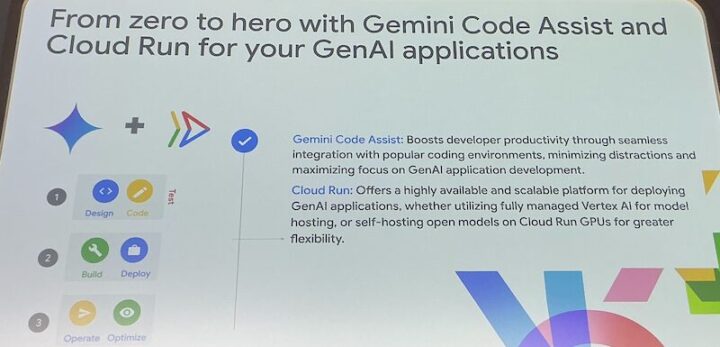

Gemini × Cloud Run:連携による相乗効果

GeminiとCloud Runを組み合わせることで、単体で利用する以上の相乗効果が生まれます。

開発から運用までのシームレスな体験

Vertex AI Studioでプロトタイプを作成、Gemini Code Assistでコードを実装

そしてCloud Runにワンコマンドでデプロイするというアイデアから本番稼働までの一連の流れがスムーズに繋がります。

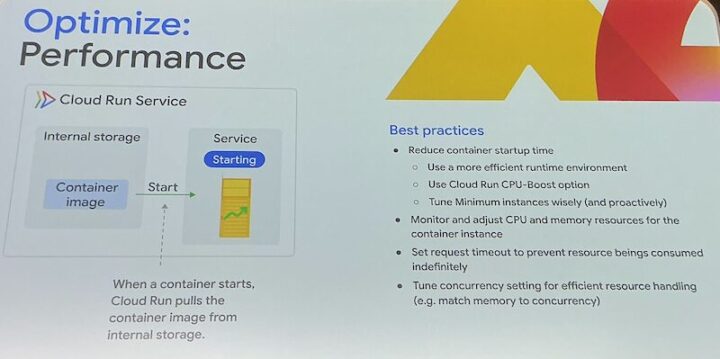

パフォーマンスの最適化についても説明されました。

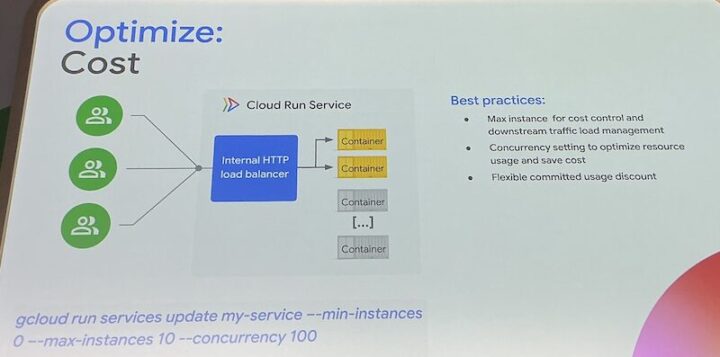

コスト最適化

柔軟なアーキテクチャ選択

Vertex AI上のマネージドなGemini APIを利用する構成、あるいはCloud Run上でオープンソースモデルをセルフホストする構成など

アプリケーションの要件やコスト、運用ポリシーに応じて最適なアーキテクチャを選択できます。

RAGアーキテクチャも、Cloud Run上でベクトルデータベースと連携させることで効率的に実装可能です。

迅速なイテレーション

ユーザーからのフィードバックや新しいアイデアに基づきGeminiでプロンプトやロジックを改善

すぐにCloud Runに再デプロイして効果を確認といったアジャイルな開発サイクルを高速に回すことができます。

実践事例

セッションでは、GeminiとCloud Runを活用した具体的なアプリケーション例が示されました。

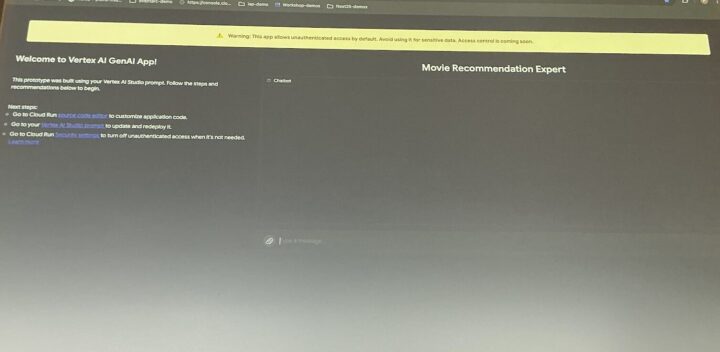

映画推薦チャットボット

Vertex AI Studioでプロンプトを作成してCloud RunにデプロイされたシンプルなWebアプリケーション

Geminiが推薦理由も説明する、インタラクティブな体験を提供します。

Movie Recommendation Expert

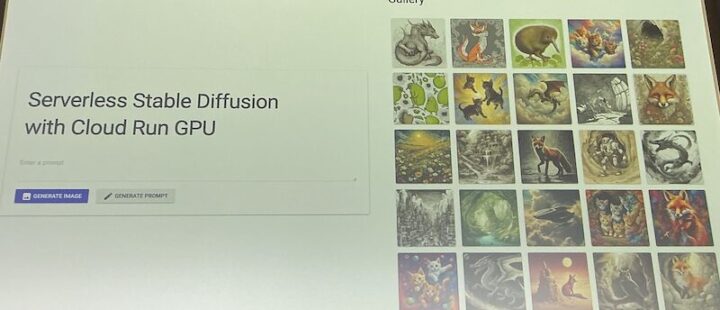

画像生成アプリケーション

Cloud RunのGPUインスタンス上でオープンソースの画像生成モデルをセルフホスト。API経由でプロンプトに応じた画像を生成します。

デモではServerless Stable Diffusion with Cloud Run GPUとして紹介

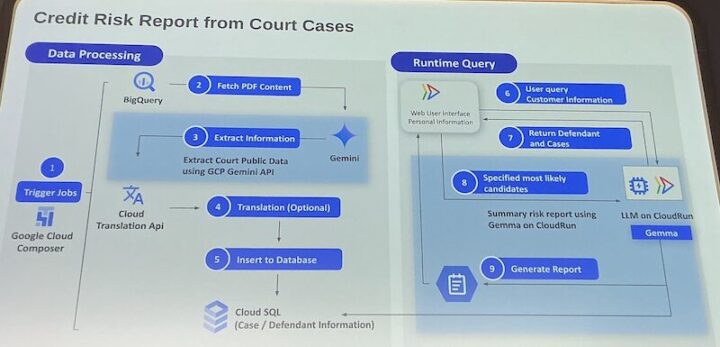

ゲストスピーカー事例

視覚言語処理技術と生成AI(Gemini)、そしてCloud Runを組み合わせ、特定のドメイン知識に基づいたインテリジェントなコンテンツ生成ソリューションを構築した事例も紹介され、その有効性が示されました。

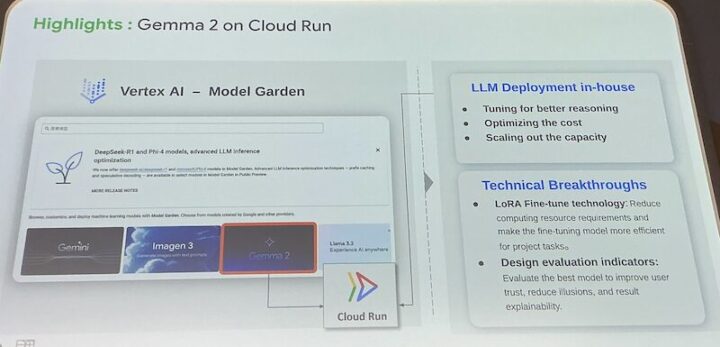

Gemma 2 on Cloud Runの紹介

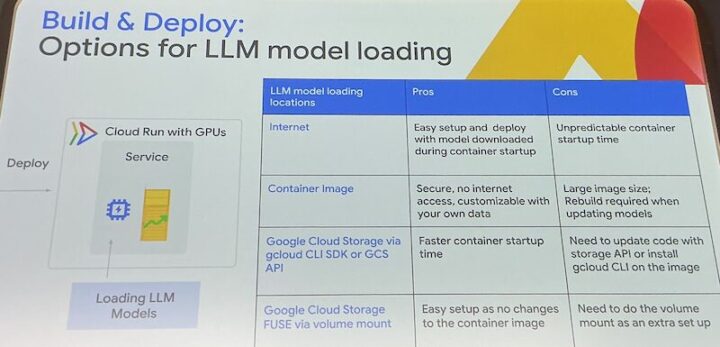

Run open models with serverless GPUs

Operation for LLM model loading

まとめ

GeminiとCloud Runの組み合わせは生成AIアプリケーション開発におけるアイデア創出、実装、デプロイ、運用の各フェーズを強力にサポートします。そして、開発プロセス全体を効率化・高速化します。

この「最強タッグ」は開発者がより創造的な作業に集中できるようにし、革新的なAIアプリケーションを迅速に市場に投入することを可能にします。

GeminiとCloud Runを活用することで、企業は生成AIのポテンシャルを最大限に引き出し、新たなビジネス価値を創造できるでしょう。

生成AI開発の次のステップとして、ぜひGeminiとCloud Runの活用を検討してみてはいかがでしょうか。

感想

本セッションはGeminiとCloud Runの組み合わせ使った生成AI開発の新たなスタンダードが紹介された内容でした。

Geminiの開発支援機能やCloud Runのサーバーレスな実行環境は、開発者にとって非常に魅力的な選択肢となるでしょう。

印象的だったこととしてはGeminiだけでなく、他の生成AIモデルとの組み合わせも紹介されているところであり

たとえば、セッション内のでスライドではHugging Faceについて触れられていました。

それ以外にもGemma 2やStable Diffusionなど、OSSの生成AIモデルをCloud Run上でセルフホストすることも可能であり

その場合はGPUインスタンスを利用することで、より高性能な生成AIアプリケーションを構築できることが示されていました。

Gemini Code Assistのデモも非常に印象的で、Google CloudにおけるAI駆動開発が示された瞬間でした。

私もLangChainやVertex AI SDKを使って開発をしたことがありますが、本セッションを通して違うアプローチもあることを知ることができました。

GeminiやCloud Runを活用した生成AI開発が進化していくことを期待しながら

今後もAI駆動開発のトレンドを追い続けていきたいと思います。