Google Cloud Next ’24 にて行われたセッション「Unlocking AI with a platform strategy for the next decade」のレポートです。

Google Cloud Next ’24 とは?

2024 年 4 月 9 ~ 11 日にラスベガスのマンダレイ ベイで開催されている、Google Cloud が主催する最大級規模のイベントです。

https://cloud.withgoogle.com/next/

登壇者

Google Cloud, GM & VP of Engineering, Cloud Runtimes

Chen Goldberg 氏

Google Cloud, Group Product Manager

Bobby Allen 氏

Shopify, VP, Head of Engineering

Farhan Thawar 氏

セッション内容

会場はSpotLightという名称で、その名の通り照明がたくさんある広めのステージでした。

セッション中はライブのようなライトの演出があって、とても華やかでした。

このセッションではリソース管理を通じて、ビジネスの成果を加速するAIの可能性について話されていました。

また、Geminiを利用して、インフラストラクチャ設計を合理化、トラブルシューティング プロセスの自動化、アプリケーション導入の最新化などを行う方法についても解説されていました。

デモが中心のセッションだったので、取り上げられたトピックの中から気になるものを掘り下げて解説したいと思います。

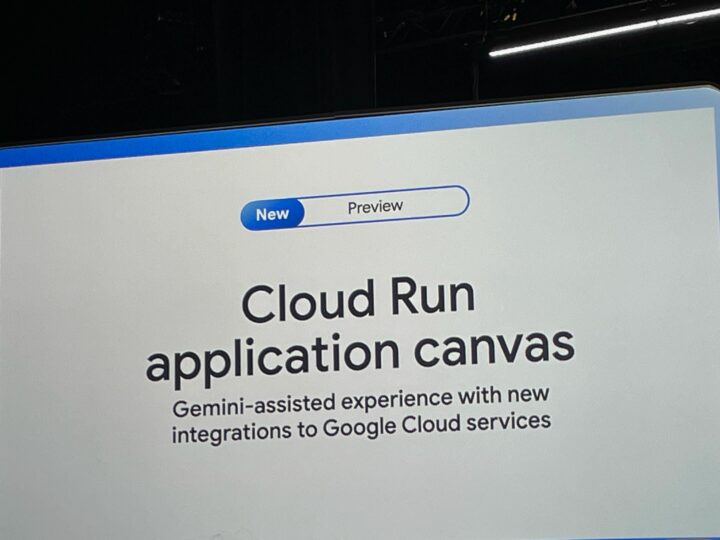

Cloud Run application canvas (プレビュー)

Cloud RunはFirestore、Memorystore、Cloud SQL、LBといったインフラストラクチャへの統合や、Vertex AIへの統合によるCloud RunサービスからVertex AI生成APIを利用できる機能がプレビューでリリースされています。

これらに加えて、アプリケーションの設計、運用、最適化を支援するAI「Gemini Cloud Assist」が統合されたことが発表されました。

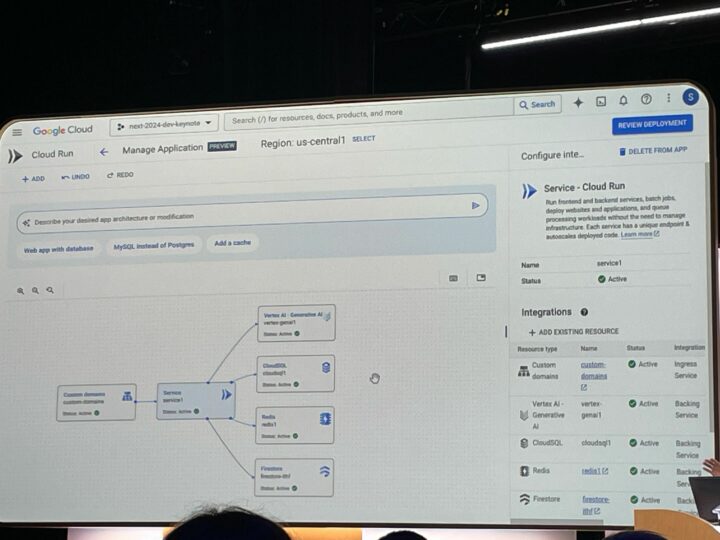

Cloud Run application canvasを使用すると、Geminiによって統合されたサービスやアプリケーションのデプロイを可視化することができます。

マネジメントコンソール上では以下のようなイメージです。 (画質が悪い)

実際に使ってみて、どのようなことができるのか検証してみたいと思いました。

LangChain support for Cloud Run (リリース済み)

LangChainは、LLMなどをすぐに使用できる多くのコンポーネントを備えているLLMアプリケーションの構築をするためのオープンソース フレームワークです。

これによりAIを利用したアプリケーションの普及を促進することが期待されています。

Vertex AI Vector Searchなど、これまでも多くのGoogleプロダクトとLangChainの統合がありましたが、本セッションでCloud Runへのサポートが発表されました。

Cloud RunはLangChainアプリのデプロイとスケーリングを最も簡単に行うことができるようになり、開発者に優しい体験をもたらすとのことです。

大規模なAIワークロード

Google Kubernetes Engine (GKE)はAIワークロード用の様々なニーズに最適なプラットフォームとして使用され続けており、AI導入の影響による急増加から、昨年GKEに対するGPUとTPUの使用は900%以上増加しました。

しかし、最近のAIモデルはサイズが非常に大きいことが多いため、大規模なAIモデルのトレーニングと提供を処理するためのプラットフォームが必要です。

そういったニーズにも応えられるように、以下がGAされました。

- GKE support for TPU v5p

- TPU v4と比較して、テキストから画像およびビデオへのモデルトレーニングで2.5 倍の高速化を達成

- A3 Mega

- NVIDIAのH100 GPUを搭載

- A3の2倍のGPU間ネットワーキング帯域幅を提供

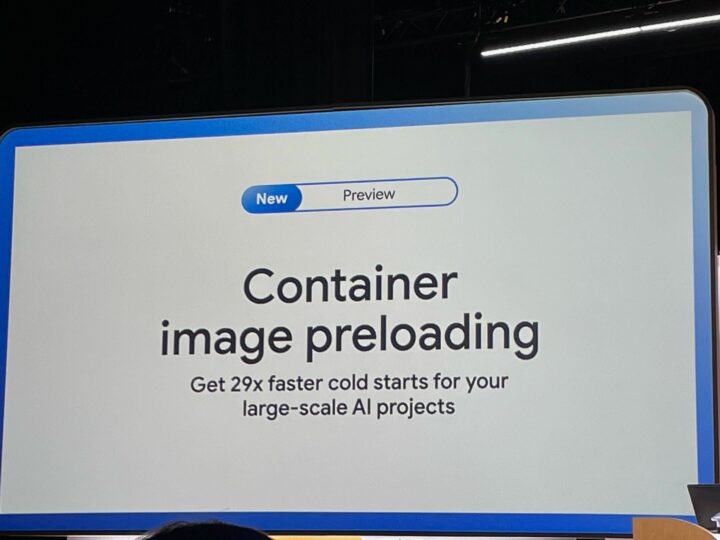

Container image preloading (プレビュー)

新しいノードにデータまたはコンテナイメージをプリロードできるようになりました。

これによって、大規模なAIプロジェクトでコールド スタートを29倍高速化し、AI推論のレイテンシを低く抑えながらGPU使用率を向上させ、コストを節約することができます。

また、GKEノード プールを作成するときに、新しいノードにコンテナイメージやモデルデータをプリロードして、デプロイや自動スケーリング、メンテナンスなどの中断からより高速に復旧できるようになります。

Gemini Cloud Assist (プライベートプレビュー)

AIワークロードを使用しているかどうかに関わらず、どのような環境でも管理や運用作業は存在します。

それらをサポートするための機能として、Gemini Cloud Assistが発表されました。

- コストの最適化

- 実行されたままになっているクラスターや、過剰なリソースを持つクラスターを特定し、対処法を提示

- トラブルシューティング

- Cloud Loggingのログを自然言語で取得可能

- 合成モニタリング

- 自然言語を使用して、ニーズに基づいたデプロイできるカスタムテスト スクリプトを生成

安定性、セキュリティ、コンプライアンスの確保

従来からあるようなアプリケーションの安定性、セキュリティ、コンプライアンスといった基本的領域への拡張も行われています。

以下のGKEの機能がプレビューリリースされました。

- GKE Threat Detection

- Security Command Centerを利用してGKE監査ログを継続的にモニタリング

- GKEクラスタに影響を与える脅威をほぼリアルタイムで明らかにする

- GKE Compliance

- クラスタからコンテナまでエンドツーエンドのカバレッジを自動的に提供し、最も重要なベンチマークに対するコンプライアンスをスキャン

- ほぼリアルタイムで一元化されたダッシュボードが利用可能であり、コンプライアンス レポートが自動的に作成される

感想

流行りのAIに関する新機能から、様々なワークロードへの適応、セキュリティにわたって新機能が続々と発表されました。

個人的には、Cloud Run application canvasが見た目からして面白そうと思ったのと、やはりGemini Cloud Assistは試してみたいと思いました。

Gemini Cloud Assistについては、他のセッションで詳しく取り上げられていたので、後ほど紹介したいと思います。