はじめに

DX開発事業部の北村です。

8月1日にGoogle Cloud Next Tokyo ’24に参加してきました。

『大規模言語モデル(LLM)をビジネス アプリケーションで活用するための基礎知識と現実的なアプローチ』セッションを聴講しましたので、セッションの内容とセッション内で紹介されていた以下のブログの内容を踏まえて一部紹介します。

ブログ:Gemini 1.5 のロングコンテキストを活かして AI を育てるアプローチ 〜 RAG の限界を軽やかに突破するために

セッション概要

タイトル:大規模言語モデル(LLM)をビジネス アプリケーションで活用するための基礎知識と現実的なアプローチ

登壇者:Google Cloud 中井 悦司 氏

公式より

大規模言語モデル(LLM)をビジネスに活用する際は、LLM を単体で使うのではなく、他の機能と組み合わせた「アプリケーション」を構築する必要があります。LLM の仕組みをわかりやすく説明した上で、LLM を組み込んだビジネス アプリケーションのアーキテクチャー、ユースケース、評価方法など、「やってみた」で終わらないための現実的なアプローチを解説します。

セッション内容

生成AIをどのように活用すれば効果的か、生成AIの回答の精度を高めるためにどのようにAIを段階的に育てていくのかを紹介いただきました。

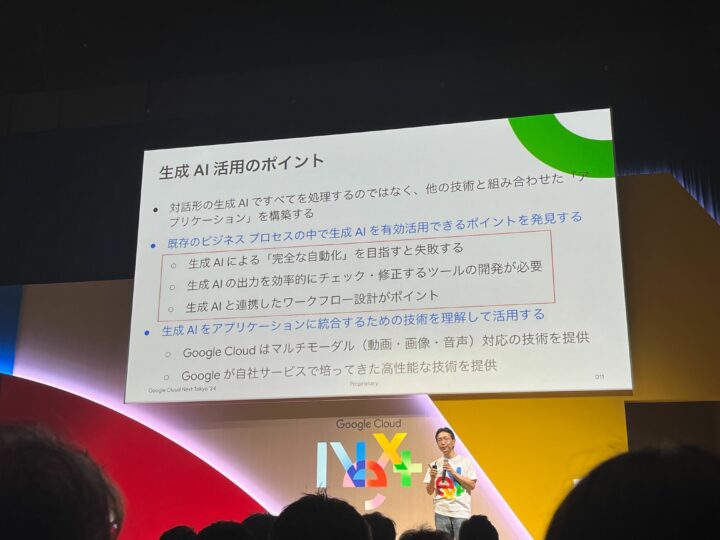

生成AI活用のポイント

突然ですが、皆さんは生成AIを活用してどのようなことを期待しますか?

- 非効率な業務を全自動化したい

- 業務の一部を自動化したい

- データ分析がしたい

など、様々な期待があるかと思いますが、中井氏は様々な期待に応えるための生成AIを活用するポイントは以下であるとおっしゃっていました。

生成AI単独で活用するのではなく、他の技術を組み合わせて「アプリケーション」のバックエンドとして組み込むのが最適だそうです。さらに、ユーザがプロンプトを知らなくても良いようにすることが重要だとおっしゃっていました。

そして、次に重要となってくるのが「業務のどこで生成AIを使うのか、使うべきでないのか」を明確にすることだそうです。

しかし、生成AIを活用する際に外せない懸念点が「ハルシネーション」です。

「ハルシネーション」を軽減する技術は「グランディング」「RAG」が有名ですが、「プロンプトエンジニアリング」が大変重要だとおっしゃっていました。その「プロンプトエンジニアリング」を活用して、以下の段階を経て「AIを育てる」ことが効果的だそうです。

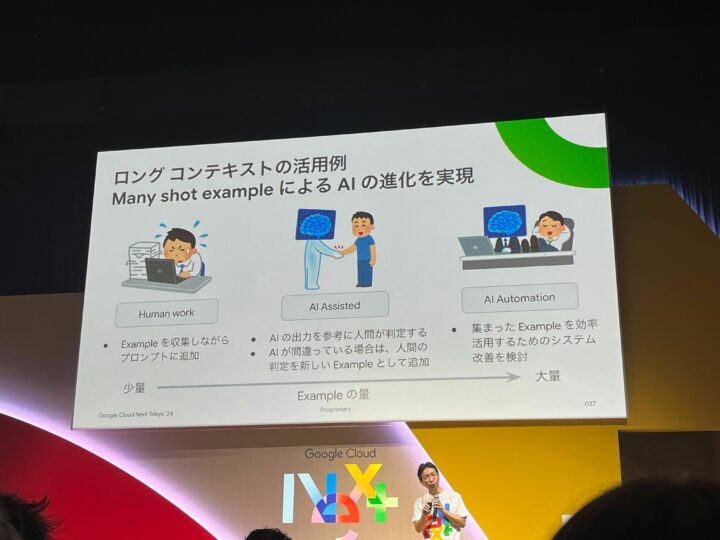

- Human work

- AI Assisted

- AI Automation

架空の例を挙げてそれぞれの段階を見ていきます。

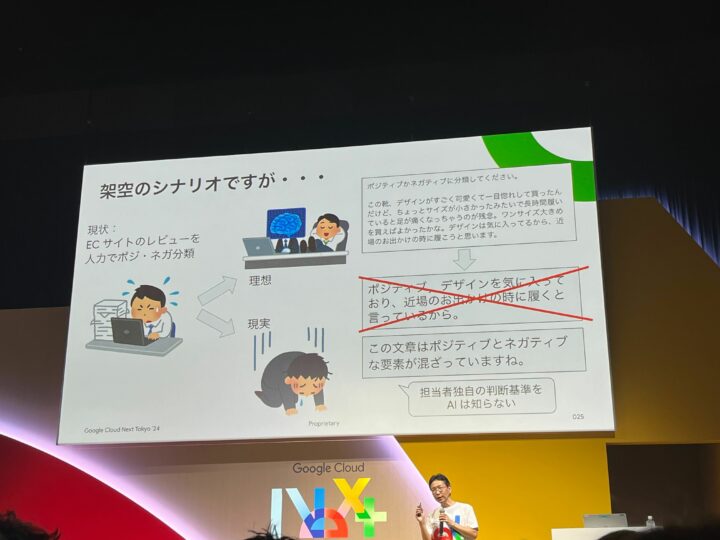

ECサイトの商品レビューコメントをポジティブ/ネガティブに分類する業務。ポジティブなコメントを目につくところに表示して宣伝効果を高めるといった目的を想定した作業。

現状、専任の担当者が人力でレビューのコメントをポジティブ/ネガティブに分類していますが、生成AIを活用して自動化しようとします。そこで、生成AIにプロンプトでレビューコメントを分類しようとしますが、期待した結果となりません。担当者独自の判断基準「暗黙知」を生成AIが理解しないためです。

AIの育て方(Human work)

そこで、AIを育てる一段階目です。

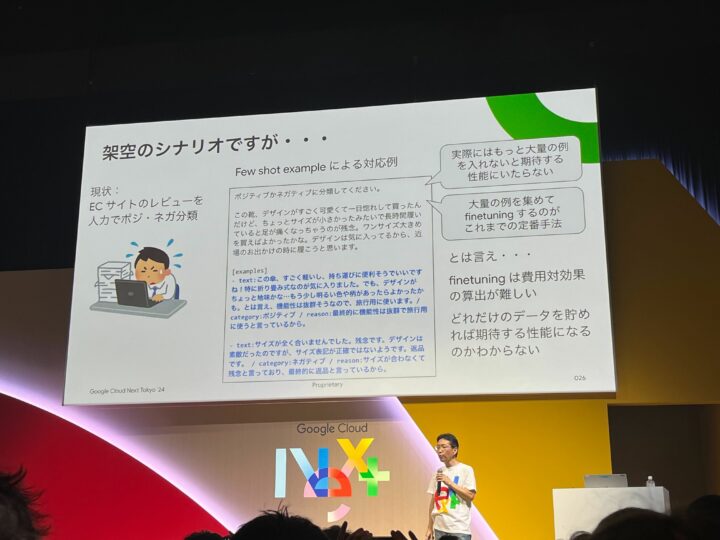

一段階目では、「Few-shot learning」というテクニックを使うそうです。

「Few-shot learning」とは、「入力内容」と「期待する出力内容」の具体例を複数プロンプトに埋め込み、担当者が期待する判断基準を類推させるテクニックです。以下の画像のプロンプトのイメージです。

しかし、このテクニックは入力する例が少ないため、多くのパターンに対応することが難しく、まだまだ期待できる出力が得られるとは言い難い状態です。

そこで、「Many-shot learning」というテクニックも活用していくそうです。

「Many-shot learning」とは、「Few-shot learning」で用意したような具体例をどんどん増やすことで、より多くのパターンに対応させていくテクニックです。具体例が少ない(Few)「Few-shot learning」、具体例が多い(Many)「Many-shot learning」ですね。

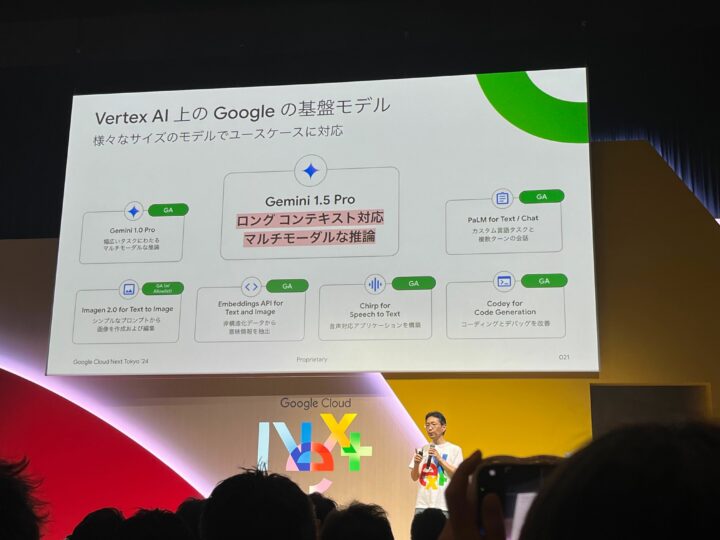

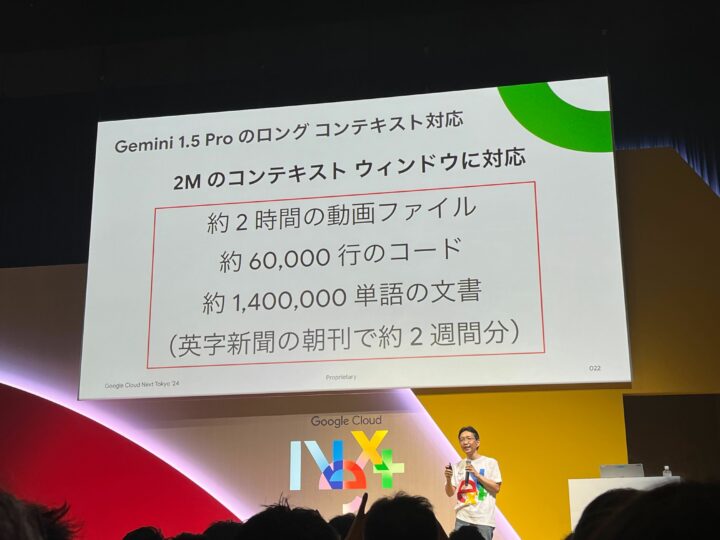

このテクニックを活用するためには、膨大な例を埋め込むため、それが可能な生成AIが必要となってきます。「Gemini 1.5 Pro」はロングテキストに対応しており、2Mのコンテキスト、1Mトークンの入力が可能なため、このテクニックには必要不可欠な生成AIとなります。個人的には、Geminiはマルチモーダルにも対応しており、テキストだけでなく様々な形式の例を与えることができるため、このテクニックを使ってAIを育てていく際により強力な武器となると感じました。

AIの育て方(AI Assisted)

そして、AIを育てる二段階目に移ります。

「AI の出力を参考に人間が判定する」段階だそうです。

一段階目で膨大な量の例を集めてプロンプトに埋め込みAIを育ててきましたが、それでも期待した出力が得られないことも多々あるそうです。

そこで、AIを育てる三段階目に移るために、『担当者の「暗黙知」をデータ化して「形式知」に変換するプロセス』がより重要になってくるそうです。具体的には、AIの判定を人間が確認し、判定が間違っていた場合は、担当者が考える正しい判定結果を新しいデータとして追加することで、AIの判定を改善していくということです。

また、この段階で複雑なシステムを設計・構築する前に、「いろいろなアイデアを手早く試せる簡単な仕組み」を見つけ出すことが成功の鍵だそうです。

AIの育て方(AI Automation)

そして、二段階目で良質なデータが十分に集まってくると、AIを育てる三段階目の全てをAIに任せられる「AI Automation」に到達します。

この段階では、良質なデータが十分に集まっているため、そのデータを効率的に活用するためのシステム改善を検討していきます。システム全体の設計を見直して、より高度なチューニングなどを行なっていきます。また、より良質なデータがあれば適宜追加していき、さらにAIを育てていきます。

中井氏は、生成AIの活用例として、最初から「AI Automation」は難しいため、「AI Assisted」のようなAIとのコラボレーションが最適だと強調されていました。そして、「AI Automation」に近づけていくようなアプローチが最も現実的だそうです。

まとめ

私は、このセッションを聴講し、生成AIの効果を発揮するためには、良質で大量のデータを集めることがかなり重要だと感じました。

これは、以前紹介した以下のセッションで学んだことと通づるところがあると感じており、「データを分析・収集する基盤」や「良質なデータを大量に集めること」の重要性を改めて感じました。

セッション:Google Cloud Next Tokyo ’24 セッションレポート『プロジェクト間での分析を可能にした高セキュリティな企業データ分析基盤の構築と生成AIの活用』

今回学んだ生成AI活用やAIの育て方のポイントを活かし、生成AIを活用したDX推進に活かしていきたいと思います。