セッション情報

- タイトル(英題):Monday Night Live with Peter DeSantis [KEY001]

- スピーカー:Dave Brown(AWS Vice President), Peter Desantis(AWS Senior Vice President)、Tom Brown(Anthropic CCO)

- セッションタイプ:キーノート(基調講演)

セッション内容

生成AIの技術革新を支えるAWSのハードウェア基盤の話がメインとなった基調講演でした。

ハードウェア基盤の技術革新

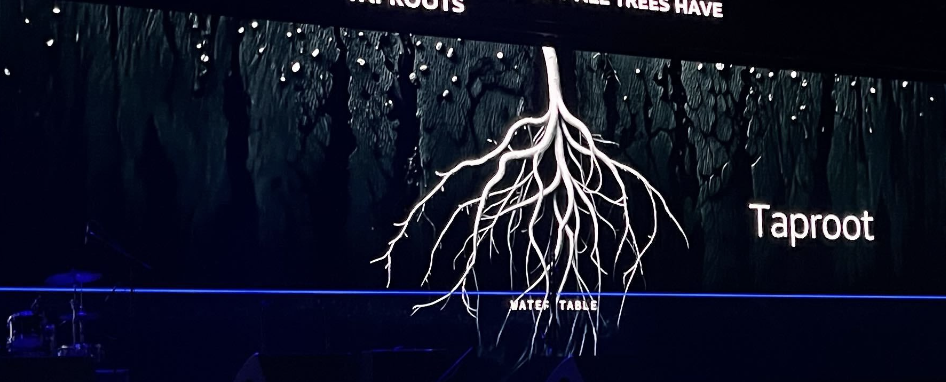

AWSのハードウェア基盤を樹木の根っこに例えて説明しており、ハードウェアの技術革新が生成AIの成長において如何に重要な役割を果たしているかアピールしていました。

ハードウェア基盤とはマイクロチップ、ラックの構成、光ケーブルなどです。

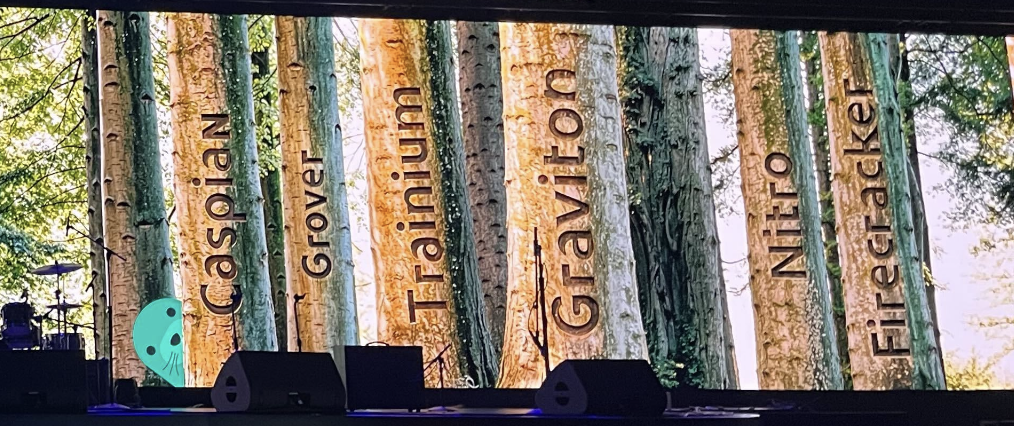

マイクロチップについてはGravitonは世代を追うごとに革新を続けていること、

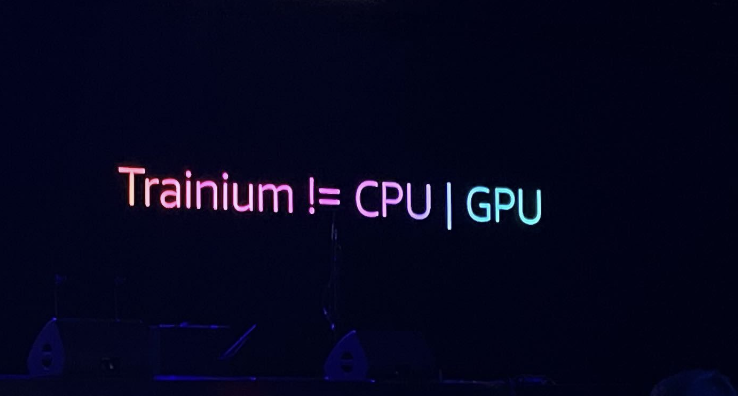

そして機械学習に特化するTrainiumはもはやCPUやGPUとは異なる概念だというお話もありました。

また、ケーブルまでAWSの技術革新の領域というところが驚きでした。

「10p10u」ネットワークという概念をつくっており(10PB(Petabyte)単位のデータを10マイクロ秒以下(Under)で送信するという概念)、

「10p10u」を実現できていることが、生成AIのレスポンス向上を支えているということでした。

10p10uに関しては過去にAWS公式記事も出ております。

「AWS Trainium 2 UltraServer」の発表

上記のケーブルや最新のTrainiumを搭載することで通信を極限まで高速化した「AWS Trainium 2 UltraServer」を開発しました。

64個のTrainiumを搭載しており、1兆個超えるパラメーターを扱うことができ、現在のAIより5倍の計算能力を提供します。(すごすぎて分かりませんねw)

実際の会場にもラックごと持ってきておりました。このサーバーの金銭価値を考えると搬入の時の緊張感が伺えます…。

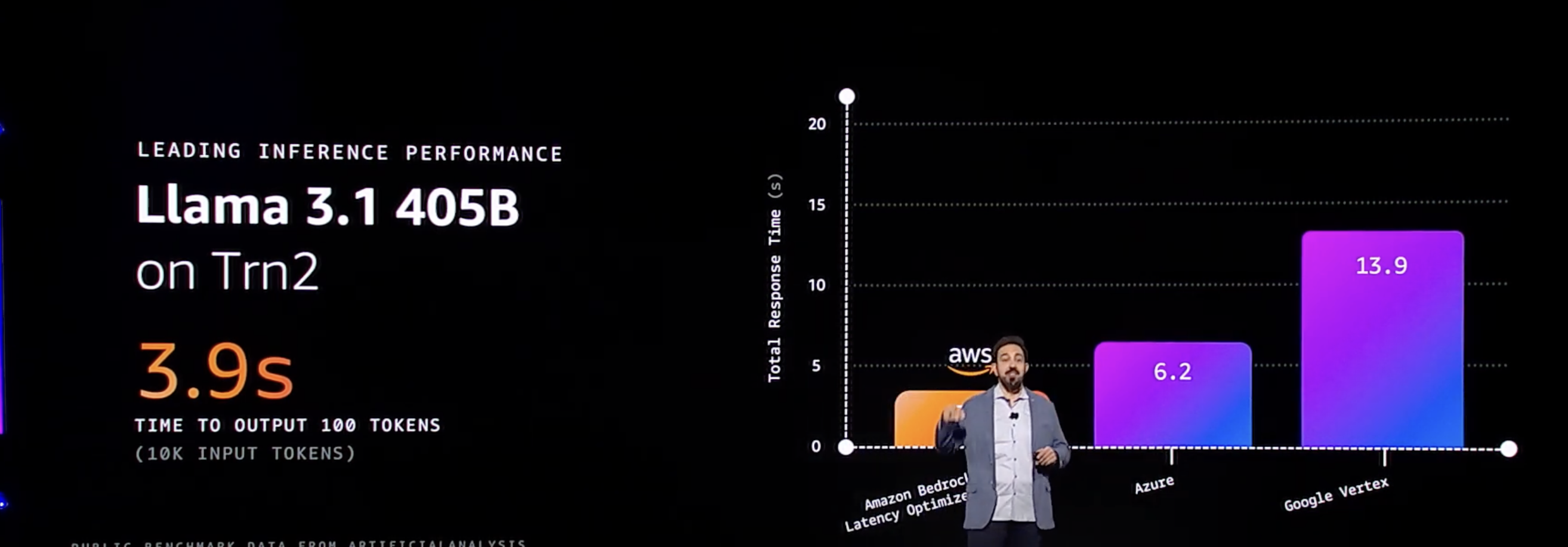

「latency-optimized inference for foundation models in Amazon Bedrock」のパブリックレビュー

弊社の西田が速報記事をあげておりますが、

Amazon Bedrockの基盤モデル向けレイテンシ最適化推論がパブリックレビューとなりました。

AnthropicのClaude 3.5 HaikuモデルとMetaのLlama 3.1 405Bおよび70Bモデルをサポートしており、精度を損なうことなく速度向上を実現しています。GoogleやAzureのモデルと比較しても速いことをアピールしていました。

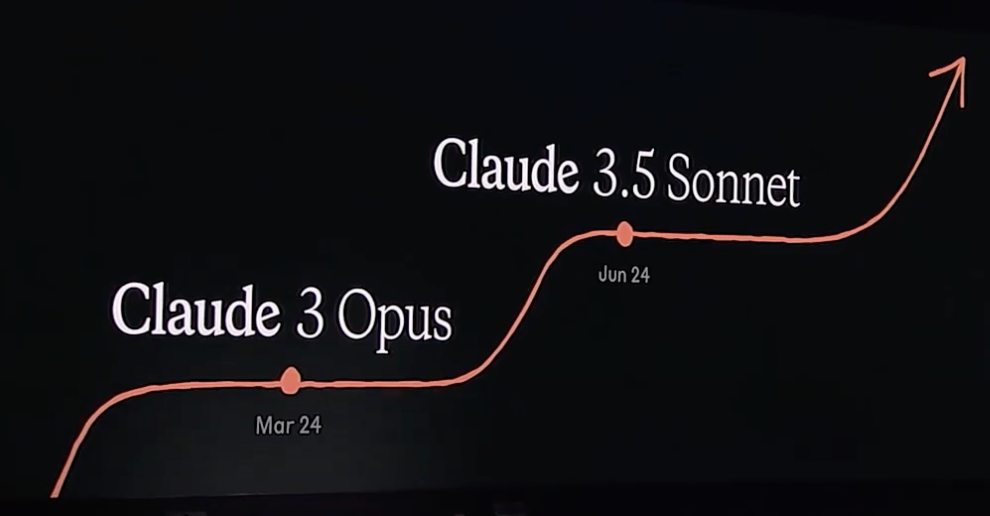

基調講演中でAnthropic社の共同創設者の1人であるTom Brown氏が登場しました。

Anthoropic社のClaude3.5 HaikuはTrainium2基盤だと60%も速度を向上されることをアピールしていました。

まとめ

生成AIの高速化、高度化にはハードウェア基盤の技術革新が重要な役割を占めていることが分かった基調講演となりました。

後記

基調講演の前座で出演していたバンドのパフォーマンスも見ることができました。

カバー曲が多かったですが、コミカルな動きが地味にハマってしまいましたw

調べても出てこなかったのでこのバンドの名前が分かった方がいれば教えてくださいw

![【AWS re:Invent 2024】VPCの階層化セキュリティへのアプローチ [NET303]](https://iret.media/wp-content/uploads/2024/11/eyecatch-128810-220x124.png)

![【AWS re:Invent 2024】Amazon.comがどのようにAWSリージョンを利用して顧客体験を向上させているか [ARC328]](https://iret.media/wp-content/uploads/2024/12/eyecatch-129642-220x124.png)

![【AWS re:Invent 2024】オンプレミスの VMware ワークロードを AWS Outposts に段階的に移行する [HYB303]](https://iret.media/wp-content/uploads/2024/12/eyecatch-129645-1-220x124.png)

![【AWS re:Invent 2024】AWS環境を最適化するために知っておくべきテクニック [NTA405]](https://iret.media/wp-content/uploads/2024/12/eyecatch-129655-1-220x124.png)

![【AWS re:Invent 2024】Amazon Aurora Serverless でスケーラブルかつコスト最適化されたアプリを構築 [DAT316]](https://iret.media/wp-content/uploads/2024/12/eyecatch-129667-1-220x124.png)