はじめに

こんにちは、何かに影響されてりんごを齧りながらブログを書いているヤマダ(北野)です。

この記事は「GenAI, Hold the Waste: How H2O Fixed Its Storage Bottleneck (sponsored by Datafy) (STG204-S)」のセッションレポートです。

H2O.aiのOphirさんとDatafy.ioのZivanさんが、AIワークロードに最適化されたストレージの自動スケーリングソリューションについて紹介していました。

概要

Generative AI demands fast, flexible, and cost-efficient infrastructure. In this joint session, H2O.ai shares how they support rapid growth in AI workloads by leveraging Datafy’s autonomous storage scaling. As customer adoption of GenAI surged, so did block storage needs, along with cost and complexity. Learn how Datafy helped H2O.ai slash EBS waste, maintain performance, and scale seamlessly, all with zero downtime and near-instant deployment. Walk away with practical insights into architecting a resilient storage layer that adapts to unpredictable GenAI workloads without overprovisioning or firefighting. This presentation is brought to you by Datafy, an AWS Partner.

Generative AIのシステムは速くて使いやすく、お金のかからないインフラが求められます。このセッションでは、H2O.aiがDatafyの自動ストレージスケーリングを活用し、AIの作業量増加に対応した事例が共有されました。顧客がGenAIを使い始めるにつれてブロックストレージの必要性、コスト、管理の複雑さが急増します。

DatafyはH2O.aiがEBSのムダを減らし、性能を保ちながら、システムを止めずにスムーズに容量を調整できるよう手助けしました。2ペタバイトのストレージを1ペタバイト未満に削減し、容量使用率を25%から80%に改善したという具体的な成果がでたそうです。

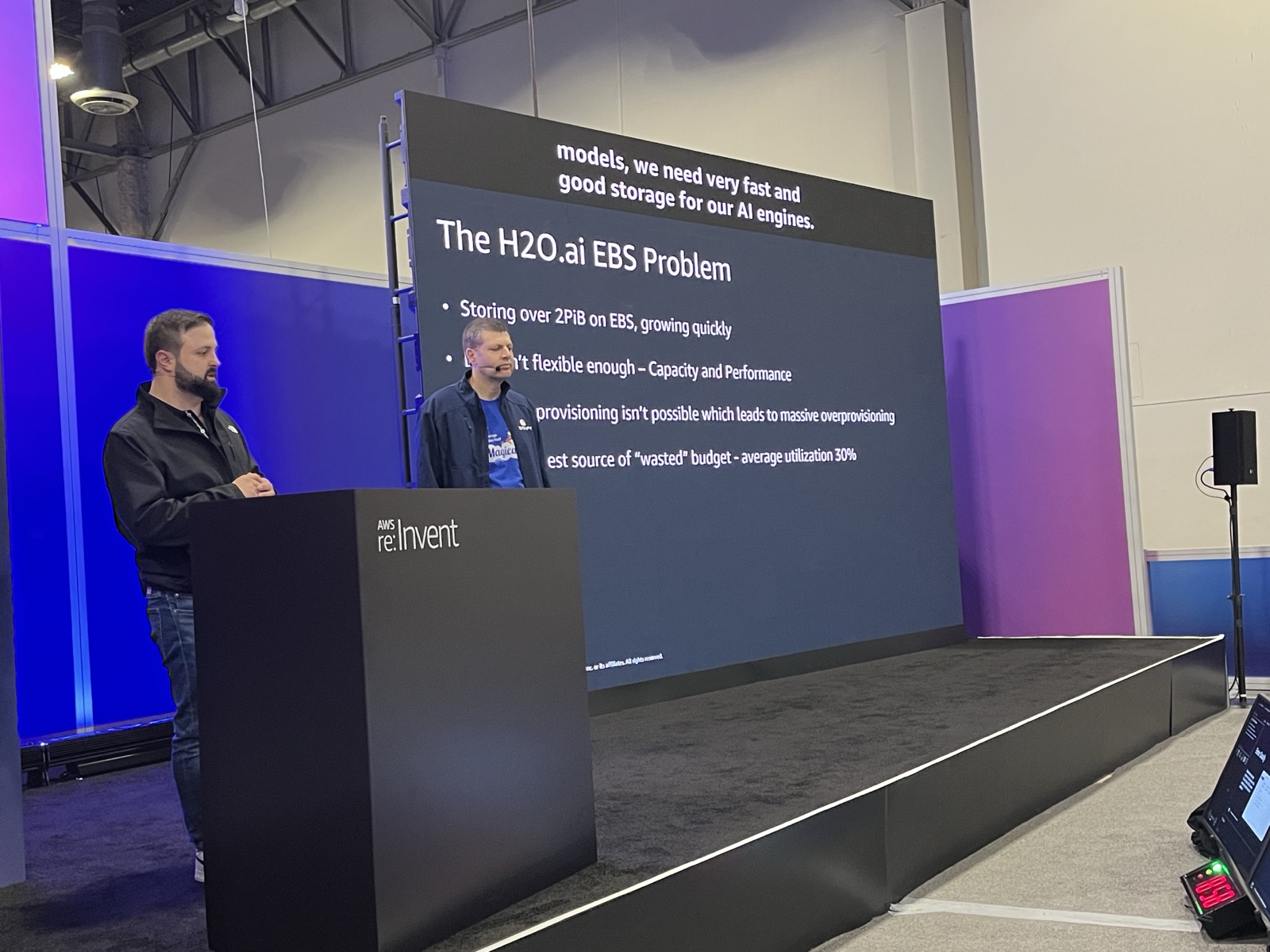

H2O.aiが抱えていた課題

AIプラットフォームを提供するH2O.aiは、システム全体をKubernetes(EKS)上で動かしており、速いストレージとしてEBSに大きく頼っていました。

このシステムの最大の問題は使っていないストレージが多すぎることでした。2ペタバイト以上のストレージを使っていましたが、実際に使っているのは一部で多くの容量がお金とリソースのムダになっていたそうです。さらに、EBSは一度容量を増やすと減らせないため、最初に多めに確保するとコストが増え続けるという困った点がありました。

EBSの容量を減らせない問題は本当に悩ましいですね。AIデータを扱う多くの企業がこの課題に直面しているかもと感じました。

Datafyとは何か?

DatafyはAWSユーザー向けのクラウドストレージを自動で賢く管理するソリューションです。H2O.aiが抱えていたような「多すぎるEBS容量」や「ムダなリソース」といった問題を解決するために作られました。

Datafyの特徴は動的な自動スケーリングです。ファイルが増えて容量がいっぱいになると自動で広がり、ファイルが消えて空きが増えると自動で縮みます。しかもダウンタイムなしで導入でき、既存のシステムに手を加える必要がないのが大きな強みです。

「ダウンタイムゼロ」でストレージの最適化ができるのは、本番環境にとって何より重要だと思います。

DatafyはEC2サーバーやKubernetesの中にインストールする エージェントをベースに動きます。このエージェントがアプリケーションの動作に影響を与えずにEBSボリュームのサイズを自動で変えることでストレージの効率を上げます。

H2O.aiがDatafy導入時に直面した課題

Datafyの導入にあたっては、いくつかの技術的な問題をDatafyと一緒に乗り越えました。

- Bottlerocketへの対応: EKSで使っていたBottlerocketでDatafyのプログラムが動くように協力して開発しました。

- セキュリティの確保: 顧客のデータを守るため、Datafyの管理システムが実際のデータをクラスタの外に出さないことを確認して高いセキュリティレベルを維持しました。

- 既存のバックアップツールの継続利用: すでに使っていたVeleroをそのまま使い続けられるよう互換性を確保しました。

既存のツールやセキュリティルールを変えずに導入できる点はやはり重要ですね。

実際の最適化結果

Datafyの導入によってストレージの使用状況は大きく改善しました。

- 容量使用率の改善: 導入前の使用率は25%でしたが、最終的に約80%で安定しました。これはムダを大幅に減らしつつ、容量不足にならないように少しバッファを持たせた理想的な状態です。

- 総容量の削減: 導入前の総容量は約2ペタバイトでしたが、自動スケーリングによって1ペタバイト未満にまで減りました。これによりH2O.aiは払うお金を半分以下にすることができました。

H2O.aiでの導入結果

最終的にH2O.aiはDatafyの導入で以下の結果を得ました。

- 既存ツールとのスムーズな連携: 開発手順を大きく変えることなく導入できました。

- 大幅なコスト削減

- パフォーマンスの向上: お金を節約できただけでなく、なぜかお客様へのサービス速度も速くなりました。

- システムを止めずに導入: Datafyのプログラムをインストールした後、スイッチを一つ切り替えるだけで手作業なしに自動でストレージのムダを減らし始めたそうです。

コストが下がって性能も上がるというのはまさに理想的なソリューション。「スイッチを入れるだけで魔法のように」という言葉が印象的でした。

まとめ

今回の話で一番すごいと思ったのは、「使ってないストレージが多すぎる状態(25%)」から、「ムダがなく効率の良い状態(80%)」に改善できたという具体的な数字です。AIのデータ量はどれくらい増えるか予想しにくいので多めに用意してお金がかさむのは仕方がないことです。

それをシステムを一切止めずに、すでに使っているツールをそのまま利用しながら解決できた事例です。「スイッチ一つで効果が出た」という話を聞いて、ストレージの最適化がすごく手間のかかる作業ではなく簡単に実現できる時代になったんだなと感じました。

お金を大きく節約できるだけでなくてサービスのスピードも上がったという結果も驚きでした。私も宝くじに当たるだけでなく、すごい健康体にもなりたいです。

こういった無駄をなくす作業はあまり経験がないので、まずは自分の個人アカウントから取り組んでみようと思います。