はじめに

- こんにちは、エンタープライズクラウド事業部の新川です。先月5月23日に開催されたOracleのDeveloper Day 2025 に参加しました。今年のDeveloper Day 2025は、日本オラクル株式会社でオフラインのみ開催されました。私がオラクル青山センターにお邪魔するのは10年ぶり。おひさしぶりで、テンション上がります!

- 本記事では、そのイベントレポートとして、印象的だったセッションの内容をご紹介します。

- 先ず1つ目の投稿は、14:10–14:50 に行われたブレイクアウトセッション [T2-1] のレポートになります。

- タイトル: OCI Kubernetes Engine (OKE)で実現する超スケーラブルなAIプラットフォーム 〜 24,000 GPU K8sクラスタ

- スピーカー: 日本オラクル株式会社 古手川様

セッション概要

- このセッションでは、AIモデルの学習・推論プラットフォームに、Kubernetes を選択する理由、OCI/OKE を選択する理由の説明がありました。

- OKEに関する知識がなかった私にとって、このセッションは多くの「なるほど!」という発見がありました。特に以下の点が大きな収穫でした。

- 大規模にGPUを利用する多くの顧客で、AI基盤にOKE(OCI Kubernetes Engine)が利用されている点

- OKE のインフラを構成するクラスタ、ネットワーク、ストレージの具体的な特長と、それらがAI基盤にどう貢献するか

- OKE を活用したGPUクラスタ構築におけるノウハウ

OKE とは?基本をおさらい

- セッション内容に入る前に、まずはOKEの基本的な知識をおさらいしましょう。OKE の正式名称は、「Oracle Cloud Infrastructure Container Engine for Kubernetes」です。

- これは、Oracle Cloud Infrastructure(OCI)が提供するマネージドのKubernetes サービスで、コンテナ化されたアプリケーションを構築し、運用・管理を容易にするサービスです。

- Kubernetesの管理をOKE に任せることで、ユーザーはインフラの複雑さから解放され、アプリケーション開発やAIモデルの学習・推論といった本来の業務に集中できます。

- すでに多くの企業において、AIインフラストラクチャとしてOKE が選択されているとのことです。

- OKE の概要について、詳しくは以下をご参照ください。

- Oracle 公式ページ https://www.oracle.com/jp/cloud/cloud-native/kubernetes-engine/

- Oracle Container Engine for Kubernetes (OKE) 概要のスライド https://speakerdeck.com/oracle4engineer/oke-overview

なるほど。OKE インフラの魅力!

- このセッションで紹介されたOKE のクラウド基盤、OCI Supercluster の特長を以下に記載します。

- GPU を最大限活用するクラウド基盤:OCI Supercluster

- OCI Superclusterの主要なアピールポイントは、以下の3つです。

- NVIDIA のリファレンス設計に従ったベアメタルGPUサーバーを使用し、最大で131,072 GPU を使用した単一のクラスタを構成可能。高いAI学習性能を実現し、かつ実装コストも削減できる。

- 最大61.4 TBのNVMe SSDストレージを搭載。さらに高性能な共有ストレージ・サービスも提供。高速ストレージで、GPUへのデータ入力や学習時のチェックポイントを高速化できる。

- GPUサーバー間を数μ秒、最大28.8 Tbps の高帯域で接続した超低遅延のネットワーク。RoCEv2 RDMAネットワークを実装してパフォーマンスをスケール。AI学習時間の短縮が可能になる。(RDMA:Remote Direct Memory Access、RoCEv2:RDMA over Converged Ethernet version 2)

- 驚きです。OCI Supercluster で作るクラスタには、これだけ多くの数のGPU が使用できるのですね! まさに、データセンターに並ぶサーバー、ストレージ群が目に浮かぶようです。

GPUクラスタ構築のノウハウ

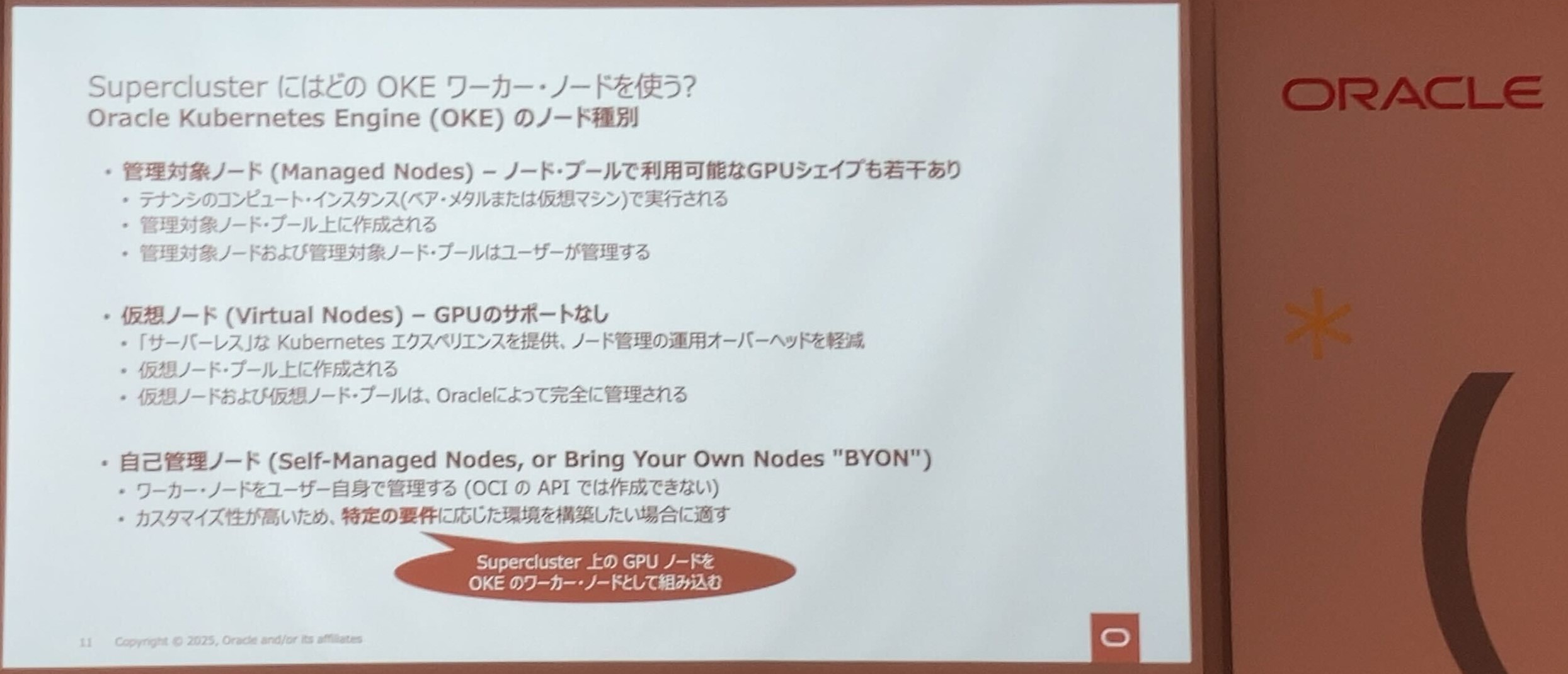

- 今回のセッションでは、Supercluster のコンピュートインスタンスをOKE のワーカーノードとして組み込む方法が具体的に紹介されました。

- OKEクラスタにはコントロールプレーンとデータプレーンがあり、データプレーンはワーカーノード(アプリケーションが実行されるPod を動作させるコンポーネント)で構成されます。

- 一般的にOKE のワーカーノードには、仮想ノード、管理対象ノード、自己管理ノードの 3種類があります。自己管理ノードは、顧客が作成したインスタンスをノードとして使用する方法となりますが、Supercluster上のGPUノードをワーカーノードとして組み込むには、自己管理ノードを使用することになります。

- 通常、OKE ではPod にNIC を1つしか構成することができません。しかし、Supercluster の特徴であるRDMA(Remote Direct Memory Access)を活用するためには、複数のNICやRDMAに対応したPodの構築が必要です。

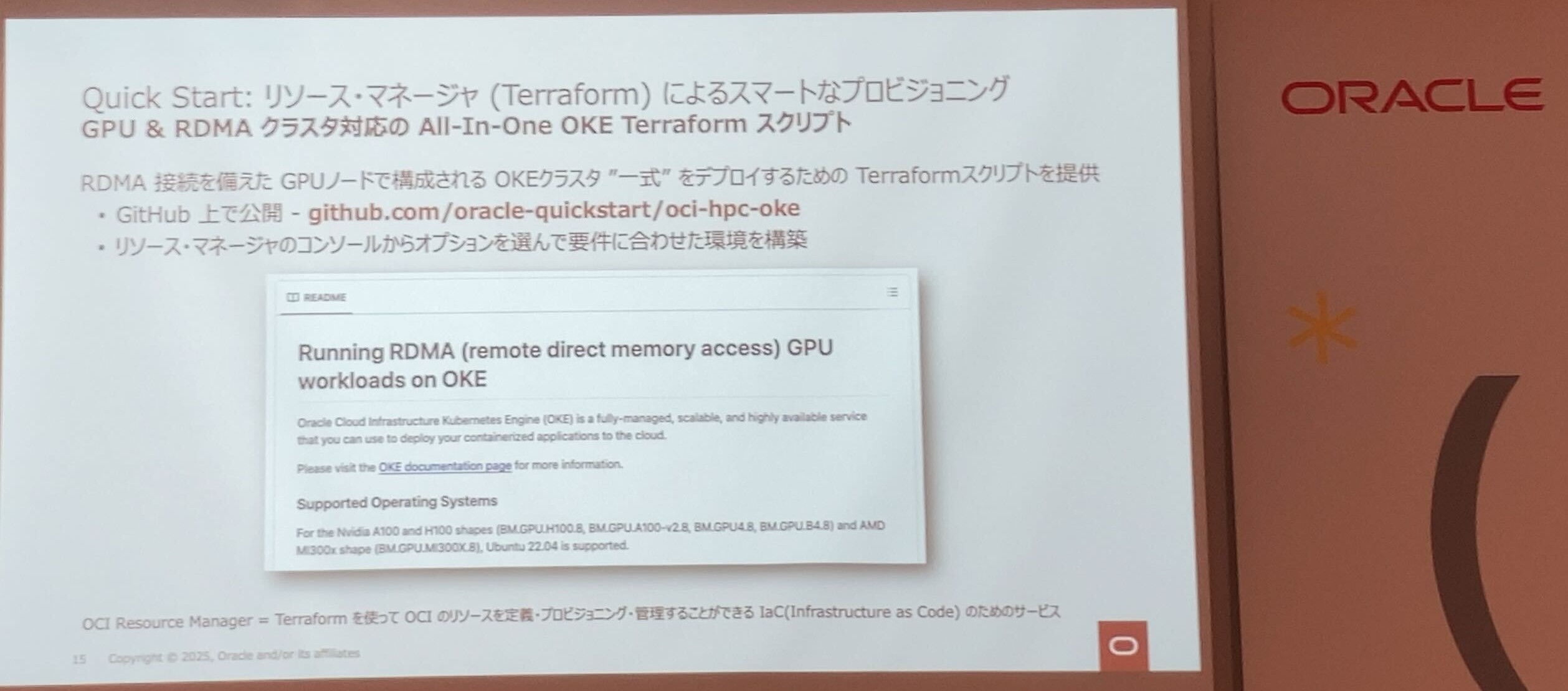

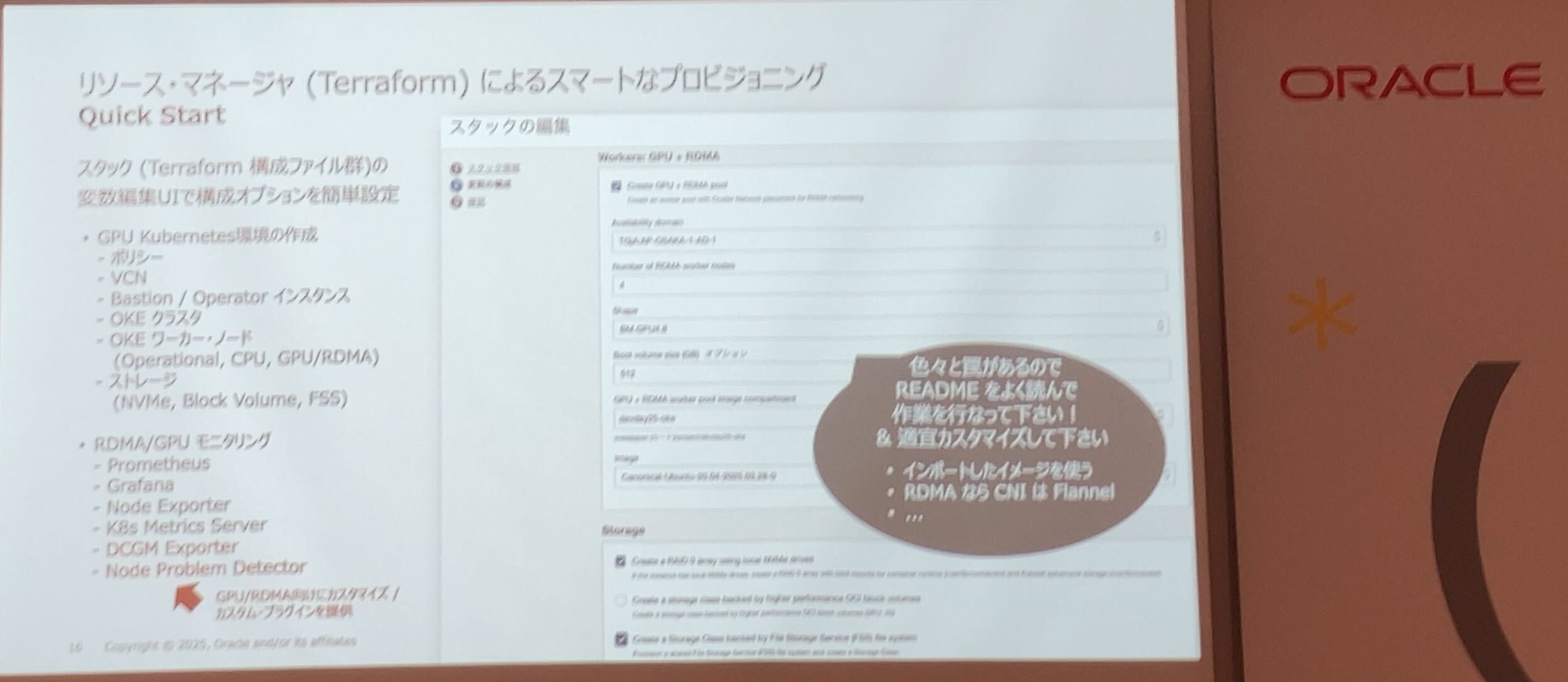

- これを実現するために、「Terraform OCI module for OKE」が紹介されました。これは、RDMA 接続を備えたGPUノードで構成されるOKEクラスタをデプロイするためのTerraformスクリプトです。

- さらに、OCIリソースのプロビジョニングを自動化できるサービスである「OCI Resource Manager」を使用することで、Terraform構成ファイルをアップロードして、OCIリソースをスマートに構築できます。

- Terraformスクリプトは、以下のリンクから提供されます。

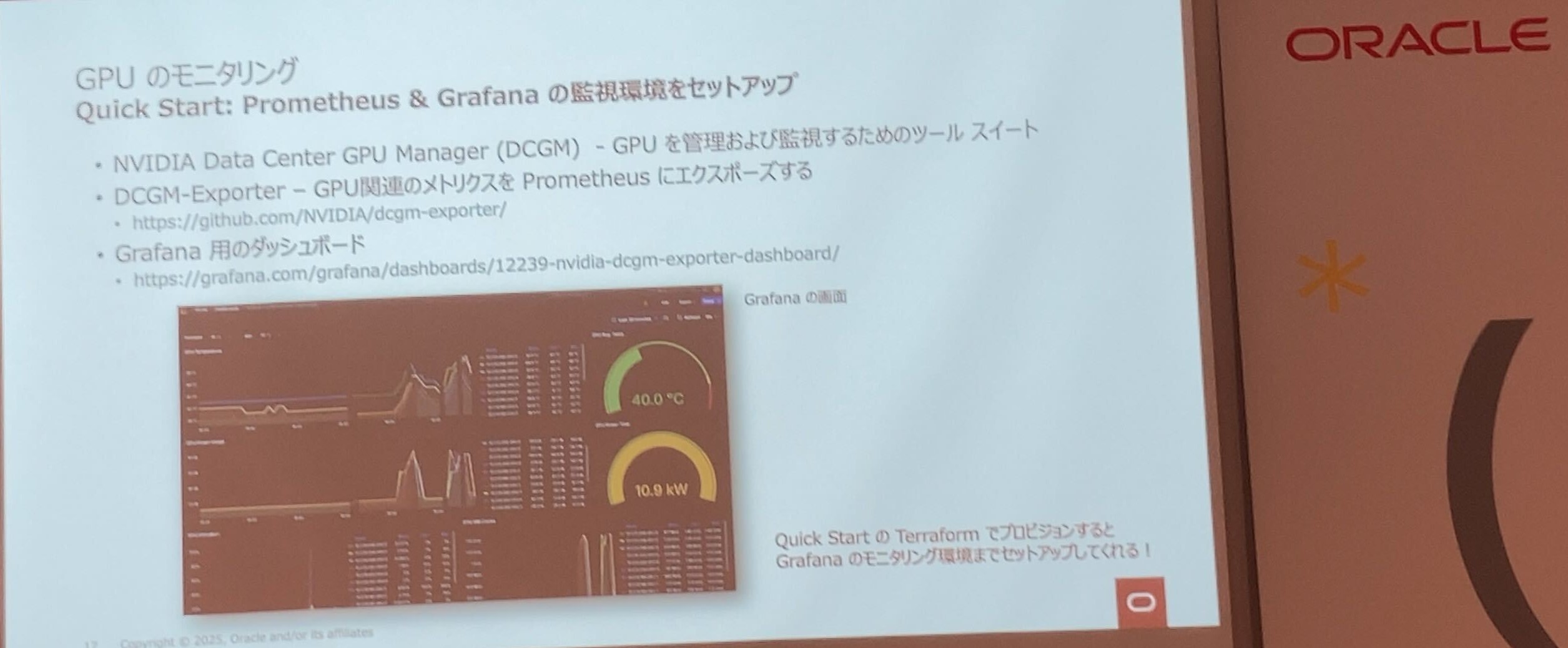

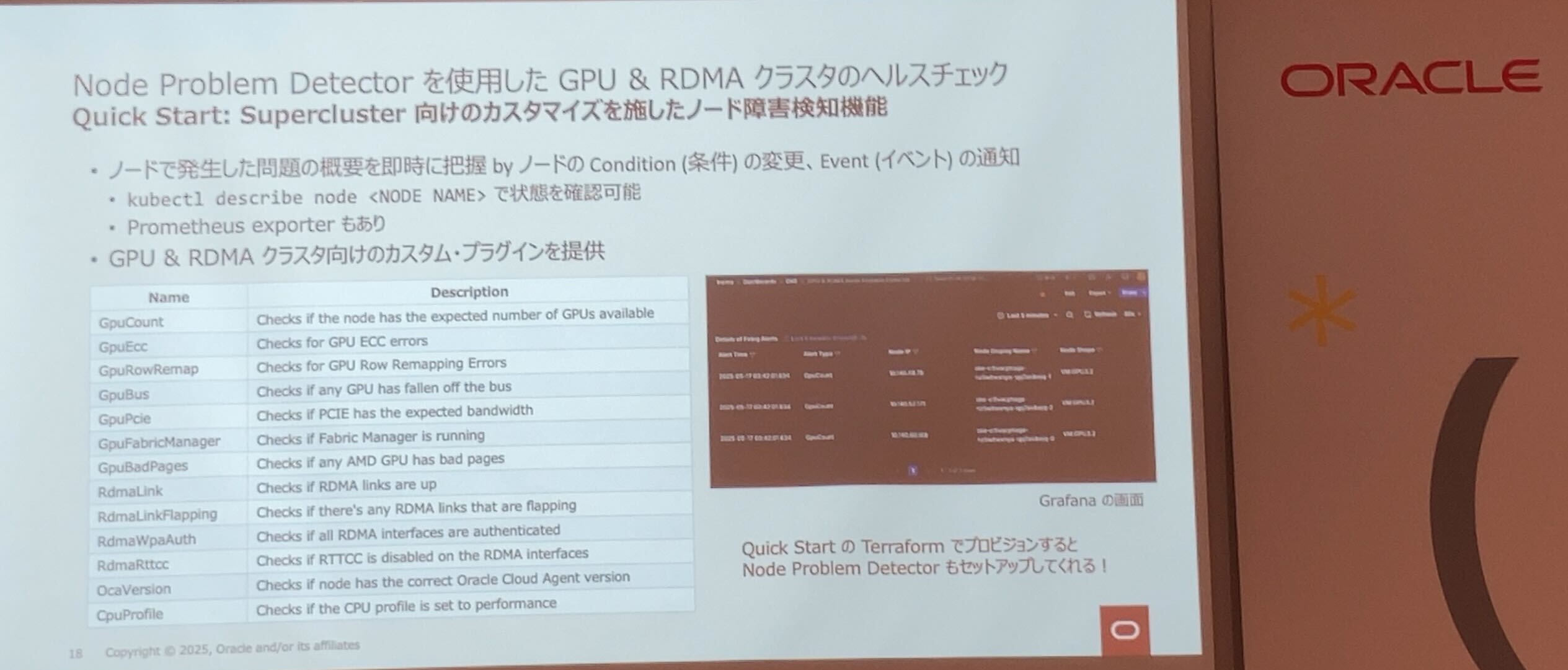

- Quick Startを利用することで、GPU のモニタリングやGPU & RDMA のヘルスチェックも簡単にセットアップできるとのことでした。

- GPU関連のメトリクスをPrometheus にエクスポートし、Grafanaのダッシュボードで視覚的に表示できます。これにより、GPUの利用状況をリアルタイムで把握し、最適な運用に繋げられます。

- Node Problem Detector を使用することで、Supercluster向けにカスタマイズされたノード障害検知機能が利用できます。これにより、システムの安定稼働をサポートします。

OKE 解説の資料

- より詳細な内容は、以下のセッションスライドで公開されていますので、ぜひご参照ください。

まとめ

- 今回のセッションを通して、私が感じたOKE の魅力をまとめると、以下の3点です。

- OKEには、OCI Superclusterと呼ばれるクラウド基盤があり、GPUの性能を発揮するための高性能なハードウェア(GPU、Storage、Networking)が最適に設計されており、高いAI学習性能を提供している。

- OKEクラスタをプロビジョニングするためのTerraform スクリプトやQuick Startが提供されており、GPU & RDMA を使用した環境構築が自動化されている。

- OKEでは、PrometheusやGrafanaといった監視ツール、Node Problem Detectorを使用したノード障害検知機能など、Kubernetesのエコシステムで広く採用されている仕組みを活かしつつ、OKE向けにカスタマイズされ利用できる。

押さえておきたい!

- 最後に、今回のセッションのスピーカーである古手川様が主催されている、Oracle Cloud の勉強会 「OCHa Cafe」についてもご紹介します。ご興味のある方は、ぜひチェックしてみてください。

Oracle Cloud Hangout Cafe、略してOCHa Cafe(おちゃかふぇ)

https://www.oracle.com/jp/developer/events/cloud-hangout-cafe/

https://ochacafe.connpass.com/